この日本語マニュアルは、https://docs.openvino.ai/2024/home.html で公開されている「OpenVINO 2024.0 ドキュメント」(2024/3/11 時点) をインテル社の許可を得て iSUS (IA Software User Society) が翻訳した参考訳です。

原文は更新される可能性があります。原文と翻訳文の内容が異なる場合は原文を優先してください。

本ドキュメント内で使用されている製品名は正式名称ではありません。正式名称については各社のページをご確認ください。また、用語や表記など、インテル社のスタイル・ガイドラインに沿っていない可能性があることを予めご了承ください。

本ドキュメントには一部英語のページが残っており、英語ページを開くと左フレームのメニューが英語表記になります。その場合は、ブラウザーの戻るボタンで日本語ページに戻ることができます。

OpenVINO 2024¶

OpenVINO と OpenVINO モデルサーバーの最新のベンチマーク値を確認します。

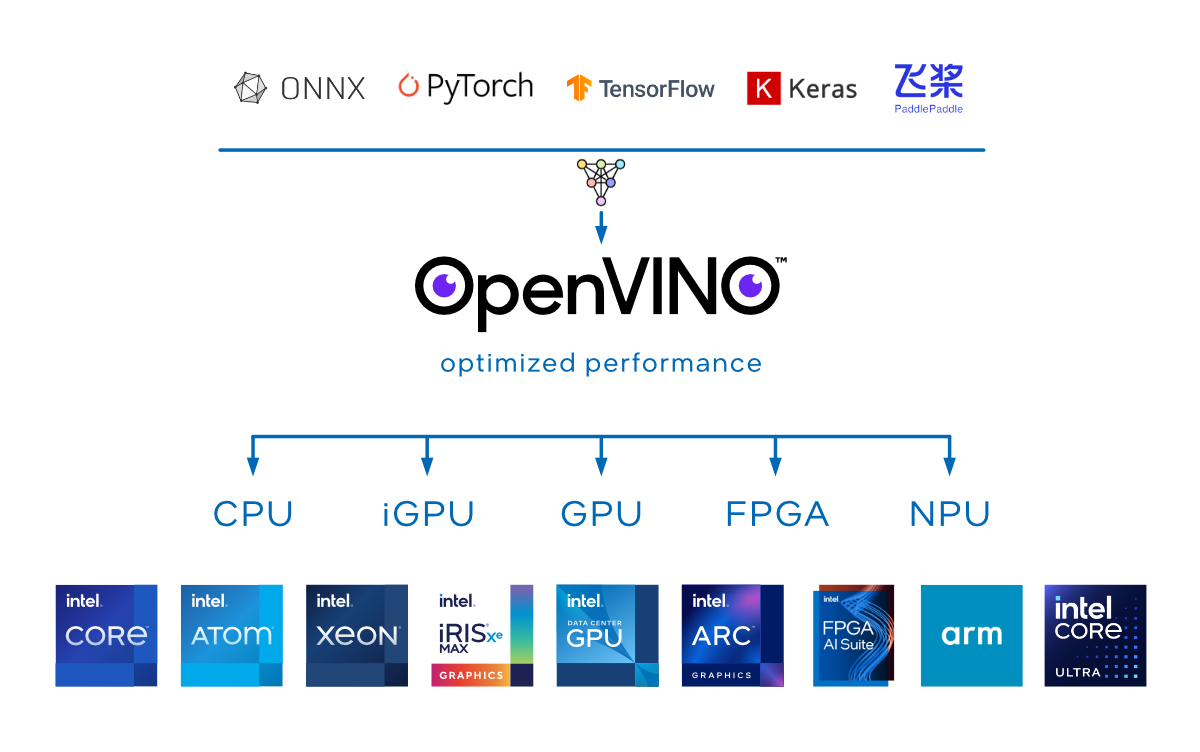

OpenVINO でサポートされるモデル形式には、PyTorch、TensorFlow、TensorFlow Lite、ONNX、および PaddlePaddle が含まれます。

マイクロサービス・アプリケーション向けのクラウド対応のデプロイ

NNCF による量子化と圧縮を使用してパフォーマンスを向上します。

PyTorch 2.0 torch.compile() バックエンドを使用してグラフモデルの生成を最適化します。

生成 AI の効率を向上します。

機能概要¶

OpenVINO ランタイムに直接リンクして推論をローカルで実行することも、OpenVINO モデルサーバーを使用して別のサーバーや Kubernetes 環境からモデル推論を提供することもできます。

アプリケーションを一度作成すれば、どこにでもデプロイでき、ハードウェアから最大限のパフォーマンスを引き出すことができます。自動デバイス検出により、導入の柔軟性を高めます。OpenVINO ランタイムは、Linux*、Windows*、MacOS* をサポートし、Python、C++、C API を提供します。使いやすい言語と OS を使用できます。

外部依存関係を最小限にするように設計されているため、アプリケーションのフットプリントが削減され、インストールと依存関係の管理が容易です。一般的なパッケージ・マネージャーを使用して、アプリケーションの依存関係を容易にインストールおよびアップグレードできます。特定のモデルをカスタムコンパイルすることで、最終的なバイナリーサイズはさらに小さくなります。

高速起動が必要なアプリケーションでは、OpenVINO は最初の推論には CPU を使用し、モデルがコンパイルされメモリーにロードされると別のデバイスに切り替えます。コンパイルされたモデルはキャッシュされ、起動時間がさらに短縮されます。