OpenVINO™ を使用した YOLOv8 リアルタイム物体検出の変換と最適化¶

この Jupyter ノートブックはオンラインで起動でき、ブラウザーのウィンドウで対話型環境を開きます。ローカルにインストールすることもできます。次のオプションのいずれかを選択します。

リアルタイムの物体検出は、コンピューター・ビジョン・システムの主要コンポーネントとして使用されます。リアルタイム物体検出モデルを使用するアプリケーションには、ビデオ分析、ロボット工学、自動運転車、複数物体の追跡と物体の計数、医療画像分析などがあります。

このチュートリアルでは、OpenVINO を使用して PyTorch YOLOv8 を実行および最適化する手順を段階的に説明します。オブジェクト検出シナリオに必要な手順を検討します。

チュートリアルは次の手順で構成されています。

- PyTorch モデルを準備します。

- データセットをダウンロードして準備します。

- 元のモデルを検証します。

- PyTorch モデルを OpenVINO IR に変換します。

- 変換されたモデルを検証します。

- 最適化パイプラインを準備して実行します。

- FP32 モデルと量子化モデルのパフォーマンスを比較します。

- FP32 モデルと量子化モデルの精度を比較します。

- OpenVINO API によるその他の最適化の可能性

- ライブデモ

目次¶

PyTorch モデルの取得¶

一般に、PyTorch モデルは、モデルの重みを含む状態辞書によって初期化された torch.nn.Module クラスのインスタンスを表します。このリポジトリーで入手可能な、COCO データセットで事前トレーニングされた YOLOv8 nano モデル (yolov8n とも呼ばれる) を使用します。この手順は他の YOLOv8 モデルにも適用できます。事前トレーニングされたモデルを取得する一般的な手順は次のとおりです。

- クラスのインスタンスを作成します。

- 事前トレーニングされたモデルの重みを含むチェックポイント状態辞書をロードします。

- 一部の操作を推論モードに切り替えるためモデルを評価に切り替えます。

この場合、モデルの作成者は、YOLOv8 モデルを ONNX に変換してから OpenVINO IR に変換できる API を提供します。したがって、これらの手順を手動で実行する必要はありません。

必要条件¶

必要なパッケージをインストールします。

%pip install -q "openvino>=2023.1.0" "nncf>=2.5.0"

%pip install -q "torch>=2.1" "torchvision>=0.16" "ultralytics==8.0.43" onnx --extra-index-url https://download.pytorch.org/whl/cpu

必要なユーティリティー関数をインポートします。下のセルは、GitHub から notebook_utils Python モジュールをダウンロードします。

from pathlib import Path

# Fetch the notebook utils script from the openvino_notebooks repo

import urllib.request

urllib.request.urlretrieve(

url='https://raw.githubusercontent.com/openvinotoolkit/openvino_notebooks/main/notebooks/utils/notebook_utils.py',

filename='notebook_utils.py'

)

from notebook_utils import download_file, VideoPlayer

描画結果のユーティリティー関数を定義

from typing import Tuple, Dict

import cv2

import numpy as np

from ultralytics.yolo.utils.plotting import colors

def plot_one_box(box:np.ndarray, img:np.ndarray,

color:Tuple[int, int, int] = None,

label:str = None, line_thickness:int = 5):

"""

Helper function for drawing single bounding box on image

Parameters:

x (np.ndarray): bounding box coordinates in format [x1, y1, x2, y2]

img (no.ndarray): input image

color (Tuple[int, int, int], *optional*, None): color in BGR format for drawing box, if not specified will be selected randomly

label (str, *optonal*, None): box label string, if not provided will not be provided as drowing result

line_thickness (int, *optional*, 5): thickness for box drawing lines

"""

# Plots one bounding box on image img

tl = line_thickness or round(0.002 * (img.shape[0] + img.shape[1]) / 2) + 1 # line/font thickness

color = color or [random.randint(0, 255) for _ in range(3)]

c1, c2 = (int(box[0]), int(box[1])), (int(box[2]), int(box[3]))

cv2.rectangle(img, c1, c2, color, thickness=tl, lineType=cv2.LINE_AA)

if label:

tf = max(tl - 1, 1) # font thickness

t_size = cv2.getTextSize(label, 0, fontScale=tl / 3, thickness=tf)[0]

c2 = c1[0] + t_size[0], c1[1] - t_size[1] - 3

cv2.rectangle(img, c1, c2, color, -1, cv2.LINE_AA) # filled

cv2.putText(img, label, (c1[0], c1[1] - 2), 0, tl / 3, [225, 255, 255], thickness=tf, lineType=cv2.LINE_AA)

return img

def draw_results(results:Dict, source_image:np.ndarray, label_map:Dict):

"""

Helper function for drawing bounding boxes on image

Parameters:

image_res (np.ndarray): detection predictions in format [x1, y1, x2, y2, score, label_id]

source_image (np.ndarray): input image for drawing

label_map; (Dict[int, str]): label_id to class name mapping

Returns:

Image with boxes

"""

boxes = results["det"]

for idx, (*xyxy, conf, lbl) in enumerate(boxes):

label = f'{label_map[int(lbl)]} {conf:.2f}'

source_image = plot_one_box(xyxy, source_image, label=label, color=colors(int(lbl)), line_thickness=1)

return source_image

# Download a test sample

IMAGE_PATH = Path('./data/coco_bike.jpg')

download_file(

url='https://storage.openvinotoolkit.org/repositories/openvino_notebooks/data/data/image/coco_bike.jpg',

filename=IMAGE_PATH.name,

directory=IMAGE_PATH.parent

)

'data/coco_bike.jpg' already exists.

PosixPath('/home/ea/work/openvino_notebooks/notebooks/230-yolov8-optimization/data/coco_bike.jpg')

モデルのインスタンス化¶

元のリポジトリーには、さまざまなタスクを対象とした複数のモデルが用意されています。モデルをロードするには、モデル・チェックポイントへのパスを指定する必要があります。モデルハブで使用可能なローカルパスまたは名前にすることができます (この場合、モデル・チェックポイントは自動的にダウンロードされます)。

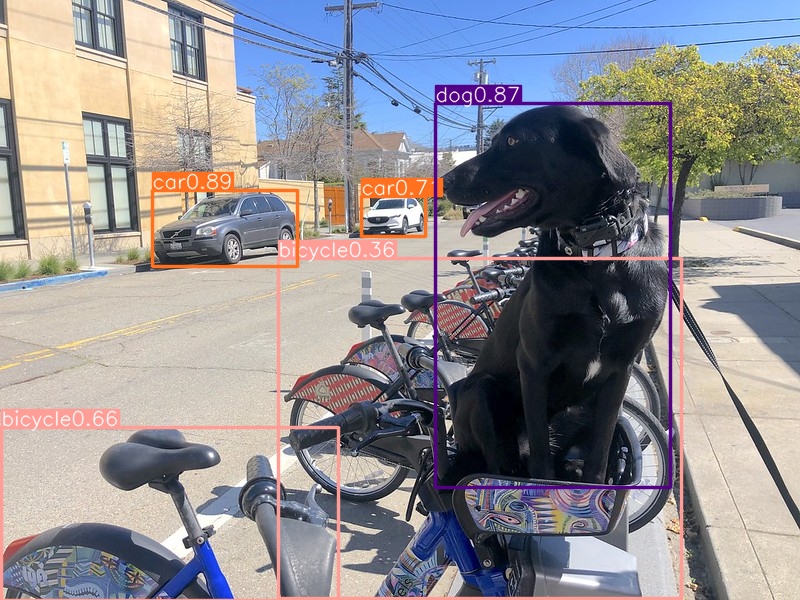

予測を行う際、モデルは入力画像へのパスを受け入れ、Results クラス・オブジェクトを含むリストを返します。結果には、オブジェクト検出モデルのボックスが含まれます。また、描画用の plot() メソッドなど、結果を処理するユーティリティーも含まれています。

例を考えてみましょう。

models_dir = Path('./models')

models_dir.mkdir(exist_ok=True)

from PIL import Image

from ultralytics import YOLO

DET_MODEL_NAME = "yolov8n"

det_model = YOLO(models_dir / f'{DET_MODEL_NAME}.pt')

label_map = det_model.model.names

res = det_model(IMAGE_PATH)

Image.fromarray(res[0].plot()[:, :, ::-1])

2023-10-05 19:15:51.230030: I tensorflow/core/util/port.cc:110] oneDNN custom operations are on. You may see slightly different numerical results due to floating-point round-off errors from different computation orders. To turn them off, set the environment variable TF_ENABLE_ONEDNN_OPTS=0. 2023-10-05 19:15:51.269549: I tensorflow/core/platform/cpu_feature_guard.cc:182] This TensorFlow binary is optimized to use available CPU instructions in performance-critical operations. To enable the following instructions: AVX2 AVX512F AVX512_VNNI FMA, in other operations, rebuild TensorFlow with the appropriate compiler flags. 2023-10-05 19:15:51.909328: W tensorflow/compiler/tf2tensorrt/utils/py_utils.cc:38] TF-TRT Warning: Could not find TensorRT Ultralytics YOLOv8.0.43 🚀 Python-3.8.10 torch-2.0.1+cpu CPU YOLOv8n summary (fused): 168 layers, 3151904 parameters, 0 gradients, 8.7 GFLOPs image 1/1 /home/ea/work/openvino_notebooks/notebooks/230-yolov8-optimization/data/coco_bike.jpg: 480x640 2 bicycles, 2 cars, 1 dog, 48.7ms Speed: 2.6ms preprocess, 48.7ms inference, 1.3ms postprocess per image at shape (1, 3, 640, 640)

モデルを OpenVINO IR に変換¶

YOLOv8 は、OpenVINO IR を含むさまざまな形式にモデルをエクスポートする便利な API を提供します。model.export はモデルの変換を担当します。形式を指定する必要があり、さらにモデル内の動的な形状を保持することもできます。

# object detection model

det_model_path = models_dir / f"{DET_MODEL_NAME}_openvino_model/{DET_MODEL_NAME}.xml"

if not det_model_path.exists():

det_model.export(format="openvino", dynamic=True, half=False)

モデルの推論を検証¶

モデルの動作をテストするため、model.predict メソッドに似た推論パイプラインを作成します。パイプラインは、前処理ステップ、OpenVINO モデルの推論、および結果を取得する後処理で構成されます。

前処理¶

モデル入力は、[-1, 3, -1, -1] の形状を持つテンソルで、N, C, H, W 形式です。

説明:

N- バッチ内の画像数 (バッチサイズ)C- 画像チャネルH- 画像の高さ-

W- 画像の幅

モデルは、RGB チャネル形式で [0, 1] の範囲で正規化された画像を想定しています。モデルは入力の割り切れる数を 32 に維持しながら動的な入力形状をサポートしますが、効率を高めるには 640x640 などの静的な形状を使用することをお勧めします。モデルのサイズに合わせて画像のサイズを変更するには、幅と高さのアスペクト比が維持されるレターボックスのサイズ変更アプローチが使用されます。

特定の形状を維持するため、前処理によってパディングが自動的に有効になります。

from typing import Tuple

from ultralytics.yolo.utils import ops

import torch

import numpy as np

def letterbox(img: np.ndarray, new_shape:Tuple[int, int] = (640, 640), color:Tuple[int, int, int] = (114, 114, 114), auto:bool = False, scale_fill:bool = False, scaleup:bool = False, stride:int = 32):

"""

Resize image and padding for detection. Takes image as input,

resizes image to fit into new shape with saving original aspect ratio and pads it to meet stride-multiple constraints

Parameters:

img (np.ndarray): image for preprocessing

new_shape (Tuple(int, int)): image size after preprocessing in format [height, width]

color (Tuple(int, int, int)): color for filling padded area

auto (bool): use dynamic input size, only padding for stride constrins applied

scale_fill (bool): scale image to fill new_shape

scaleup (bool): allow scale image if it is lower then desired input size, can affect model accuracy

stride (int): input padding stride

Returns:

img (np.ndarray): image after preprocessing

ratio (Tuple(float, float)): hight and width scaling ratio

padding_size (Tuple(int, int)): height and width padding size

"""

# Resize and pad image while meeting stride-multiple constraints

shape = img.shape[:2] # current shape [height, width]

if isinstance(new_shape, int):

new_shape = (new_shape, new_shape)

# Scale ratio (new / old)

r = min(new_shape[0] / shape[0], new_shape[1] / shape[1])

if not scaleup: # only scale down, do not scale up (for better test mAP)

r = min(r, 1.0)

# Compute padding

ratio = r, r # width, height ratios

new_unpad = int(round(shape[1] * r)), int(round(shape[0] * r))

dw, dh = new_shape[1] - new_unpad[0], new_shape[0] - new_unpad[1] # wh padding

if auto: # minimum rectangle

dw, dh = np.mod(dw, stride), np.mod(dh, stride) # wh padding

elif scale_fill: # stretch

dw, dh = 0.0, 0.0

new_unpad = (new_shape[1], new_shape[0])

ratio = new_shape[1] / shape[1], new_shape[0] / shape[0] # width, height ratios

dw /= 2 # divide padding into 2 sides

dh /= 2

if shape[::-1] != new_unpad: # resize

img = cv2.resize(img, new_unpad, interpolation=cv2.INTER_LINEAR)

top, bottom = int(round(dh - 0.1)), int(round(dh + 0.1))

left, right = int(round(dw - 0.1)), int(round(dw + 0.1))

img = cv2.copyMakeBorder(img, top, bottom, left, right, cv2.BORDER_CONSTANT, value=color) # add border

return img, ratio, (dw, dh)

def preprocess_image(img0: np.ndarray):

"""

Preprocess image according to YOLOv8 input requirements.

Takes image in np.array format, resizes it to specific size using letterbox resize and changes data layout from HWC to CHW.

Parameters:

img0 (np.ndarray): image for preprocessing

Returns:

img (np.ndarray): image after preprocessing

"""

# resize

img = letterbox(img0)[0]

# Convert HWC to CHW

img = img.transpose(2, 0, 1)

img = np.ascontiguousarray(img)

return img

def image_to_tensor(image:np.ndarray):

"""

Preprocess image according to YOLOv8 input requirements.

Takes image in np.array format, resizes it to specific size using letterbox resize and changes data layout from HWC to CHW.

Parameters:

img (np.ndarray): image for preprocessing

Returns:

input_tensor (np.ndarray): input tensor in NCHW format with float32 values in [0, 1] range

"""

input_tensor = image.astype(np.float32) # uint8 to fp32

input_tensor /= 255.0 # 0 - 255 to 0.0 - 1.0

# add batch dimension

if input_tensor.ndim == 3:

input_tensor = np.expand_dims(input_tensor, 0)

return input_tensor

後処理¶

モデル出力には検出ボックス候補が含まれており、B,84,N 形式の [-1,84,-1] 形状のテンソルです。

説明:

B- バッチサイズN- 検出ボックスの数

最終的な予測を得るには、非最大抑制アルゴリズムを適用して、ボックス座標を元の画像サイズに再スケーリングする必要があります。

最後に、検出ボックスの形式は [x, y, h, w, class_no_1, …, class_no_80] です。

説明:

(

x,y) - ボックス中心の生座標h,w- ボックスの生の高さと幅class_no_1, …,class_no_80- クラス全体の確率分布

def postprocess(

pred_boxes:np.ndarray,

input_hw:Tuple[int, int],

orig_img:np.ndarray,

min_conf_threshold:float = 0.25,

nms_iou_threshold:float = 0.7,

agnosting_nms:bool = False,

max_detections:int = 300,

):

"""

YOLOv8 model postprocessing function. Applied non maximum supression algorithm to detections and rescale boxes to original image size

Parameters:

pred_boxes (np.ndarray): model output prediction boxes

input_hw (np.ndarray): preprocessed image

orig_image (np.ndarray): image before preprocessing

min_conf_threshold (float, *optional*, 0.25): minimal accepted confidence for object filtering

nms_iou_threshold (float, *optional*, 0.45): minimal overlap score for removing objects duplicates in NMS

agnostic_nms (bool, *optiona*, False): apply class agnostinc NMS approach or not

max_detections (int, *optional*, 300): maximum detections after NMS

Returns:

pred (List[Dict[str, np.ndarray]]): list of dictionary with det - detected boxes in format [x1, y1, x2, y2, score, label]

"""

nms_kwargs = {"agnostic": agnosting_nms, "max_det":max_detections}

preds = ops.non_max_suppression(

torch.from_numpy(pred_boxes),

min_conf_threshold,

nms_iou_threshold,

nc=80,

**nms_kwargs

)

results = []

for i, pred in enumerate(preds):

shape = orig_img[i].shape if isinstance(orig_img, list) else orig_img.shape

if not len(pred):

results.append({"det": [], "segment": []})

continue

pred[:, :4] = ops.scale_boxes(input_hw, pred[:, :4], shape).round()

results.append({"det": pred})

return results

推論デバイスの選択¶

OpenVINO を使用して推論を実行するデバイスをドロップダウン・リストから選択します。

import ipywidgets as widgets

import openvino as ov

core = ov.Core()

device = widgets.Dropdown(

options=core.available_devices + ["AUTO"],

value='AUTO',

description='Device:',

disabled=False,

)

device

Dropdown(description='Device:', index=2, options=('CPU', 'GPU', 'AUTO'), value='AUTO')

単一の画像でテスト¶

前処理と後処理の手順を定義したら、オブジェクト検出のモデル予測を確認する準備が整いました。

core = ov.Core()

det_ov_model = core.read_model(det_model_path)

if device.value != "CPU":

det_ov_model.reshape({0: [1, 3, 640, 640]})

det_compiled_model = core.compile_model(det_ov_model, device.value)

def detect(image:np.ndarray, model:ov.Model):

"""

OpenVINO YOLOv8 model inference function. Preprocess image, runs model inference and postprocess results using NMS.

Parameters:

image (np.ndarray): input image.

model (Model): OpenVINO compiled model.

Returns:

detections (np.ndarray): detected boxes in format [x1, y1, x2, y2, score, label]

"""

preprocessed_image = preprocess_image(image)

input_tensor = image_to_tensor(preprocessed_image)

result = model(input_tensor)

boxes = result[model.output(0)]

input_hw = input_tensor.shape[2:]

detections = postprocess(pred_boxes=boxes, input_hw=input_hw, orig_img=image)

return detections

input_image = np.array(Image.open(IMAGE_PATH))

detections = detect(input_image, det_compiled_model)[0]

image_with_boxes = draw_results(detections, input_image, label_map)

Image.fromarray(image_with_boxes)

データセット上のモデルの精度をチェック¶

最適化されたモデルの結果を元のモデルと比較するには、検証データセットでのモデルの精度に関する測定可能な結果をいくつか知っておくとよいでしょう。

検証データセットをダウンロード¶

YOLOv8 は COCO データセットで事前トレーニングされているため、モデルの精度を評価するにはそれをダウンロードする必要があります。YOLOv8 リポジトリーで提供されている指示に従って、元のモデル評価関数で使用するため、モデルの作成者が使用した形式でアノテーションをダウンロードする必要もあります。

注: 最初のデータセットのダウンロードが完了するまでに数分かかる場合があります。ダウンロード速度はインターネット接続の品質によって異なります。

from zipfile import ZipFile

DATA_URL = "http://images.cocodataset.org/zips/val2017.zip"

LABELS_URL = "https://github.com/ultralytics/yolov5/releases/download/v1.0/coco2017labels-segments.zip"

CFG_URL = "https://raw.githubusercontent.com/ultralytics/ultralytics/8ebe94d1e928687feaa1fee6d5668987df5e43be/ultralytics/datasets/coco.yaml"

OUT_DIR = Path('./datasets')

DATA_PATH = OUT_DIR / "val2017.zip"

LABELS_PATH = OUT_DIR / "coco2017labels-segments.zip"

CFG_PATH = OUT_DIR / "coco.yaml"

download_file(DATA_URL, DATA_PATH.name, DATA_PATH.parent)

download_file(LABELS_URL, LABELS_PATH.name, LABELS_PATH.parent)

download_file(CFG_URL, CFG_PATH.name, CFG_PATH.parent)

if not (OUT_DIR / "coco/labels").exists():

with ZipFile(LABELS_PATH , "r") as zip_ref:

zip_ref.extractall(OUT_DIR)

with ZipFile(DATA_PATH , "r") as zip_ref:

zip_ref.extractall(OUT_DIR / 'coco/images')

'datasets/val2017.zip' already exists.

'datasets/coco2017labels-segments.zip' already exists.

datasets/coco.yaml: 0%| | 0.00/1.25k [00:00<?, ?B/s]

評価関数を定義¶

from tqdm.notebook import tqdm

from ultralytics.yolo.utils.metrics import ConfusionMatrix

def test(model:ov.Model, core:ov.Core, data_loader:torch.utils.data.DataLoader, validator, num_samples:int = None):

"""

OpenVINO YOLOv8 model accuracy validation function. Runs model validation on dataset and returns metrics

Parameters:

model (Model): OpenVINO model

data_loader (torch.utils.data.DataLoader): dataset loader

validator: instance of validator class

num_samples (int, *optional*, None): validate model only on specified number samples, if provided

Returns:

stats: (Dict[str, float]) - dictionary with aggregated accuracy metrics statistics, key is metric name, value is metric value

"""

validator.seen = 0

validator.jdict = []

validator.stats = []

validator.batch_i = 1

validator.confusion_matrix = ConfusionMatrix(nc=validator.nc)

model.reshape({0: [1, 3, -1, -1]})

compiled_model = core.compile_model(model)

for batch_i, batch in enumerate(tqdm(data_loader, total=num_samples)):

if num_samples is not None and batch_i == num_samples:

break

batch = validator.preprocess(batch)

results = compiled_model(batch["img"])

preds = torch.from_numpy(results[compiled_model.output(0)])

preds = validator.postprocess(preds)

validator.update_metrics(preds, batch)

stats = validator.get_stats()

return stats

def print_stats(stats:np.ndarray, total_images:int, total_objects:int):

"""

Helper function for printing accuracy statistic

Parameters:

stats: (Dict[str, float]) - dictionary with aggregated accuracy metrics statistics, key is metric name, value is metric value

total_images (int) - number of evaluated images

total objects (int)

Returns:

None

"""

print("Boxes:")

mp, mr, map50, mean_ap = stats['metrics/precision(B)'], stats['metrics/recall(B)'], stats['metrics/mAP50(B)'], stats['metrics/mAP50-95(B)']

# Print results

s = ('%20s' + '%12s' * 6) % ('Class', 'Images', 'Labels', 'Precision', 'Recall', 'mAP@.5', 'mAP@.5:.95')

print(s)

pf = '%20s' + '%12i' * 2 + '%12.3g' * 4 # print format

print(pf % ('all', total_images, total_objects, mp, mr, map50, mean_ap))

if 'metrics/precision(M)' in stats:

s_mp, s_mr, s_map50, s_mean_ap = stats['metrics/precision(M)'], stats['metrics/recall(M)'], stats['metrics/mAP50(M)'], stats['metrics/mAP50-95(M)']

# Print results

s = ('%20s' + '%12s' * 6) % ('Class', 'Images', 'Labels', 'Precision', 'Recall', 'mAP@.5', 'mAP@.5:.95')

print(s)

pf = '%20s' + '%12i' * 2 + '%12.3g' * 4 # print format

print(pf % ('all', total_images, total_objects, s_mp, s_mr, s_map50, s_mean_ap))

Validator ヘルパーを構成し、DataLoader を作成¶

元のモデル・リポジトリーは、精度検証パイプラインを表す Validatorラッパーを使用します。データローダーと評価メトリックを作成し、データローダーによって生成される各データバッチのメトリックを更新します。加えて、データの前処理と結果の後処理も担当します。クラスの初期化では、構成を提供する必要があります。デフォルトの設定を使用しますが、カスタムデータでテストするにはオーバーライドするいくつかのパラメーターに置き換えることができます。モデルは ValidatorClass メソッドに接続しており、これによりバリデーター・クラスのインスタンスが作成されます。

from ultralytics.yolo.utils import DEFAULT_CFG

from ultralytics.yolo.cfg import get_cfg

from ultralytics.yolo.data.utils import check_det_dataset

args = get_cfg(cfg=DEFAULT_CFG)

args.data = str(CFG_PATH)

det_validator = det_model.ValidatorClass(args=args)

det_validator.data = check_det_dataset(args.data)

det_data_loader = det_validator.get_dataloader("datasets/coco", 1)

val: Scanning datasets/coco/labels/val2017.cache... 4952 images, 48 backgrounds, 0 corrupt: 100%|██████████| 5000/5000 [00:00<?, ?it/s]

det_validator.is_coco = True

det_validator.class_map = ops.coco80_to_coco91_class()

det_validator.names = det_model.model.names

det_validator.metrics.names = det_validator.names

det_validator.nc = det_model.model.model[-1].nc

テスト関数の定義と評価器の作成が完了したら、精度メトリックを取得する準備が整います。

注: モデル評価は時間のかかるプロセスであり、ハードウェアによっては数分かかる場合があります。計算時間を短縮するために、評価サブセットのサイズで

num_samplesパラメーターを定義しますが、この場合、検証サブセットの違いにより、モデルの作成者が最初に報告した精度と比較できない可能性があります。完全なデータセットでモデルを検証するには、``NUM_TEST_SAMPLES = None`` を設定します。

NUM_TEST_SAMPLES = 300

fp_det_stats = test(det_ov_model, core, det_data_loader, det_validator, num_samples=NUM_TEST_SAMPLES)

0%| | 0/300 [00:00<?, ?it/s]

print_stats(fp_det_stats, det_validator.seen, det_validator.nt_per_class.sum())

Boxes:

Class Images Labels Precision Recall mAP@.5 mAP@.5:.95

all 300 2145 0.594 0.543 0.579 0.417

print_stats 次の精度メトリックのリストを報告します。

Precisionは、関連するオブジェクトのみを識別するモデルの正確さの度合いです。Recallは、モデルがすべてのグラウンド・トゥルース・オブジェクトを検出する能力を測定します。mAP@t- 平均精度は、データセット内のすべてのクラスにわたって集計された適合率と再現率曲線下の領域として表されます。ここで、tは 交差ユニオン (IOU) しきい値、つまり、グラウンドトゥルースと予測されたオブジェクト間の重複の度合いです。したがって、mAP@.5は、平均精度が 0.5 IOU しきい値で計算されたことを示します。mAP@.5:.95は、ステップ 0.05 で 0.5 から 0.95 までの範囲の IOU しきい値で計算されます。

NNCF トレーニング後の量子化 API を使用してモデルを最適化¶

NNCF は、精度の低下を最小限に抑えながら、OpenVINO でニューラル・ネットワーク推論を最適化する一連の高度なアルゴリズムを提供します。YOLOv8 を最適化するため、ポストトレーニング・モード (微調整パイプラインなし) で 8 ビット量子化を使用します。

最適化プロセスには次の手順が含まれます。

量子化用のデータセットを作成します。

nncf.quantizeを実行して、最適化されたモデルを取得します。openvino.runtime.serialize関数を使用して、OpenVINO IR モデルをシリアル化します。

量子化の精度テストで検証データローダーを再利用します。そのため、nncf.Dataset オブジェクトにラップし、入力テンソルのみを取得する変換関数を定義する必要があります。

import nncf # noqa: F811

from typing import Dict

def transform_fn(data_item:Dict):

"""

Quantization transform function. Extracts and preprocess input data from dataloader item for quantization.

Parameters:

data_item: Dict with data item produced by DataLoader during iteration

Returns:

input_tensor: Input data for quantization

"""

input_tensor = det_validator.preprocess(data_item)['img'].numpy()

return input_tensor

quantization_dataset = nncf.Dataset(det_data_loader, transform_fn)

INFO:nncf:NNCF initialized successfully. Supported frameworks detected: torch, tensorflow, onnx, openvino

nncf.quantize 関数は、モデルの量子化のインターフェイスを提供します。OpenVINO モデルのインスタンスと量子化データセットが必要です。オプションで、量子化プロセスの追加パラメーター (量子化のサンプル数、プリセット、無視される範囲など) を提供できます。YOLOv8 モデルには、活性化の非対称量子化を必要とする非 ReLU 活性化関数が含まれています。さらに良い結果を得るため、mixed 量子化プリセットを使用します。これは、重みの対称量子化とアクティベーションの非対称量子化を提供します。より正確な結果を得るには、ignored_scope パラメーターを使用して、後処理サブグラフの操作を浮動小数点精度に保つ必要があります。

注: モデルのトレーニング後の量子化は時間のかかるプロセスです。ハードウェアによっては数分かかる場合があります。

ignored_scope = nncf.IgnoredScope(

types=["Multiply", "Subtract", "Sigmoid"], # ignore operations

names=[

"/model.22/dfl/conv/Conv", # in the post-processing subgraph

"/model.22/Add",

"/model.22/Add_1",

"/model.22/Add_2",

"/model.22/Add_3",

"/model.22/Add_4",

"/model.22/Add_5",

"/model.22/Add_6",

"/model.22/Add_7",

"/model.22/Add_8",

"/model.22/Add_9",

"/model.22/Add_10"

]

)

# Detection model

quantized_det_model = nncf.quantize(

det_ov_model,

quantization_dataset,

preset=nncf.QuantizationPreset.MIXED,

ignored_scope=ignored_scope

)

INFO:nncf:12 ignored nodes was found by name in the NNCFGraph

INFO:nncf:9 ignored nodes was found by types in the NNCFGraph

INFO:nncf:Not adding activation input quantizer for operation: 128 /model.22/Sigmoid

INFO:nncf:Not adding activation input quantizer for operation: 156 /model.22/dfl/conv/Conv

INFO:nncf:Not adding activation input quantizer for operation: 178 /model.22/Sub

INFO:nncf:Not adding activation input quantizer for operation: 179 /model.22/Add_10

INFO:nncf:Not adding activation input quantizer for operation: 193 /model.22/Sub_1

INFO:nncf:Not adding activation input quantizer for operation: 218 /model.22/Mul_5

Statistics collection: 100%|████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████| 300/300 [00:31<00:00, 9.54it/s]

Applying Fast Bias correction: 100%|██████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████| 63/63 [00:03<00:00, 18.94it/s]

from openvino.runtime import serialize

int8_model_det_path = models_dir / f'{DET_MODEL_NAME}_openvino_int8_model/{DET_MODEL_NAME}.xml'

print(f"Quantized detection model will be saved to {int8_model_det_path}")

serialize(quantized_det_model, str(int8_model_det_path))

Quantized detection model will be saved to models/yolov8n_openvino_int8_model/yolov8n.xml

量子化モデルの推論を検証¶

nncf.quantize 予測を行うためデバイスにロードするのに適した OpenVINO モデル・クラス・インスタンスを返します。INT8 モデルの入力データと出力結果の形式は、浮動小数点モデルの表現と違いはありません。したがって、画像上の INT8 モデル結果を取得するために、上で定義した同じ検出関数を再利用できます。

device

Dropdown(description='Device:', index=2, options=('CPU', 'GPU', 'AUTO'), value='AUTO')

if device.value != "CPU":

quantized_det_model.reshape({0: [1, 3, 640, 640]})

quantized_det_compiled_model = core.compile_model(quantized_det_model, device.value)

input_image = np.array(Image.open(IMAGE_PATH))

detections = detect(input_image, quantized_det_compiled_model)[0]

image_with_boxes = draw_results(detections, input_image, label_map)

Image.fromarray(image_with_boxes)

オリジナルモデルと量子化モデルを比較¶

物体検出モデルのパフォーマンスを比較¶

最後に、OpenVINO Benchmark ツールを使用して、FP32 と INT8 モデルの推論パフォーマンスを測定します。

注: より正確なパフォーマンスを得るには、他のアプリケーションを閉じて、ターミナル/コマンドプロンプトで

benchmark_appを実行することを推奨します。benchmark_app -m <model_path> -d CPU -shape "<input_shape>"を実行して、CPU で非同期推論のベンチマークを 1 分間実行します。GPU でベンチマークを行うには、CPUをGPUに変更します。benchmark_app --helpを実行すると、すべてのコマンドライン・オプションの概要が表示されます。

device

Dropdown(description='Device:', index=2, options=('CPU', 'GPU', 'AUTO'), value='AUTO')

# Inference FP32 model (OpenVINO IR)

!benchmark_app -m $det_model_path -d $device.value -api async -shape "[1,3,640,640]"

[Step 1/11] Parsing and validating input arguments

[ INFO ] Parsing input parameters

[Step 2/11] Loading OpenVINO Runtime

[ WARNING ] Default duration 120 seconds is used for unknown device AUTO

[ INFO ] OpenVINO:

[ INFO ] Build ................................. 2023.2.0-12690-0ee0b4d9561

[ INFO ]

[ INFO ] Device info:

[ INFO ] AUTO

[ INFO ] Build ................................. 2023.2.0-12690-0ee0b4d9561

[ INFO ]

[ INFO ]

[Step 3/11] Setting device configuration

[ WARNING ] Performance hint was not explicitly specified in command line. Device(AUTO) performance hint will be set to PerformanceMode.THROUGHPUT.

[Step 4/11] Reading model files

[ INFO ] Loading model files

[ INFO ] Read model took 16.72 ms

[ INFO ] Original model I/O parameters:

[ INFO ] Model inputs:

[ INFO ] images (node: images) : f32 / [...] / [?,3,?,?]

[ INFO ] Model outputs:

[ INFO ] output0 (node: output0) : f32 / [...] / [?,84,?]

[Step 5/11] Resizing model to match image sizes and given batch

[ INFO ] Model batch size: 1

[ INFO ] Reshaping model: 'images': [1,3,640,640]

[ INFO ] Reshape model took 11.83 ms

[Step 6/11] Configuring input of the model

[ INFO ] Model inputs:

[ INFO ] images (node: images) : u8 / [N,C,H,W] / [1,3,640,640]

[ INFO ] Model outputs:

[ INFO ] output0 (node: output0) : f32 / [...] / [1,84,8400]

[Step 7/11] Loading the model to the device

[ INFO ] Compile model took 424.62 ms

[Step 8/11] Querying optimal runtime parameters

[ INFO ] Model:

[ INFO ] NETWORK_NAME: torch_jit

[ INFO ] EXECUTION_DEVICES: ['CPU']

[ INFO ] PERFORMANCE_HINT: PerformanceMode.THROUGHPUT

[ INFO ] OPTIMAL_NUMBER_OF_INFER_REQUESTS: 12

[ INFO ] MULTI_DEVICE_PRIORITIES: CPU

[ INFO ] CPU:

[ INFO ] AFFINITY: Affinity.CORE

[ INFO ] CPU_DENORMALS_OPTIMIZATION: False

[ INFO ] CPU_SPARSE_WEIGHTS_DECOMPRESSION_RATE: 1.0

[ INFO ] ENABLE_CPU_PINNING: True

[ INFO ] ENABLE_HYPER_THREADING: True

[ INFO ] EXECUTION_DEVICES: ['CPU']

[ INFO ] EXECUTION_MODE_HINT: ExecutionMode.PERFORMANCE

[ INFO ] INFERENCE_NUM_THREADS: 36

[ INFO ] INFERENCE_PRECISION_HINT: <Type: 'float32'>

[ INFO ] NETWORK_NAME: torch_jit

[ INFO ] NUM_STREAMS: 12

[ INFO ] OPTIMAL_NUMBER_OF_INFER_REQUESTS: 12

[ INFO ] PERFORMANCE_HINT: PerformanceMode.THROUGHPUT

[ INFO ] PERFORMANCE_HINT_NUM_REQUESTS: 0

[ INFO ] PERF_COUNT: False

[ INFO ] SCHEDULING_CORE_TYPE: SchedulingCoreType.ANY_CORE

[ INFO ] MODEL_PRIORITY: Priority.MEDIUM

[ INFO ] LOADED_FROM_CACHE: False

[Step 9/11] Creating infer requests and preparing input tensors

[ WARNING ] No input files were given for input 'images'!. This input will be filled with random values!

[ INFO ] Fill input 'images' with random values

[Step 10/11] Measuring performance (Start inference asynchronously, 12 inference requests, limits: 120000 ms duration)

[ INFO ] Benchmarking in inference only mode (inputs filling are not included in measurement loop).

[ INFO ] First inference took 34.66 ms

[Step 11/11] Dumping statistics report

[ INFO ] Execution Devices:['CPU']

[ INFO ] Count: 15024 iterations

[ INFO ] Duration: 120272.02 ms

[ INFO ] Latency:

[ INFO ] Median: 77.25 ms

[ INFO ] Average: 95.83 ms

[ INFO ] Min: 60.23 ms

[ INFO ] Max: 270.56 ms

[ INFO ] Throughput: 124.92 FPS

# Inference INT8 model (OpenVINO IR)

!benchmark_app -m $int8_model_det_path -d $device.value -api async -shape "[1,3,640,640]" -t 15

[Step 1/11] Parsing and validating input arguments

[ INFO ] Parsing input parameters

[Step 2/11] Loading OpenVINO Runtime

[ INFO ] OpenVINO:

[ INFO ] Build ................................. 2023.2.0-12690-0ee0b4d9561

[ INFO ]

[ INFO ] Device info:

[ INFO ] AUTO

[ INFO ] Build ................................. 2023.2.0-12690-0ee0b4d9561

[ INFO ]

[ INFO ]

[Step 3/11] Setting device configuration

[ WARNING ] Performance hint was not explicitly specified in command line. Device(AUTO) performance hint will be set to PerformanceMode.THROUGHPUT.

[Step 4/11] Reading model files

[ INFO ] Loading model files

[ INFO ] Read model took 73.93 ms

[ INFO ] Original model I/O parameters:

[ INFO ] Model inputs:

[ INFO ] images (node: images) : f32 / [...] / [1,3,?,?]

[ INFO ] Model outputs:

[ INFO ] output0 (node: output0) : f32 / [...] / [1,84,21..]

[Step 5/11] Resizing model to match image sizes and given batch

[ INFO ] Model batch size: 1

[ INFO ] Reshaping model: 'images': [1,3,640,640]

[ INFO ] Reshape model took 56.37 ms

[Step 6/11] Configuring input of the model

[ INFO ] Model inputs:

[ INFO ] images (node: images) : u8 / [N,C,H,W] / [1,3,640,640]

[ INFO ] Model outputs:

[ INFO ] output0 (node: output0) : f32 / [...] / [1,84,8400]

[Step 7/11] Loading the model to the device

[ INFO ] Compile model took 1742.92 ms

[Step 8/11] Querying optimal runtime parameters

[ INFO ] Model:

[ INFO ] NETWORK_NAME: torch_jit

[ INFO ] EXECUTION_DEVICES: ['CPU']

[ INFO ] PERFORMANCE_HINT: PerformanceMode.THROUGHPUT

[ INFO ] OPTIMAL_NUMBER_OF_INFER_REQUESTS: 18

[ INFO ] MULTI_DEVICE_PRIORITIES: CPU

[ INFO ] CPU:

[ INFO ] AFFINITY: Affinity.CORE

[ INFO ] CPU_DENORMALS_OPTIMIZATION: False

[ INFO ] CPU_SPARSE_WEIGHTS_DECOMPRESSION_RATE: 1.0

[ INFO ] ENABLE_CPU_PINNING: True

[ INFO ] ENABLE_HYPER_THREADING: True

[ INFO ] EXECUTION_DEVICES: ['CPU']

[ INFO ] EXECUTION_MODE_HINT: ExecutionMode.PERFORMANCE

[ INFO ] INFERENCE_NUM_THREADS: 36

[ INFO ] INFERENCE_PRECISION_HINT: <Type: 'float32'>

[ INFO ] NETWORK_NAME: torch_jit

[ INFO ] NUM_STREAMS: 18

[ INFO ] OPTIMAL_NUMBER_OF_INFER_REQUESTS: 18

[ INFO ] PERFORMANCE_HINT: PerformanceMode.THROUGHPUT

[ INFO ] PERFORMANCE_HINT_NUM_REQUESTS: 0

[ INFO ] PERF_COUNT: False

[ INFO ] SCHEDULING_CORE_TYPE: SchedulingCoreType.ANY_CORE

[ INFO ] MODEL_PRIORITY: Priority.MEDIUM

[ INFO ] LOADED_FROM_CACHE: False

[Step 9/11] Creating infer requests and preparing input tensors

[ WARNING ] No input files were given for input 'images'!. This input will be filled with random values!

[ INFO ] Fill input 'images' with random values

[Step 10/11] Measuring performance (Start inference asynchronously, 18 inference requests, limits: 15000 ms duration)

[ INFO ] Benchmarking in inference only mode (inputs filling are not included in measurement loop).

[ INFO ] First inference took 58.19 ms

[Step 11/11] Dumping statistics report

[ INFO ] Execution Devices:['CPU']

[ INFO ] Count: 3150 iterations

[ INFO ] Duration: 15116.07 ms

[ INFO ] Latency:

[ INFO ] Median: 79.96 ms

[ INFO ] Average: 85.97 ms

[ INFO ] Min: 56.29 ms

[ INFO ] Max: 154.33 ms

[ INFO ] Throughput: 208.39 FPS

量子化されたモデルの精度を検証¶

ご覧のとおり、単一画像テストでは、INT8 モデルと float モデルの結果に大きな違いはありません。量子化がモデル予測の精度にどのように影響するか理解するため、データセット上のモデル精度を比較することができます。

int8_det_stats = test(quantized_det_model, core, det_data_loader, det_validator, num_samples=NUM_TEST_SAMPLES)

0%| | 0/300 [00:00<?, ?it/s]

print("FP32 model accuracy")

print_stats(fp_det_stats, det_validator.seen, det_validator.nt_per_class.sum())

print("INT8 model accuracy")

print_stats(int8_det_stats, det_validator.seen, det_validator.nt_per_class.sum())

FP32 model accuracy

Boxes:

Class Images Labels Precision Recall mAP@.5 mAP@.5:.95

all 300 2145 0.594 0.543 0.579 0.417

INT8 model accuracy

Boxes:

Class Images Labels Precision Recall mAP@.5 mAP@.5:.95

all 300 2145 0.623 0.517 0.572 0.406

これで完了です! 精度は変更されたようですが、大きな変化はなく、合格基準を満たしています。

次のステップ¶

このセクションでは、OpenVINO を使用してアプリケーションのパフォーマンスをさらに向上させる方法に関する提案を示します。

非同期推論パイプライン¶

非同期 API の主な利点は、デバイスが推論でビジー状態のときに、アプリケーションが現在の推論が完了するのを待つのではなく、他のタスク (例えば、入力の入力や他の要求のスケジュール設定) を並行して実行できることです。OpenVINO を使用して非同期推論を実行する方法を理解するには、非同期 API のチュートリアルを参照してください。

モデルへの統合前処理¶

前処理 API を使用すると、前処理をモデルの一部にすることができ、アプリケーション・コードと追加の画像処理ライブラリーへの依存関係が削減されます。前処理 API の主な利点は、前処理手順が実行グラフに統合され、アプリケーションの一部として常に CPU 上で実行されるのではなく、選択したデバイス (CPU/GPU など) 上で実行されることです。これにより、選択したデバイスの使用率が向上します。

詳細については、前処理 API の概要を参照してください。

例えば、image_to_tensor 関数で定義された入力データ・レイアウトと正規化の変換を統合できます。

統合プロセスは次の手順で構成されます。

- PrePostProcessing オブジェクトを初期化します。

- 入力データの形式を定義します。

- 前処理手順について記述します。

- ステップをモデルに統合します。

前処理/後処理 API を初期化¶

openvino.preprocess.PrePostProcessor クラスを使用すると、モデルの前処理および後処理の手順を指定できます。

from openvino.preprocess import PrePostProcessor

ppp = PrePostProcessor(quantized_det_model)

入力データ形式¶

モデル/プリプロセッサーの特定の入力を処理するには、input(input_id) メソッドを使用します。input_id は、model.inputs 内の入力の位置インデックスまたは入力テンソル名です。モデルに入力が 1 つの場合は、input_id を省略できます。ディスクから画像を読み取った後、画像には [0, 255] の範囲の U8 ピクセルが含まれ、NHWC レイアウトで保存されます。前処理変換を実行するには、これをテンソル記述に提供する必要があります。

ppp.input(0).tensor().set_shape([1, 640, 640, 3]).set_element_type(ov.Type.u8).set_layout(ov.Layout('NHWC'))

pass

レイアウト変換を実行するには、モデルが期待するレイアウトに関する情報も提供する必要があります。

前処理手順を記述¶

前処理関数には次の手順が含まれます。

- データタイプを

U8からFP32に変換します。 - データ・レイアウトを

NHWC形式からNCHW形式に変換します。 - スケール係数 255 で除算して各ピクセルを正規化します。

ppp.input(input_id).preprocess() は、前処理手順のシーケンスを定義するために使用されます。

ppp.input(0).preprocess().convert_element_type(ov.Type.f32).convert_layout(ov.Layout('NCHW')).scale([255., 255., 255.])

print(ppp)

Input "images":

User's input tensor: [1,640,640,3], [N,H,W,C], u8

Model's expected tensor: [1,3,?,?], [N,C,H,W], f32

Pre-processing steps (3):

convert type (f32): ([1,640,640,3], [N,H,W,C], u8) -> ([1,640,640,3], [N,H,W,C], f32)

convert layout [N,C,H,W]: ([1,640,640,3], [N,H,W,C], f32) -> ([1,3,640,640], [N,C,H,W], f32)

scale (255,255,255): ([1,3,640,640], [N,C,H,W], f32) -> ([1,3,640,640], [N,C,H,W], f32)

ステップをモデルに統合¶

前処理ステップが完了すると、最終モデルを構築できます。さらに、openvino.runtime.serialize を使用して、完成したモデルを OpenVINO IR に保存することもできます。

quantized_model_with_preprocess = ppp.build()

serialize(quantized_model_with_preprocess, str(int8_model_det_path.with_name(f"{DET_MODEL_NAME}_with_preprocess.xml")))

前処理が統合されたモデルは、デバイスに読み込む準備ができています。これで、検出関数内のこれらの前処理手順をスキップできます。

def detect_without_preprocess(image:np.ndarray, model:ov.Model):

"""

OpenVINO YOLOv8 model with integrated preprocessing inference function. Preprocess image, runs model inference and postprocess results using NMS.

Parameters:

image (np.ndarray): input image.

model (Model): OpenVINO compiled model.

Returns:

detections (np.ndarray): detected boxes in format [x1, y1, x2, y2, score, label]

"""

output_layer = model.output(0)

img = letterbox(image)[0]

input_tensor = np.expand_dims(img, 0)

input_hw = img.shape[:2]

result = model(input_tensor)[output_layer]

detections = postprocess(result, input_hw, image)

return detections

compiled_model = core.compile_model(quantized_model_with_preprocess, device.value)

input_image = np.array(Image.open(IMAGE_PATH))

detections = detect_without_preprocess(input_image, compiled_model)[0]

image_with_boxes = draw_results(detections, input_image, label_map)

Image.fromarray(image_with_boxes)

ライブデモ¶

次のコードは、ビデオに対してモデル推論を実行します。

import collections

import time

from IPython import display

# Main processing function to run object detection.

def run_object_detection(source=0, flip=False, use_popup=False, skip_first_frames=0, model=det_model, device=device.value):

player = None

if device != "CPU":

model.reshape({0: [1, 3, 640, 640]})

compiled_model = core.compile_model(model, device)

try:

# Create a video player to play with target fps.

player = VideoPlayer(

source=source, flip=flip, fps=30, skip_first_frames=skip_first_frames

)

# Start capturing.

player.start()

if use_popup:

title = "Press ESC to Exit"

cv2.namedWindow(

winname=title, flags=cv2.WINDOW_GUI_NORMAL | cv2.WINDOW_AUTOSIZE

)

processing_times = collections.deque()

while True:

# Grab the frame.

frame = player.next()

if frame is None:

print("Source ended")

break

# If the frame is larger than full HD, reduce size to improve the performance.

scale = 1280 / max(frame.shape)

if scale < 1:

frame = cv2.resize(

src=frame,

dsize=None,

fx=scale,

fy=scale,

interpolation=cv2.INTER_AREA,

)

# Get the results.

input_image = np.array(frame)

start_time = time.time()

# model expects RGB image, while video capturing in BGR

detections = detect(input_image[:, :, ::-1], compiled_model)[0]

stop_time = time.time()

image_with_boxes = draw_results(detections, input_image, label_map)

frame = image_with_boxes

processing_times.append(stop_time - start_time)

# Use processing times from last 200 frames.

if len(processing_times) > 200:

processing_times.popleft()

_, f_width = frame.shape[:2]

# Mean processing time [ms].

processing_time = np.mean(processing_times) * 1000

fps = 1000 / processing_time

cv2.putText(

img=frame,

text=f"Inference time: {processing_time:.1f}ms ({fps:.1f} FPS)",

org=(20, 40),

fontFace=cv2.FONT_HERSHEY_COMPLEX,

fontScale=f_width / 1000,

color=(0, 0, 255),

thickness=1,

lineType=cv2.LINE_AA,

)

# Use this workaround if there is flickering.

if use_popup:

cv2.imshow(winname=title, mat=frame)

key = cv2.waitKey(1)

# escape = 27

if key == 27:

break

else:

# Encode numpy array to jpg.

_, encoded_img = cv2.imencode(

ext=".jpg", img=frame, params=[cv2.IMWRITE_JPEG_QUALITY, 100]

)

# Create an IPython image.

i = display.Image(data=encoded_img)

# Display the image in this notebook.

display.clear_output(wait=True)

display.display(i)

# ctrl-c

except KeyboardInterrupt:

print("Interrupted")

# any different error

except RuntimeError as e:

print(e)

finally:

if player is not None:

# Stop capturing.

player.stop()

if use_popup:

cv2.destroyAllWindows()

リアルタイムの物体検出の実行¶

ウェブカメラをビデオ入力として使用します。デフォルトでは、プライマリー・ウェブカメラは source=0 に設定されます。複数のウェブカメラがある場合、0 から始まる連続した番号が割り当てられます。前面カメラを使用する場合は、flip=True を設定します。一部のウェブブラウザー、特に Mozilla Firefox ではちらつきが発生する場合があります。ちらつきが発生する場合、use_popup=True を設定してください。

注: このノートブックをウェブカメラで使用するには、ウェブカメラを備えたコンピューター上でノートブックを実行する必要があります。ノートブックをリモートサーバー (例えば、Binder または Google Colab サービス) で実行する場合、ウェブカメラは動作しません。デフォルトでは、下のセルはビデオファイルに対してモデル推論を実行します。ウェブカメラ・セットでリアルタイムの推論を試す場合、

WEBCAM_INFERENCE = Trueを設定してください。

オブジェクト検出を実行します。

WEBCAM_INFERENCE = False

if WEBCAM_INFERENCE:

VIDEO_SOURCE = 0 # Webcam

else:

VIDEO_SOURCE = 'https://storage.openvinotoolkit.org/repositories/openvino_notebooks/data/data/video/people.mp4'

device

Dropdown(description='Device:', index=2, options=('CPU', 'GPU', 'AUTO'), value='AUTO')

run_object_detection(source=VIDEO_SOURCE, flip=True, use_popup=False, model=det_ov_model, device=device.value)

Source ended