smartlab-action-recognition-0001 (複合)#

ユースケースと概要説明#

Smartlab アクション認識には、2 つのエンコーダー・モデルと 1 つのデコーダーモデルを含む 3 つのモデルがあります。

これらのモデルは、アクションを予測するために SmartLab データセットで微調整されており、“noise_action”、“put_take” および “adjust_rider” を含む 3 種類のアクションを分類できます。

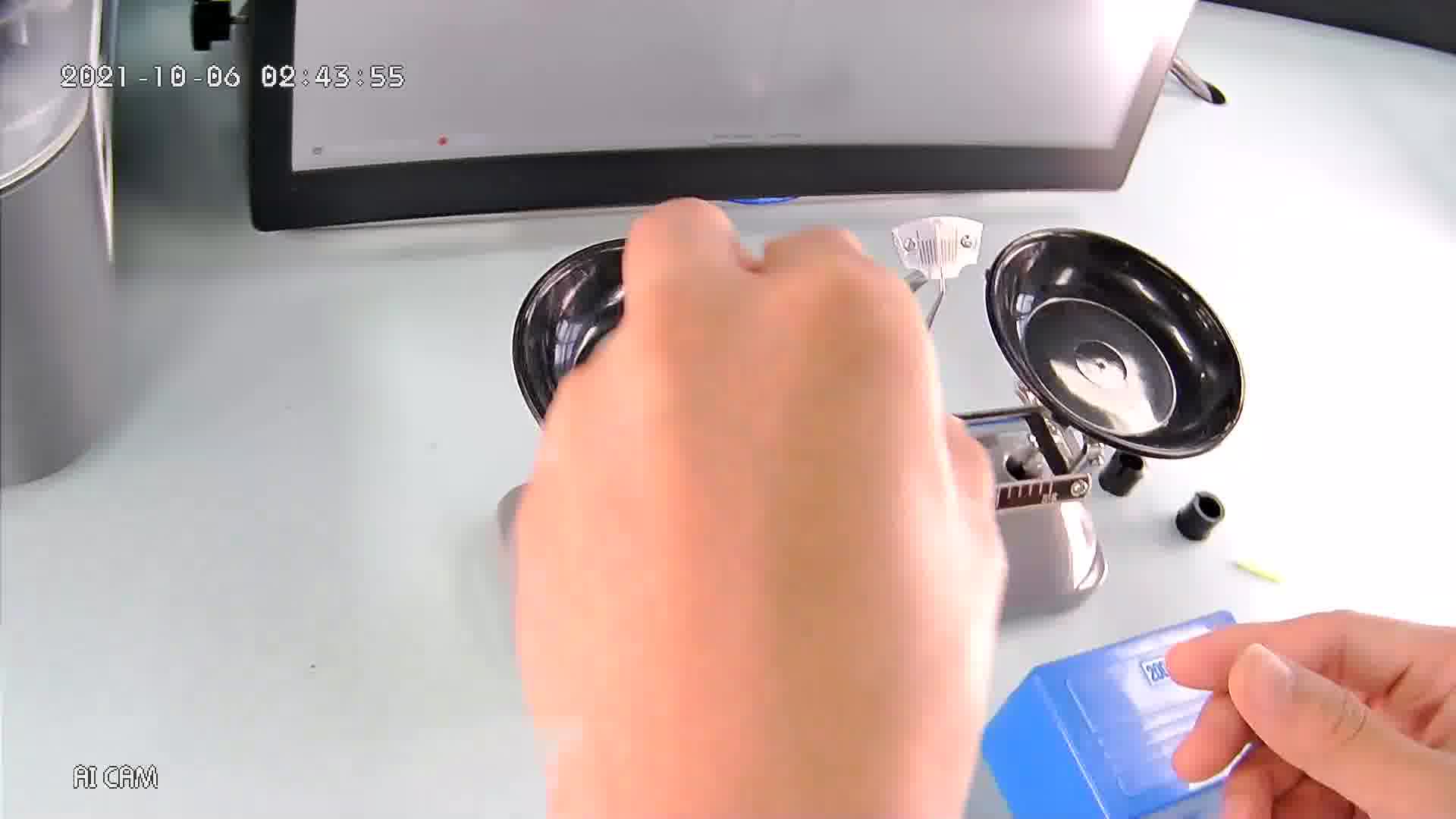

入力データの例#

出力の例#

put_take アクションを出力

複合モデル仕様#

メトリック |

値 |

|---|---|

DSI1867 の精度 |

TODO |

ソース・フレームワーク |

PyTorch* |

エンコーダー・モデルの仕様#

Smartlab-action-recognition-0001-encoder-* には、アクション認識の畳み込みエンコーダー部分を備えた Mobilenet-V2 に類似したバックボーンがあります。

smartlab-action-recognition-0001-encoder-side と smartlab-action-recognition-0001-encoder-top の 2 つのモデルがあり、構造は同じですが重みが異なります。

メトリック |

値 |

|---|---|

GFlops |

0.611 |

MParams |

3.387 |

入力#

画像、名前: input_image、形状: 1, 3, 224, 224、形式: B, C, H, W、ここで:

B- バッチサイズC- チャネル数H- 画像の髙さW- 画像の幅 予想される色の順序はBGRです

出力#

名前:

output_feature、形状:1, 1280。動作認識ヘッドのエンコーダーの特徴。

デコーダーモデル仕様#

smartlab-action-recognition-0001-decoder は、上面図と正面図からの特徴を受け入れ、エンコーダーによって計算され、次のラベルリストにわたるアクションのスコアを予測する完全に接続されたデコーダーパーツです: no_action、noise_action、adjust_rider

メトリック |

値 |

|---|---|

GFlops |

0.008 |

MParams |

4.099 |

入力#

名前:

input_feature_1、形状:1, 1280。トップビューからエンコードされた特徴。名前:

input_feature_2、形状:1, 1280。正面から見たエンコードされた特徴。

出力#

名前:

decoder_hidden、形状:1, 3。形式 [has_action_conf_score,action_1_logits,action_2_logits]has_action_conf_score- アクションフレームの信頼度。>0.5 の場合、アクションが指定されています。action_1_logits- put_take アクションクラスの信頼度action_2_logits- adjust_rider アクションクラスの信頼度

[0, 1] の範囲の分類信頼スコア。

デモの使い方#

このモデルは、Open Model Zoo が提供する次のデモで使用して、その機能を示します:

法務上の注意書き#

* その他の社名、製品名などは、一般に各社の表示、商標または登録商標です。