Stable Diffusion v2 と OpenVINO™ の無限ズーム#

この Jupyter ノートブックは、ローカルへのインストール後にのみ起動できます。

Stable Diffusion v2 は、Stability AI と LAION の研究者とエンジニアによって作成された、テキストから画像への潜在拡散モデルである Stable Diffusion の次世代モデルです。

一般に、拡散モデルは、画像などの対象サンプルを取得するために、ランダムなガウスノイズを段階的に除去するようにトレーニングされたマシン・ラーニング・システムです。拡散モデルは、画像データを生成するため最先端の結果を達成することが示されています。しかし、拡散モデルには、逆ノイズ除去プロセスが遅いという欠点があります。さらに、このモデルはピクセル空間で動作するため大量のメモリーを消費し、高解像度の画像を生成するには高いコストがかかります。そのため、このモデルをトレーニングし、推論に使用するのは困難です。OpenVINO は、インテルのハードウェア上でモデル推論を実行する機能を提供し、誰もが拡散モデルの素晴らしい世界への扉を開くことができます。

以前のノートブックでは、Stable Diffusion v1 を使用して Text-to-Image 生成と Image-to-Image 生成を実行し、ControlNet を使用してその生成プロセスを制御する方法について説明しました。ここでは Stable Diffusion v2 を使用します。

Stable Diffusion v2: 新機能#

新しい stable diffusion モデルは、最初の反復の導入以降に登場した他のモデルからヒントを得た新機能を提供します。新しいモデルに搭載されている機能の一部には次のものがあります:

このモデルには、LAION によって作成され、Stability AI によってサポートされた新しい強力なエンコーダー OpenCLIP が付属しています。このバージョン v2 では、生成される写真がバージョン V1 よりも大幅に強化されています。

モデルは 768x768 の解像度で画像を生成できるようになり、生成された画像に表示される情報がさらに増えました。

v-objective で微調整されたモデル。v-パラメーター化は、モデルの漸進的蒸留を可能にするために、拡散プロセス全体にわたって数値安定性を保つのに特に役立ちます。高解像度で動作するモデルの場合、v-パラメーター化によって、高解像度拡散モデルに影響することが知られている色シフト・アーティファクトが回避され、ビデオ設定では、Stable Diffusion v1 で使用されるイプシロン予測でたびたび発生する一時的な色シフトが回避されることも判明しました。

このモデルには、生成された画像のアップスケーリングを実行できる新しい拡散モデルも付属しています。アップスケールされた画像は、元の画像の最大 4 倍まで調整できます。別モデルとして提供されており、詳細については stable-diffusion-x4-upscaler を参照してください。

このモデルには、画像間の設定で前世代のレイヤーからのコンテキストを保持できる、新しい深度アーキテクチャーが搭載されています。この構造の保存により、オブジェクトの形と影を保存しながら、内容が異なる画像を生成することができます。

このモデルには、以前のモデルに基づいて構築された更新されたインペインティング・モジュールが付属しています。このテキストガイドによる修復により、画像内の部分の切り替えが以前よりも簡単になります。

このノートブックでは、Hugging Face ハブからモデルをダウンロードし、Optimum Intel によって OpenVINO IR 形式に変換する方法を示します。また、モデルを使用して、無限ズームビデオ効果向けの画像シーケンスを生成する方法も説明します。

目次:

Stable Diffusion v2 無限ズームのショーケース#

このチュートリアルでは、無限ズームビデオ効果の画像シーケンスを生成するために Stable Diffusion v2 モデルを使用する方法について説明します。これを行うには、stabilityai/stable-diffusion-2-inpainting モデルが必要になります。

Stable Diffusion テキストガイドによる修復#

画像編集において、修復とは画像の失われた部分を復元するプロセスのことです。最も一般的には、写真からひび割れ、傷、ほこり、赤目などを除去し、劣化した古い画像を再構築するために使用されます。

しかし、AI と安定拡散モデルにより、インペインティングを使用してそれ以上のことを実現できます。例えば、画像の欠落部分を復元するだけでなく、既存の画像の任意の部分に全く新しいものをレンダリングすることもできます。あなたの想像力だけがそれを制限します。

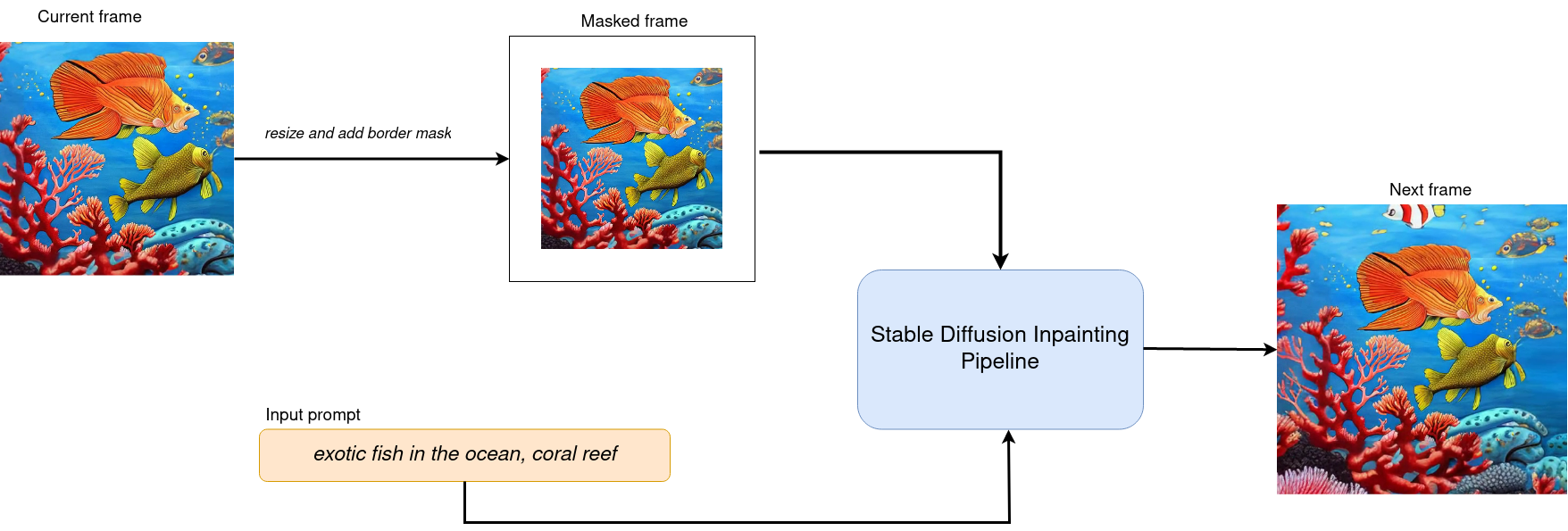

ワークフローの図は、修復のため Stable Diffusion 修復パイプラインがどのように機能するかを説明しています:

sd2-inpainting#

このパイプラインは、前のセクションで説明したテキストから画像への生成パイプラインと多くの共通点があります。テキストプロンプトに加えて、パイプラインは入力ソースイメージと、変更する必要があるイメージ領域を提供するマスクを受け入れます。マスクされた画像は、VAE エンコーダーによって潜在拡散空間にエンコードされ、ランダムに生成された画像表現 (初期ステップのみ) または U-Net 潜在生成画像表現によって生成された画像表現と連結され、次のステップのノイズ除去の入力として使用されます。

この修復機能を使用すると、一定のマージンで画像を縮小し、新しいフレームごとにこの境界をマスクすることで、プロンプトに基づいて興味深いズームアウト・ビデオを作成できます。

必要条件#

必要なパッケージをインストール

%pip install -q "diffusers>=0.14.0" "transformers>=4.25.1" "gradio>=4.19" "openvino>=2024.2.0" "torch>=2.1" Pillow opencv-python "git+https://github.com/huggingface/optimum-intel.git" --extra-index-url https://download.pytorch.org/whl/cpuOptimum Intel 使用する Stable Diffusion 修復パイプラインをロード#

Hugging Face Hub から最適化された Stable Diffusion モデルを読み込み、Optimum Intel の OpenVINO ランタイムを使用して推論を実行するパイプラインを作成します。

Optimum Intel で Stable Diffusion モデルを実行するには、推論パイプラインを表す optimum.intel.OVStableDiffusionInpaintPipeline クラスを使用する必要があります。OVStableDiffusionInpaintPipeline は from_pretrained メソッドによって初期化されます。export=True パラメーターを使用して、PyTorch からのオンザフライ変換モデルをサポートします。変換されたモデルは、次回の実行のため save_pretrained メソッドを使用してディスクに保存できます。

OpenVINO を使用して推論を実行するデバイスをドロップダウン・リストから選択します。

import ipywidgets as widgets

import openvino as ov

core = ov.Core()

device = widgets.Dropdown(

options=core.available_devices + ["AUTO"],

value="AUTO",

description="Device:",

disabled=False,

)

devicefrom optimum.intel.openvino import OVStableDiffusionInpaintPipeline

from pathlib import Path

DEVICE = device.value

MODEL_ID = "stabilityai/stable-diffusion-2-inpainting"

MODEL_DIR = Path("sd2_inpainting")

if not MODEL_DIR.exists():

ov_pipe = OVStableDiffusionInpaintPipeline.from_pretrained(MODEL_ID, export=True, device=DEVICE, compile=False)

ov_pipe.save_pretrained(MODEL_DIR)

else:

ov_pipe = OVStableDiffusionInpaintPipeline.from_pretrained(MODEL_DIR, device=DEVICE, compile=False)

ov_pipe.compile()ズームビデオ生成#

ズーム効果を実現するため、インペインティングを使用して画像を元の境界を超えて拡大します。ループ内で OVStableDiffusionInpaintPipeline を実行し、次のフレームごとに前のフレームにエッジを追加します。フレーム生成プロセスは以下の図に示されています:

フレーム生成#

現在のフレームを処理した後、各側からマスクサイズのピクセルだけ現在の画像のサイズを縮小し、次のステップの入力として使用します。マスクのサイズを変更すると、ペイント領域のサイズと画像のスケーリングに影響します。

ズームの方向は 2 つあります:

ズームアウト - 物体から離れます

ズームイン - 物体に近づきます

ズームインはズームアウトと同じように処理されますが、生成が完了した後、フレームを逆の順序で記録します。

from typing import List, Union

import PIL

import cv2

from tqdm import trange

import numpy as np

def generate_video(

pipe,

prompt: Union[str, List[str]],

negative_prompt: Union[str, List[str]],

guidance_scale: float = 7.5,

num_inference_steps: int = 20,

num_frames: int = 20,

mask_width: int = 128,

seed: int = 9999,

zoom_in: bool = False,

): """

Zoom video generation function

Parameters:

pipe (OVStableDiffusionInpaintingPipeline): inpainting pipeline.

prompt (str or List[str]): The prompt or prompts to guide the image generation.

negative_prompt (str or List[str]): The negative prompt or prompts to guide the image generation.

guidance_scale (float, *optional*, defaults to 7.5):

Guidance scale as defined in Classifier-Free Diffusion Guidance(https://arxiv.org/abs/2207.12598).

guidance_scale is defined as `w` of equation 2.

Higher guidance scale encourages to generate images that are closely linked to the text prompt,

usually at the expense of lower image quality.

num_inference_steps (int, *optional*, defaults to 50): The number of denoising steps for each frame. More denoising steps usually lead to a higher quality image at the expense of slower inference.

num_frames (int, *optional*, 20): number frames for video.

mask_width (int, *optional*, 128): size of border mask for inpainting on each step.

zoom_in (bool, *optional*, False): zoom mode Zoom In or Zoom Out.

Returns:

output_path (str): Path where generated video loacated.

"""

height = 512

width = height

current_image = PIL.Image.new(mode="RGBA", size=(height, width))

mask_image = np.array(current_image)[:, :, 3]

mask_image = PIL.Image.fromarray(255 - mask_image).convert("RGB")

current_image = current_image.convert("RGB")

init_images = pipe(

prompt=prompt,

negative_prompt=negative_prompt,

image=current_image,

guidance_scale=guidance_scale,

mask_image=mask_image,

num_inference_steps=num_inference_steps,

).images

image_grid(init_images, rows=1, cols=1)

num_outpainting_steps = num_frames

num_interpol_frames = 30

current_image = init_images[0]

all_frames = []

all_frames.append(current_image)

for i in trange(

num_outpainting_steps,

desc=f"Generating {num_outpainting_steps} additional images...",

):

prev_image_fix = current_image

prev_image = shrink_and_paste_on_blank(current_image, mask_width)

current_image = prev_image

# マスクを作成 (白い mask_width 幅のエッジを持つ黒い画像)

mask_image = np.array(current_image)[:, :, 3]

mask_image = PIL.Image.fromarray(255 - mask_image).convert("RGB")

# 修復ステップ

current_image = current_image.convert("RGB")

images = pipe(

prompt=prompt,

negative_prompt=negative_prompt,

image=current_image,

guidance_scale=guidance_scale,

mask_image=mask_image,

num_inference_steps=num_inference_steps,

).images

current_image = images[0]

current_image.paste(prev_image, mask=prev_image)

# 2 つの修復画像間の補間ステップ (= 連続ズームと切り取り)

for j in range(num_interpol_frames - 1):

interpol_image = current_image

interpol_width = round((1 - (1 - 2 * mask_width / height) ** (1 - (j + 1) / num_interpol_frames)) * height / 2)

interpol_image = interpol_image.crop(

(

interpol_width,

interpol_width,

width - interpol_width,

height - interpol_width,

)

)

interpol_image = interpol_image.resize((height, width))

# ズームによる画質の低下を避けるため、高解像度の前の画像を中央に貼り付け

interpol_width2 = round((1 - (height - 2 * mask_width) / (height - 2 * interpol_width)) / 2 * height)

prev_image_fix_crop = shrink_and_paste_on_blank(prev_image_fix, interpol_width2)

interpol_image.paste(prev_image_fix_crop, mask=prev_image_fix_crop)

all_frames.append(interpol_image)

all_frames.append(current_image)

video_file_name = f"infinite_zoom_{'in' if zoom_in else 'out'}"

fps = 30

save_path = video_file_name + ".mp4"

write_video(save_path, all_frames, fps, reversed_order=zoom_in)

return save_pathdef shrink_and_paste_on_blank(current_image: PIL.Image.Image, mask_width: int):

"""

Decreases size of current_image by mask_width pixels from each side,

then adds a mask_width width transparent frame,

so that the image the function returns is the same size as the input.

Parameters:

current_image (PIL.Image): input image to transform

mask_width (int): width in pixels to shrink from each side

Returns:

prev_image (PIL.Image): resized image with extended borders

"""

height = current_image.height

width = current_image.width

# mask_width で縮小

prev_image = current_image.resize((height - 2 * mask_width, width - 2 * mask_width))

prev_image = prev_image.convert("RGBA")

prev_image = np.array(prev_image)

# 空白の不透明画像を作成

blank_image = np.array(current_image.convert("RGBA")) * 0

blank_image[:, :, 3] = 1

# 縮小して空白部分に貼り付け

blank_image[mask_width : height - mask_width, mask_width : width - mask_width, :]= prev_image

prev_image = PIL.Image.fromarray(blank_image)

return prev_image

def image_grid(imgs: List[PIL.Image.Image], rows: int, cols: int):

"""

Insert images to grid

Parameters:

imgs (List[PIL.Image.Image]): list of images for making grid

rows (int): number of rows in grid

cols (int): number of columns in grid

Returns:

grid (PIL.Image): image with input images collage

"""

assert len(imgs) == rows * cols

w, h = imgs[0].size

grid = PIL.Image.new("RGB", size=(cols * w, rows * h))

for i, img in enumerate(imgs):

grid.paste(img, box=(i % cols * w, i // cols * h))

return grid

def write_video(

file_path: str,

frames: List[PIL.Image.Image],

fps: float,

reversed_order: bool = True,

gif: bool = True,

): """

Writes frames to an mp4 video file and optionaly to gif

Parameters:

file_path (str): Path to output video, must end with .mp4

frames (List of PIL.Image): list of frames

fps (float): Desired frame rate

reversed_order (bool): if order of images to be reversed (default = True)

gif (bool): save frames to gif format (default = True)

Returns: None

"""

if reversed_order:

frames.reverse()

w, h = frames[0].size

fourcc = cv2.VideoWriter_fourcc("m", "p", "4", "v")

writer = cv2.VideoWriter(file_path, fourcc, fps, (w, h))

for frame in frames:

np_frame = np.array(frame.convert("RGB"))

cv_frame = cv2.cvtColor(np_frame, cv2.COLOR_RGB2BGR)

writer.write(cv_frame)

writer.release()

if gif:

frames[0].save(

file_path.replace(".mp4", ".gif"),

save_all=True,

append_images=frames[1:],

duratiobn=len(frames) / fps,

loop=0,

)無限ズームビデオ生成を実行#

import gradio as gr

def generate(

prompt,

negative_prompt,

seed,

steps,

frames,

edge_size,

zoom_in,

progress=gr.Progress(track_tqdm=True),

):

np.random.seed(seed)

video_path = generate_video(

ov_pipe,

prompt,

negative_prompt,

num_inference_steps=steps,

num_frames=frames,

mask_width=edge_size,

zoom_in=zoom_in,

)

np.random.seed(None)

return video_path.replace(".mp4", ".gif")

gr.close_all()

demo = gr.Interface(

generate,

[

gr.Textbox(

"valley in the Alps at sunset, epic vista, beautiful landscape, 4k, 8k",

label="Prompt",

),

gr.Textbox("lurry, bad art, blurred, text, watermark", label="Negative prompt"),

gr.Slider(value=9999, label="Seed", step=1, maximum=10000000),

gr.Slider(value=20, label="Steps", minimum=1, maximum=50),

gr.Slider(value=3, label="Frames", minimum=1, maximum=50),

gr.Slider(value=128, label="Edge size", minimum=32, maximum=256),

gr.Checkbox(label="Zoom in"),

],

"image",

)

try:

demo.queue().launch()

except Exception:

demo.queue().launch(share=True)

# リモートで起動する場合は、server_name と server_port を指定

# demo.launch(server_name='your server name', server_port='server port in int')

# 詳細については、ドキュメントをご覧ください: https://gradio.app/docs/