OpenVINO を使用した YOLOv10 の変換と最適化#

この Jupyter ノートブックは、ローカルへのインストール後にのみ起動できます。

リアルタイムのオブジェクト検出は、低レイテンシーで画像内のオブジェクトのカテゴリーと位置を正確に予測することを目的としています。YOLO シリーズは、パフォーマンスと効率性のバランスにより、この研究の最前線にあります。しかし、NMS への依存とアーキテクチャーの非効率性により、最適なパフォーマンスが妨げられていました。YOLOv10 は、NMS フリーのトレーニングの一貫したデュアル割り当てと、全体的な効率と精度を重視したモデル設計戦略を導入することで、これらの問題に対処します。

清華大学の研究者によって Ultralytics Python パッケージ上に構築された YOLOv10 は、リアルタイムのオブジェクト検出に対する新しいアプローチを導入し、以前の YOLO バージョンの後処理とモデル・アーキテクチャーの欠陥に対処します。YOLOv10 は、非最大抑制 (NMS) を排除し、さまざまなモデル・コンポーネントを最適化することで、計算オーバーヘッドを大幅に削減し最先端のパフォーマンスを実現します。広範囲にわたる実験により、複数のモデルスケールにおいて優れた精度とレイテンシーのトレードオフが実証されています。

yolov10-approach.png#

モデル・アーキテクチャーの詳細については、オリジナルのリポジトリー、論文、Ultralytics ドキュメントを参照してください。

このチュートリアルでは、OpenVINO を使用して PyTorch YOLO V10 を実行および最適化する手順を段階的に説明します。

このチュートリアルは次のステップで構成されます:

PyTorch モデルの準備

PyTorch モデルを OpenVINO IR に変換

OpenVINO でモデル推論を実行

NNCF を使用して最適化パイプラインの準備と実行

FP16 モデルと量子化モデルのパフォーマンスを比較します。

ビデオで最適化されたモデル推論を実行

インタラクティブな Gradio デモを起動

目次:

必要条件#

import os

os.environ["GIT_CLONE_PROTECTION_ACTIVE"] = "false"

%pip install -q "nncf>=2.11.0"

%pip install --pre -Uq openvino --extra-index-url https://storage.openvinotoolkit.org/simple/wheels/nightly

%pip install -q "git+https://github.com/THU-MIG/yolov10.git" --extra-index-url https://download.pytorch.org/whl/cpu

%pip install -q "torch>=2.1" "torchvision>=0.16" tqdm opencv-python "gradio>=4.19" --extra-index-url https://download.pytorch.org/whl/cpuWARNING: Skipping openvino as it is not installed.

WARNING: Skipping openvino-dev as it is not installed.

Note: you may need to restart the kernel to use updated packages.

Note: you may need to restart the kernel to use updated packages.

Note: you may need to restart the kernel to use updated packages.

Note: you may need to restart the kernel to use updated packages.from pathlib import Path

# `notebook_utils` モジュールを取得

import requests

r = requests.get(

url="https://raw.githubusercontent.com/openvinotoolkit/openvino_notebooks/latest/utils/notebook_utils.py",

)

open("notebook_utils.py", "w").write(r.text)

from notebook_utils import download_filePyTorch モデルをダウンロード#

モデル作成者によって提供される YOLO V10 モデルには、いくつかのバージョンがあります。それぞれ、トレーニング・パラメーターの数、パフォーマンス、精度に応じて異なる特性を持ちます。デモには yolov10n を使用しますが、同じ手順は YOLO V10 シリーズの他のモデルにも適用できます。

models_dir = Path("./models")

models_dir.mkdir(exist_ok=True)model_weights_url = "https://github.com/jameslahm/yolov10/releases/download/v1.0/yolov10n.pt"

file_name = model_weights_url.split("/")[-1]

model_name = file_name.replace(".pt", "")

download_file(model_weights_url, directory=models_dir)'models/yolov10n.pt' already exists.PosixPath('/home/ea/work/openvino_notebooks_new_clone/openvino_notebooks/notebooks/yolov10-optimization/models/yolov10n.pt')PyTorch モデルを OpenVINO IR 形式にエクスポート#

前述したように、YOLO V10 コードは Ultralytics ライブラリーをベースに設計されており、YOLO V8 と同様のインターフェイスを備えています (Ultralytics API の使用方法の詳細手順については、YOLO V8 ノートブックを参照してください)。Ultralytics は、モデルクラスのエクスポート・メソッドを使用して OpenVINO モデルのエクスポートをサポートします。さらに、ターゲット入力サイズ、静的または動的入力形状、モデル精度 (FP32/FP16/INT8) を決定するパラメーターを指定することもできます。INT8 量子化はエクスポート・ステージで追加で実行できますが、アプローチをより柔軟にするため、NNCF を使用して量子化を実行する方法を検討します。

import types

from ultralytics.utils import ops, yaml_load, yaml_save

from ultralytics import YOLOv10

import torch

detection_labels = {

0: "person",

1: "bicycle",

2: "car",

3: "motorcycle",

4: "airplane",

5: "bus",

6: "train",

7: "truck",

8: "boat",

9: "traffic light",

10: "fire hydrant",

11: "stop sign",

12: "parking meter",

13: "bench",

14: "bird",

15: "cat",

16: "dog",

17: "horse",

18: "sheep",

19: "cow",

20: "elephant",

21: "bear",

22: "zebra",

23: "giraffe",

24: "backpack",

25: "umbrella",

26: "handbag",

27: "tie",

28: "suitcase",

29: "frisbee",

30: "skis",

31: "snowboard",

32: "sports ball",

33: "kite",

34: "baseball bat",

35: "baseball glove",

36: "skateboard",

37: "surfboard",

38: "tennis racket",

39: "bottle",

40: "wine glass",

41: "cup",

42: "fork",

43: "knife",

44: "spoon",

45: "bowl",

46: "banana",

47: "apple",

48: "sandwich",

49: "orange",

50: "broccoli",

51: "carrot",

52: "hot dog",

53: "pizza",

54: "donut",

55: "cake",

56: "chair",

57: "couch",

58: "potted plant",

59: "bed",

60: "dining table",

61: "toilet",

62: "tv",

63: "laptop",

64: "mouse",

65: "remote",

66: "keyboard",

67: "cell phone",

68: "microwave",

69: "oven",

70: "toaster",

71: "sink",

72: "refrigerator",

73: "book",

74: "clock",

75: "vase",

76: "scissors",

77: "teddy bear",

78: "hair drier",

79: "toothbrush",

}

def v10_det_head_forward(self, x):

one2one = self.forward_feat([xi.detach() for xi in x], self.one2one_cv2, self.one2one_cv3)

if not self.export:

one2many = super().forward(x)

if not self.training:

one2one = self.inference(one2one)

if not self.export:

return {"one2many": one2many, "one2one": one2one}

else:

assert self.max_det != -1

boxes, scores, labels = ops.v10postprocess(one2one.permute(0, 2, 1), self.max_det, self.nc)

return torch.cat(

[boxes, scores.unsqueeze(-1), labels.unsqueeze(-1).to(boxes.dtype)],

dim=-1,

)

else:

return {"one2many": one2many, "one2one": one2one}

ov_model_path = models_dir / f"{model_name}_openvino_model/{model_name}.xml"

if not ov_model_path.exists():

model = YOLOv10(models_dir / file_name)

model.model.model[-1].forward = types.MethodType(v10_det_head_forward, model.model.model[-1])

model.export(format="openvino", dynamic=True, half=True)

config = yaml_load(ov_model_path.parent / "metadata.yaml")

config["names"] = detection_labels

yaml_save(ov_model_path.parent / "metadata.yaml", config)Ultralytics API を使用して AUTO デバイスで OpenVINO 推論を実行#

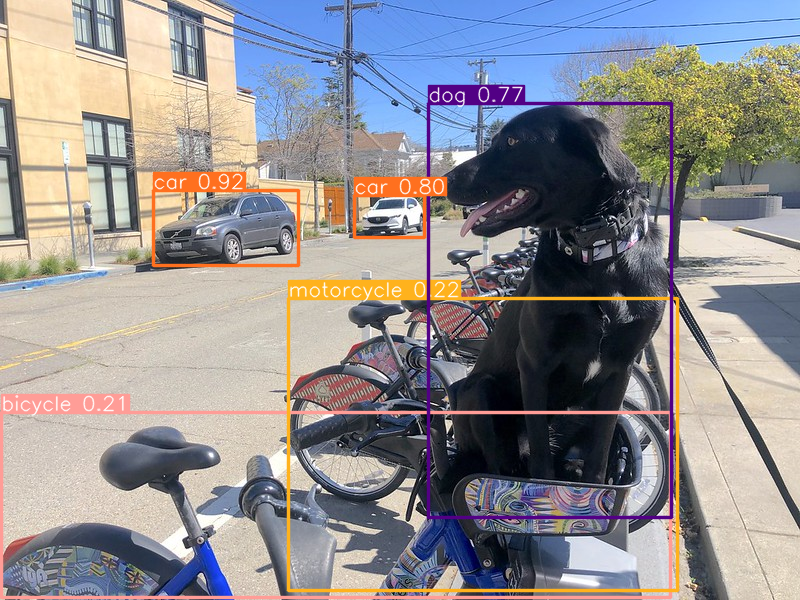

これで、モデルを OpenVINO にエクスポートすることで、YOLOv10 クラスに直接ロードできるようになりました。自動推論バックエンドにより、元の PyTorch モデルと同様のレベルで OpenVINO YOLOv10 モデルを実行する使いやすいユーザー・エクスペリエンスが提供されます。以下のコードは、Ultralytics API を使用して単一のイメージで推論 OpenVINO エクスポート・モデルを実行する方法を示しています。モデルの起動には AUTO デバイスが使用されます。

ov_yolo_model = YOLOv10(ov_model_path.parent, task="detect")from PIL import Image

IMAGE_PATH = Path("./data/coco_bike.jpg")

download_file(

url="https://storage.openvinotoolkit.org/repositories/openvino_notebooks/data/data/image/coco_bike.jpg",

filename=IMAGE_PATH.name,

directory=IMAGE_PATH.parent,

)'data/coco_bike.jpg' already exists.PosixPath('/home/ea/work/openvino_notebooks_new_clone/openvino_notebooks/notebooks/yolov10-optimization/data/coco_bike.jpg')res = ov_yolo_model(IMAGE_PATH, iou=0.45, conf=0.2)

Image.fromarray(res[0].plot()[:, :, ::-1])Loading models/yolov10n_openvino_model for OpenVINO inference...

requirements: Ultralytics requirement ['openvino>=2024.0.0'] not found, attempting AutoUpdate...

requirements: ❌ AutoUpdate skipped (offline)

Using OpenVINO LATENCY mode for batch=1 inference...

image 1/1 /home/ea/work/openvino_notebooks_new_clone/openvino_notebooks/notebooks/yolov10-optimization/data/coco_bike.jpg: 640x640 1 bicycle, 2 cars, 1 motorcycle, 1 dog, 72.0ms

Speed: 25.6ms preprocess, 72.0ms inference, 0.6ms postprocess per image at shape (1, 3, 640, 640)

Ultralytics API を使用して選択したデバイスで OpenVINO 推論を実行#

このノートブックでは、モデル推論を実行するため推論デバイスを選択して、結果を AUTO と比較できます。

import openvino as ov

import ipywidgets as widgets

core = ov.Core()

device = widgets.Dropdown(

options=core.available_devices + ["AUTO"],

value="CPU",

description="Device:",

disabled=False,

)

deviceDropdown(description='Device:', options=('CPU', 'GPU.0', 'GPU.1', 'AUTO'), value='CPU')ov_model = core.read_model(ov_model_path)

# 選択したデバイスにモデルをロード

if "GPU" in device.value or "NPU" in device.value:

ov_model.reshape({0: [1, 3, 640, 640]})

ov_config = {}

if "GPU" in device.value:

ov_config = {"GPU_DISABLE_WINOGRAD_CONVOLUTION": "YES"}

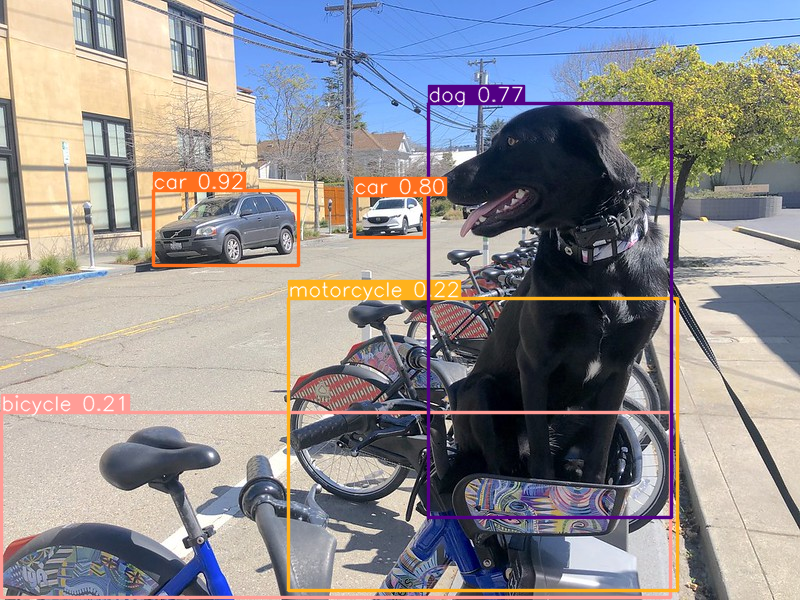

det_compiled_model = core.compile_model(ov_model, device.value, ov_config)ov_yolo_model.predictor.model.ov_compiled_model = det_compiled_modelres = ov_yolo_model(IMAGE_PATH, iou=0.45, conf=0.2)image 1/1 /home/ea/work/openvino_notebooks_new_clone/openvino_notebooks/notebooks/yolov10-optimization/data/coco_bike.jpg: 640x640 1 bicycle, 2 cars, 1 motorcycle, 1 dog, 29.1ms

Speed: 3.2ms preprocess, 29.1ms inference, 0.3ms postprocess per image at shape (1, 3, 640, 640)Image.fromarray(res[0].plot()[:, :, ::-1])

NNCF トレーニング後の量子化 API を使用してモデルを最適化#

NNCF は、精度の低下を最小限に抑えながら、OpenVINO でニューラル・ネットワーク推論を最適化する一連の高度なアルゴリズムを提供します。YOLOv10 を最適化するため、ポストトレーニング・モード (微調整パイプラインなし) で 8 ビット量子化を使用します。

最適化プロセスには次の手順が含まれます:

量子化用のデータセットを作成します。

nncf.quantizeを実行して、最適化されたモデルを取得します。openvino.save_model関数を使用して、OpenVINO IR モデルをシリアル化します。

量子化は時間とメモリーを消費するプロセスです。以下のチェックボックスでこの手順をスキップできます:

import ipywidgets as widgets

int8_model_det_path = models_dir / "int8" / f"{model_name}_openvino_model/{model_name}.xml" ov_yolo_int8_model = None

to_quantize = widgets.Checkbox(

value=True,

description="Quantization",

disabled=False,

)

to_quantizeCheckbox(value=True, description='Quantization')# skip_kernel_extension モジュールを取得

r = requests.get(

url="https://raw.githubusercontent.com/openvinotoolkit/openvino_notebooks/latest/utils/skip_kernel_extension.py",

)

open("skip_kernel_extension.py", "w").write(r.text)

%load_ext skip_kernel_extension量子化データセットを準備#

量子化を開始するには、データセットを準備する必要があります。モデルの量子化には MS COCO データセットの検証サブセットを使用し、入力データの準備には Ultralytics 検証データローダーを使用します。

%%skip not $to_quantize.value

from zipfile import ZipFile

from ultralytics.data.utils import DATASETS_DIR

if not int8_model_det_path.exists():

DATA_URL = "http://images.cocodataset.org/zips/val2017.zip"

LABELS_URL = "https://github.com/ultralytics/yolov5/releases/download/v1.0/coco2017labels-segments.zip"

CFG_URL = "https://raw.githubusercontent.com/ultralytics/ultralytics/v8.1.0/ultralytics/cfg/datasets/coco.yaml"

OUT_DIR = DATASETS_DIR

DATA_PATH = OUT_DIR / "val2017.zip"

LABELS_PATH = OUT_DIR / "coco2017labels-segments.zip"

CFG_PATH = OUT_DIR / "coco.yaml"

download_file(DATA_URL, DATA_PATH.name, DATA_PATH.parent)

download_file(LABELS_URL, LABELS_PATH.name, LABELS_PATH.parent)

download_file(CFG_URL, CFG_PATH.name, CFG_PATH.parent)

if not (OUT_DIR / "coco/labels").exists():

with ZipFile(LABELS_PATH, "r") as zip_ref:

zip_ref.extractall(OUT_DIR)

with ZipFile(DATA_PATH, "r") as zip_ref:

zip_ref.extractall(OUT_DIR / "coco/images")%%skip not $to_quantize.value

from ultralytics.utils import DEFAULT_CFG

from ultralytics.cfg import get_cfg

from ultralytics.data.converter import coco80_to_coco91_class

from ultralytics.data.utils import check_det_dataset

if not int8_model_det_path.exists():

args = get_cfg(cfg=DEFAULT_CFG)

args.data = str(CFG_PATH)

det_validator = ov_yolo_model.task_map[ov_yolo_model.task]["validator"](args=args)

det_validator.data = check_det_dataset(args.data)

det_validator.stride = 32

det_data_loader = det_validator.get_dataloader(OUT_DIR / "coco", 1)NNCF は、量子化パイプラインでネイティブ・フレームワーク・データローダーを使用する nncf.Dataset ラッパーを提供します。さらに、モデルが期待する形式で入力データを準備する変換関数を指定します。

%%skip not $to_quantize.value

import nncf

from typing import Dict

def transform_fn(data_item:Dict):

"""

Quantization transform function. Extracts and preprocess input data from dataloader item for quantization.

Parameters:

data_item: Dict with data item produced by DataLoader during iteration

Returns:

input_tensor: Input data for quantization

"""

input_tensor = det_validator.preprocess(data_item)['img'].numpy()

return input_tensor

if not int8_model_det_path.exists():

quantization_dataset = nncf.Dataset(det_data_loader, transform_fn)INFO:nncf:NNCF initialized successfully.サポートされているフレームワークが検出されました : torch, openvinoINT8 モデルを量子化して保存#

nncf.quantize 関数は、モデル量子化のインターフェイスを提供します。OpenVINO モデルのインスタンスと量子化データセットが必要です。オプションで、量子化プロセスの追加パラメーター (量子化のサンプル数、プリセット、無視される範囲など) を提供できます。YOLOv10 モデルには、活性化の非対称量子化を必要とする非 ReLU 活性化関数が含まれています。さらに良い結果を得るため、混合量子化プリセットを使用します。これは、重みの対称量子化と活性化の非対称量子化を提供します。

注: モデルのトレーニング後の量子化は時間のかかるプロセスです。ハードウェアによっては数分かかる場合があります。

%%skip not $to_quantize.value

import shutil

if not int8_model_det_path.exists():

quantized_det_model = nncf.quantize(

ov_model,

quantization_dataset,

preset=nncf.QuantizationPreset.MIXED,

)

ov.save_model(quantized_det_model, int8_model_det_path)

shutil.copy(ov_model_path.parent / "metadata.yaml", int8_model_det_path.parent / "metadata.yaml")最適化されたモデル推論を実行#

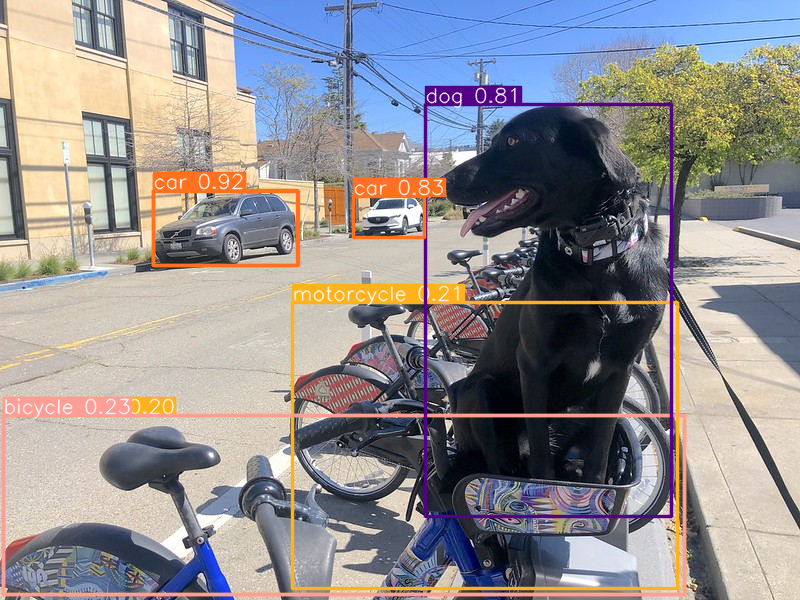

INT8 量子化モデルの使用方法は、量子化前のモデルと同じです。単一画像での量子化モデルの推論結果を確認してみます

AUTO デバイスで最適化モデルを実行#

%%skip not $to_quantize.value

ov_yolo_int8_model = YOLOv10(int8_model_det_path.parent, task="detect")%%skip not $to_quantize.value

res = ov_yolo_int8_model(IMAGE_PATH, iou=0.45, conf=0.2)Loading models/int8/yolov10n_openvino_model for OpenVINO inference...

requirements: Ultralytics requirement ['openvino>=2024.0.0'] not found, attempting AutoUpdate...

requirements: ❌ AutoUpdate skipped (offline)

Using OpenVINO LATENCY mode for batch=1 inference...

image 1/1 /home/ea/work/openvino_notebooks_new_clone/openvino_notebooks/notebooks/yolov10-optimization/data/coco_bike.jpg: 640x640 1 bicycle, 3 cars, 2 motorcycles, 1 dog, 92.3ms

Speed: 3.7ms preprocess, 92.3ms inference, 0.4ms postprocess per image at shape (1, 3, 640, 640)Image.fromarray(res[0].plot()[:, :, ::-1])

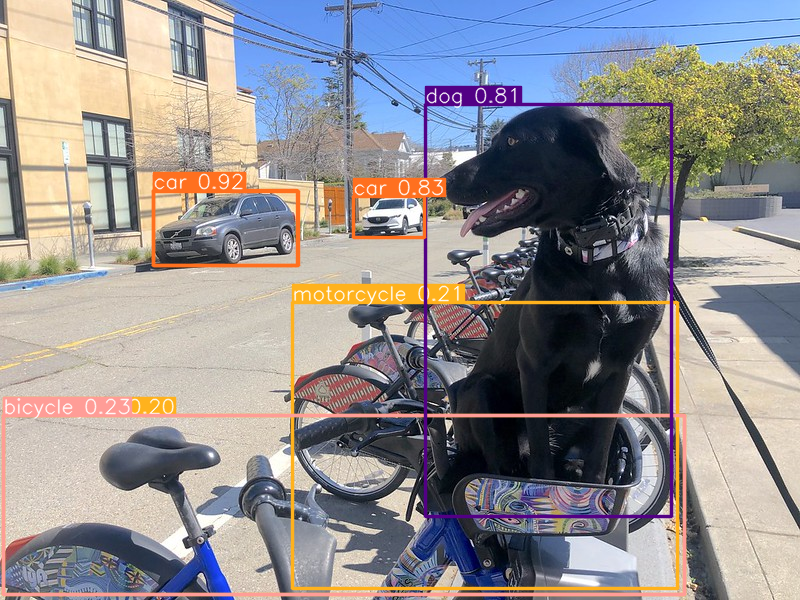

選択したデバイスで最適化されたモデル推論を実行#

%%skip not $to_quantize.value

device%%skip not $to_quantize.value

ov_config = {}

if "GPU" in device.value or "NPU" in device.value:

ov_model.reshape({0: [1, 3, 640, 640]})

ov_config = {}

if "GPU" in device.value:

ov_config = {"GPU_DISABLE_WINOGRAD_CONVOLUTION": "YES"}

quantized_det_model = core.read_model(int8_model_det_path)

quantized_det_compiled_model = core.compile_model(quantized_det_model, device.value, ov_config)

ov_yolo_int8_model.predictor.model.ov_compiled_model = quantized_det_compiled_model

res = ov_yolo_int8_model(IMAGE_PATH, iou=0.45, conf=0.2)image 1/1 /home/ea/work/openvino_notebooks_new_clone/openvino_notebooks/notebooks/yolov10-optimization/data/coco_bike.jpg: 640x640 1 bicycle, 3 cars, 2 motorcycles, 1 dog, 26.5ms

Speed: 7.4ms preprocess, 26.5ms inference, 0.3ms postprocess per image at shape (1, 3, 640, 640)Image.fromarray(res[0].plot()[:, :, ::-1])

元のモデルと量子化モデルを比較#

モデルサイズ#

ov_model_weights = ov_model_path.with_suffix(".bin")

print(f"Size of FP16 model is {ov_model_weights.stat().st_size / 1024 / 1024:.2f} MB")

if int8_model_det_path.exists():

ov_int8_weights = int8_model_det_path.with_suffix(".bin")

print(f"Size of model with INT8 compressed weights is {ov_int8_weights.stat().st_size / 1024 / 1024:.2f} MB")

print(f"Compression rate for INT8 model: {ov_model_weights.stat().st_size / ov_int8_weights.stat().st_size:.3f}")Size of FP16 model is 4.39 MB

Size of model with INT8 compressed weights is 2.25 MB

Compression rate for INT8 model: 1.954パフォーマンス#

FP16 モデルのパフォーマンス#

!benchmark_app -m $ov_model_path -d $device.value -api async -shape "[1,3,640,640]" -t 15[Step 1/11] Parsing and validating input arguments [ INFO ] Parsing input parameters [Step 2/11] Loading OpenVINO Runtime [ INFO ] OpenVINO: [ INFO ] Build .................................2024.2.0-15496-17f8e86e5f2-releases/2024/2 [ INFO ] [ INFO ] Device info: [ INFO ] CPU [ INFO ] Build .................................2024.2.0-15496-17f8e86e5f2-releases/2024/2 [ INFO ] [ INFO ] [Step 3/11] Setting device configuration [ WARNING ] Performance hint was not explicitly specified in command line.Device(CPU) performance hint will be set to PerformanceMode.THROUGHPUT. [Step 4/11] Reading model files [ INFO ] Loading model files [ INFO ] Read model took 31.92 ms [ INFO ] Original model I/O parameters: [ INFO ] Model inputs: [ INFO ] x (node: x) : f32 / [...]/ [?,3,?,?] [ INFO ] Model outputs: [ INFO ] *NO_NAME* (node: __module.model.23/aten::cat/Concat_8) : f32 / [...] / [?,300.6] [Step 5/11] Resizing model to match image sizes and given batch [ INFO ] Model batch size: 1 [ INFO ] Reshaping model: 'x': [1,3,640,640] [ INFO ] Reshape model took 17.77 ms [Step 6/11] Configuring input of the model [ INFO ] Model inputs: [ INFO ] x (node: x) : u8 / [N,C,H,W] / [1,3,640,640] [ INFO ] Model outputs: [ INFO ] *NO_NAME* (node: __module.model.23/aten::cat/Concat_8) : f32 / [...] / [1,300,6] [Step 7/11] Loading the model to the device [ INFO ] Compile model took 303.83 ms [Step 8/11] Querying optimal runtime parameters [ INFO ] Model: [ INFO ] NETWORK_NAME: Model0 [ INFO ] OPTIMAL_NUMBER_OF_INFER_REQUESTS: 12 [ INFO ] NUM_STREAMS: 12 [ INFO ] INFERENCE_NUM_THREADS: 36 [ INFO ] PERF_COUNT: NO [ INFO ] SCHEDULING_CORE_TYPE: <Type: 'float32'> [ INFO ] PERFORMANCE_HINT: THROUGHPUT [ INFO ] EXECUTION_MODE_HINT: ExecutionMode. PERFORMANCE [ INFO ] PERFORMANCE_HINT_NUM_REQUESTS: 0 [ INFO ] ENABLE_CPU_PINNING: True [ INFO ] SCHEDULING_CORE_TYPE: SchedulingCoreType.ANY_CORE [ INFO ] MODEL_DISTRIBUTION_POLICY: set() [ INFO ] ENABLE_HYPER_THREADING: True [ INFO ] EXECUTION_DEVICES: ['CPU'] [ INFO ] CPU_DENORMALS_OPTIMIZATION: False [ INFO ] LOG_LEVEL: Level. NO [ INFO ] CPU_SPARSE_WEIGHTS_DECOMPRESSION_RATE: 1.0 [ INFO ] DYNAMIC_QUANTIZATION_GROUP_SIZE: 0 [ INFO ] KV_CACHE_PRECISION: <Type: 'float16'> [ INFO ] AFFINITY: Affinity.CORE [Step 9/11] Creating infer requests and preparing input tensors [ WARNING ] No input files were given for input 'x'!.This input will be filled with random values! [ INFO ] Fill input 'x' with random values [Step 10/11] Measuring performance (Start inference asynchronously, 12 inference requests, limits: 15000 ms duration) [ INFO ] Benchmarking in inference only mode (inputs filling are not included in measurement loop). [ INFO ] First inference took 30.60 ms [Step 11/11] Dumping statistics report [ INFO ] Execution Devices:['CPU'] [ INFO ] Count: 2424 iterations [ INFO ] Duration: 15093.22 ms [ INFO ] Latency: [ INFO ] Median: 72.34 ms [ INFO ] Average: 74.46 ms [ INFO ] Min: 45.87 ms [ INFO ] Max: 147.25 ms [ INFO ] Throughput: 160.60 FPS

Int8 モデルのパフォーマンス#

if int8_model_det_path.exists():

!benchmark_app -m $int8_model_det_path -d $device.value -api async -shape "[1,3,640,640]" -t 15[Step 1/11] Parsing and validating input arguments [ INFO ] Parsing input parameters [Step 2/11] Loading OpenVINO Runtime [ INFO ] OpenVINO: [ INFO ] Build .................................2024.2.0-15496-17f8e86e5f2-releases/2024/2 [ INFO ] [ INFO ] Device info: [ INFO ] CPU [ INFO ] Build .................................2024.2.0-15496-17f8e86e5f2-releases/2024/2 [ INFO ] [ INFO ] [Step 3/11] Setting device configuration [ WARNING ] Performance hint was not explicitly specified in command line.Device(CPU) performance hint will be set to PerformanceMode.THROUGHPUT. [Step 4/11] Reading model files [ INFO ] Loading model files [ INFO ] Read model took 38.75 ms [ INFO ] Original model I/O parameters: [ INFO ] Model inputs: [ INFO ] x (node: x) : f32 / [...]/ [?,3,?,?] [ INFO ] Model outputs: [ INFO ] *NO_NAME* (node: __module.model.23/aten::cat/Concat_8) : f32 / [...]/ [?,300.6] [Step 5/11] Resizing model to match image sizes and given batch [ INFO ] Model batch size: 1 [ INFO ] Reshaping model: 'x': [1,3,640,640] [ INFO ] Reshape model took 18.33 ms [Step 6/11] Configuring input of the model [ INFO ] Model inputs: [ INFO ] x (node: x) : u8 / [N,C,H,W] / [1,3,640,640] [ INFO ] Model outputs: [ INFO ] *NO_NAME* (node: __module.model.23/aten::cat/Concat_8) : f32 / [...]/ [1,300,6] [Step 7/11] Loading the model to the device [ INFO ] Compile model took 622.99 ms [Step 8/11] Querying optimal runtime parameters [ INFO ] Model: [ INFO ] NETWORK_NAME: Model0 [ INFO ] OPTIMAL_NUMBER_OF_INFER_REQUESTS: 18 [ INFO ] NUM_STREAMS: 18 [ INFO ] INFERENCE_NUM_THREADS: 36 [ INFO ] PERF_COUNT: NO [ INFO ] SCHEDULING_CORE_TYPE: <Type: 'float32'> [ INFO ] PERFORMANCE_HINT: THROUGHPUT [ INFO ] EXECUTION_MODE_HINT: ExecutionMode. PERFORMANCE [ INFO ] PERFORMANCE_HINT_NUM_REQUESTS: 0 [ INFO ] ENABLE_CPU_PINNING: True [ INFO ] SCHEDULING_CORE_TYPE: SchedulingCoreType.ANY_CORE [ INFO ] MODEL_DISTRIBUTION_POLICY: set() [ INFO ] ENABLE_HYPER_THREADING: True [ INFO ] EXECUTION_DEVICES: ['CPU'] [ INFO ] CPU_DENORMALS_OPTIMIZATION: False [ INFO ] LOG_LEVEL: Level. NO [ INFO ] CPU_SPARSE_WEIGHTS_DECOMPRESSION_RATE: 1.0 [ INFO ] DYNAMIC_QUANTIZATION_GROUP_SIZE: 0 [ INFO ] KV_CACHE_PRECISION: <Type: 'float16'> [ INFO ] AFFINITY: Affinity.CORE [Step 9/11] Creating infer requests and preparing input tensors [ WARNING ] No input files were given for input 'x'!.This input will be filled with random values! [ INFO ] Fill input 'x' with random values [Step 10/11] Measuring performance (Start inference asynchronously, 18 inference requests, limits: 15000 ms duration) [ INFO ] Benchmarking in inference only mode (inputs filling are not included in measurement loop). [ INFO ] First inference took 28.26 ms [Step 11/11] Dumping statistics report [ INFO ] Execution Devices:['CPU'] [ INFO ] Count: 5886 iterations [ INFO ] Duration: 15067.10 ms [ INFO ] Latency: [ INFO ] Median: 44.39 ms [ INFO ] Average: 45.89 ms [ INFO ] Min: 29.73 ms [ INFO ] Max: 110.52 ms [ INFO ] Throughput: 390.65 FPS

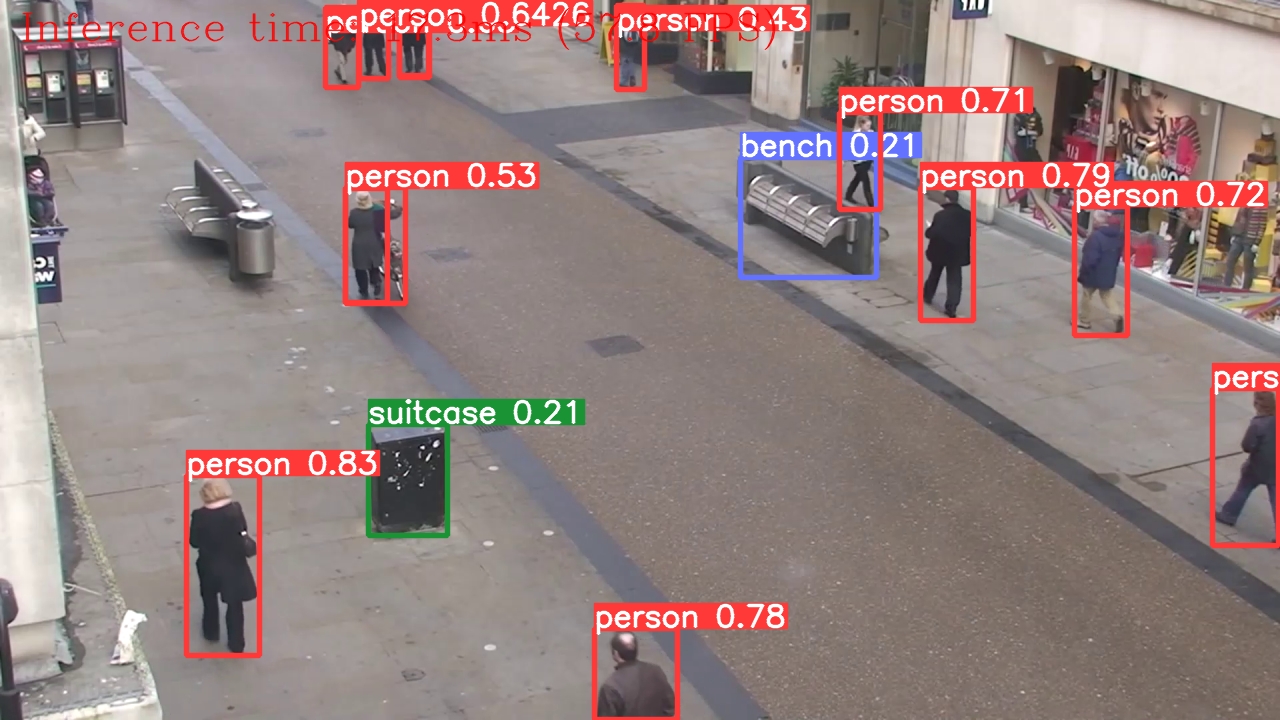

ライブデモ#

次のコードは、ビデオに対してモデル推論を実行します:

import collections

import time

from IPython import display

import cv2

import numpy as np

# 物体検出を実行するメイン処理関数

def run_object_detection(

source=0,

flip=False,

use_popup=False,

skip_first_frames=0,

det_model=ov_yolo_int8_model,

device=device.value,

):

player = None

try:

# ターゲット fps で再生するビデオプレーヤーを作成

player = VideoPlayer(source=source, flip=flip, fps=30, skip_first_frames=skip_first_frames)

# キャプチャー開始

player.start()

if use_popup:

title = "Press ESC to Exit"

cv2.namedWindow(winname=title, flags=cv2.WINDOW_GUI_NORMAL | cv2.WINDOW_AUTOSIZE)

processing_times = collections.deque()

while True:

# フレームをグラブ

frame = player.next()

if frame is None:

print("Source ended")

break

# フレームがフル HD より大きい場合は、サイズを縮小してパフォーマンスを向上させます

scale = 1280 / max(frame.shape)

if scale < 1:

frame = cv2.resize(

src=frame,

dsize=None,

fx=scale,

fy=scale,

interpolation=cv2.INTER_AREA,

)

# 結果を取得

input_image = np.array(frame)

start_time = time.time()

detections = det_model(input_image, iou=0.45, conf=0.2, verbose=False)

stop_time = time.time()

frame = detections[0].plot()

processing_times.append(stop_time - start_time)

# 最後の 200 フレームの処理時間を使用

if len(processing_times) > 200:

processing_times.popleft()

_, f_width = frame.shape[:2]

# 平均処理時間 [ms]

processing_time = np.mean(processing_times) * 1000

fps = 1000 / processing_time

cv2.putText(

img=frame,

text=f"Inference time: {processing_time:.1f}ms ({fps:.1f} FPS)",

org=(20, 40),

fontFace=cv2.FONT_HERSHEY_COMPLEX,

fontScale=f_width / 1000,

color=(0, 0, 255),

thickness=1,

lineType=cv2.LINE_AA,

)

# ちらつきがある場合はこの回避策を使用

if use_popup:

cv2.imshow(winname=title, mat=frame)

key = cv2.waitKey(1)

# escape = 27

if key == 27:

break

else:

# numpy 配列を jpg にエンコード

_, encoded_img = cv2.imencode(ext=".jpg", img=frame, params=[cv2.IMWRITE_JPEG_QUALITY, 100])

# IPython イメージを作成

i = display.Image(data=encoded_img)

# このノートブックに画像を表示

display.clear_output(wait=True)

display.display(i)

# ctrl-c

except KeyboardInterrupt:

print("Interrupted")

# 異なるエラー

except RuntimeError as e:

print(e)

finally:

if player is not None:

# キャプチャーを停止

player.stop().stop()

if use_popup:

cv2.destroyAllWindows()use_int8 = widgets.Checkbox(

value=ov_yolo_int8_model is not None,

description="Use int8 model",

disabled=ov_yolo_int8_model is None,

)

use_int8Checkbox(value=True, description='Use int8 model')WEBCAM_INFERENCE = False

if WEBCAM_INFERENCE: VIDEO_SOURCE = 0 # ウェブカメラ

else:

download_file(

"https://storage.openvinotoolkit.org/repositories/openvino_notebooks/data/data/video/people.mp4",

directory="data",

)

VIDEO_SOURCE = "data/people.mp4"'data/people.mp4' already exists.Run_object_detection((

det_model=ov_yolo_model if not use_int8.value else ov_yolo_int8_model,

source=VIDEO_SOURCE,

flip=True,

use_popup=False,

)

ソースの終わりインタラクティブな Gradio デモを起動#

import gradio as gr

def yolov10_inference(image, int8, conf_threshold, iou_threshold):

model = ov_yolo_model if not int8 else ov_yolo_int8_model

results = model(source=image, iou=iou_threshold, conf=conf_threshold, verbose=False)[0]

annotated_image = Image.fromarray(results.plot())

return annotated_image

with gr.Blocks() as demo:

gr.HTML(

"""

<h1 style='text-align: center'>

YOLOv10: Real-Time End-to-End Object Detection using OpenVINO

</h1>

"""

)

with gr.Row():

with gr.Column():

image = gr.Image(type="numpy", label="Image")

conf_threshold = gr.Slider(

label="Confidence Threshold",

minimum=0.1,

maximum=1.0,

step=0.1,

value=0.2,

)

iou_threshold = gr.Slider(

label="IoU Threshold",

minimum=0.1,

maximum=1.0,

step=0.1,

value=0.45,

)

use_int8 = gr.Checkbox(

value=ov_yolo_int8_model is not None,

visible=ov_yolo_int8_model is not None,

label="Use INT8 model",

)

yolov10_infer = gr.Button(value="Detect Objects")

with gr.Column():

output_image = gr.Image(type="pil", label="Annotated Image")

yolov10_infer.click(

fn=yolov10_inference,

inputs=[

image,

use_int8,

conf_threshold,

iou_threshold,

],

outputs=[output_image],

)

examples = gr.Examples(

[

"data/coco_bike.jpg",

],

inputs=[

image,

],

)

try:

demo.launch(debug=False)

except Exception:

demo.launch(debug=False, share=True)