NPU 全般解析を使用して、インテル® アーキテクチャー上で実行される人工知能 (AI) ワークロードのプロファイルを作成し、最適化します。

ニューラル・プロセッシング・ユニット (NPU) は、オペレーティング・システムによって明示的にオフロードされた AI ワークロードのパフォーマンスを高速化できます。NPU は、AI およびマシンラーニング (ML) ワークロードのパフォーマンスを向上させるため独自設計されています。インテル® ディストリビューションの OpenVINO™ ツールキット (英語) を使用して、一般的な ML モデル (音声認識タスクや画像認識タスクなど) をインテル NPU にオフロードします。次に、NPU 全般解析を使用して、AI および ML ワークロードのプロファイルを作成します。パフォーマンス・データを収集し、これらの AI/ML アプリケーションのパフォーマンスを最適化します。

注

これは、プレビュー機能です。プレビュー機能は、正式リリースに含まれるかどうかは未定です。皆さんが機能に対する有用性のフィードバックを送ることで、将来の採用決定の判断に役立ちます。プレビュー機能で収集されたデータは、将来のリリースで下位互換性が保証されません。

NPU データ収集モード

NPU 全般解析を実行すると、インテル® VTune™ プロファイラーは次の 2 つの方法のいずれかで NPU パフォーマンスに関するハードウェア・メトリックを収集できます。

- タイムベース・モード

- クエリーベース・モード

タイムベース・モード |

クエリーベース・モード |

|

|---|---|---|

動作の仕組み |

インテル® VTune™ プロファイラーは、CPU アンコアのメトリックと同様に、システム全体のメトリックを収集します。 |

インテル® VTune™ プロファイラーは、レベル 0 推論の各インスタンスのメトリックを収集します。メトリックはシステム全体で収集されますが、データ収集は推論と密接に関連しています。収集は各推論の直前に開始され、直後に停止します。 |

典型的なワーク負荷の大きさ |

ラージ |

スモール |

インスタンスの実行時間 |

>5 ms |

<5 ms |

サンプリング間隔 |

0.1 ミリ秒から 1000 ミリ秒の間の値を指定します |

N/A |

利点 |

大きなワークロードではこのモードを使用します。合理的な効率と削減されたオーバーヘッドでアプリケーションを最適化します。 |

小さなワークロードではこのモードを使用します。実行時間が長くなっても、アプリケーションをより効率良く最適化します。ワークロードが DDR メモリーに制限されているか効果的に調べます。 |

使用上の考慮事項 |

アプリケーションのオーバーヘッドを少なくします。このモードでは、通常の NPU ドライバーとともにレベル 0 バックエンドがインストールされている必要があります。ただし、このモードでは、計算タスクを除き、アプリケーションがレベル 0 を使用してメトリックを収集する必要はありません。 |

アプリケーションのオーバーヘッドを大きくします。このモードでは、アプリケーションはバックエンドにレベル 0 を使用する必要があります。 |

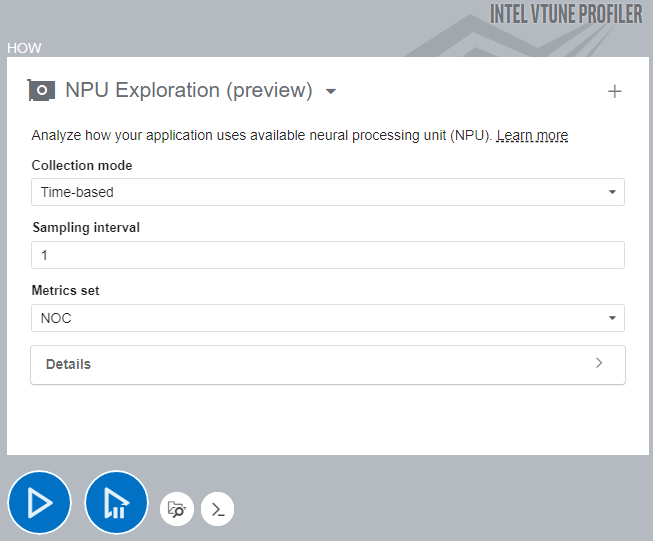

解析の設定と実行

インテル® VTune™ プロファイラーのユーザー・インターフェイス解析ツリーのアクセラレータグループで、NPU 全般 (プレビュー) を選択します。

[何を] ペインで、[アプリケーション] バーに AI/ML アプリケーションへのパスを指定します。

必要に応じて、関連するアプリケーション・パラメーターも指定します。

[どのように] ペインで [収集モード] を選択します。

サンプリング間隔を指定します。

[開始] ボタンをクリックして解析を実行します。

[開始] ボタンをクリックして解析を実行します。

NPU 全般解析を実行するには、次のコマンドラインを入力します。

$ vtune -collect npu [-knob <knob_name=knob_option>] -- <target> [target_options]

注

任意の解析設定のコマンドラインを生成するには、ユーザー・インターフェイスの下にある [コマンドライン] ボタンをクリックします。

インテル® VTune™ プロファイラーがデータ収集を完了すると、NPU 全般解析の結果が NPU 全般ビューポイントに表示されます。