この記事は、インテル® デベロッパー・ゾーンに公開されている「Intel® Software News Updates」の日本語参考訳です。原文は更新される可能性があります。原文と翻訳文の内容が異なる場合は原文を優先してください。

- 2025年

- 2024年

- 2023年

- 2022年

- 2021年

- 2020年

2025年

より高速な AI、リアルタイム・グラフィックス、よりスマートな HPC: インテル® ソフトウェア開発ツール 2025.1 リリース!

2025年03月26日 | インテル® ソフトウェア開発ツール | AI フレームワークとツール (英語)

インテルの最新世代の AI ツールとフレームワーク、およびインテル® oneAPI ツールキット 2025.1 がリリースされました。開発者が AI と HPC をより迅速かつ自信を持って作成できるように支援が強化されています。

ソフトウェア・プロジェクト全体でパフォーマンス、生産性、コード品質をターボチャージ

インテル® Xeon® 6 プロセッサー向けの最新の最適化 (英語)、インテル® oneAPI ディープ・ニューラル・ネットワーク・ライブラリー (インテル® oneDNN) を使用した AI 推論とトレーニングの高速化、インテル® Core™ Ultra プロセッサーでのディープラーニング推論パフォーマンスのプロファイルから、最新の貢献やインテル® プロセッサー上での PyTorch による FlexAttention サポートまで、最新リリースはすべてをカバーしています。

リアルタイム・グラフィックス、ビジュアル AI、レンダリング・パフォーマンスにおいて、Vulkan および Microsoft DirectX 12 との SYCL 相互運用性が強化されました。

サニタイザーと拡張されたコードカバレッジにより、CPU と GPU で実行される計算カーネルのコード品質を保証します。LLVM ベースのコンパイラー・テクノロジーにより、最新の C/C++、Fortran、SYCL、OpenMP をサポートしています。

新しいインテル® SHMEM ライブラリーにより、大規模なデータセット計算向けのマルチノード分散構成で GPU による通信の効率を向上できます。

oneAPI をベースとしたこれらの広範な分野に対応したツール、ライブラリー、および一般的なフレームワークを組み合わせることで、プログラミングとワークロードのニーズを満たすことができます。

詳細情報とダウンロード

AI ソリューション:

AI フレームワークとツール (英語) | AI ツールセレクター (英語)

汎用計算ソリューション:

インテル® oneAPI の概要 | インテル® ソフトウェア開発ツール

データセンターから PC まで AI パフォーマンスを最適化

最新のインテルの CPU および GPU プラットフォームで PyTorch 2.6 (英語) およびその他の主要なディープラーニング・フレームワークを使用して大幅なパフォーマンス向上を実現します。

インテル® Core™ Ultra AI PC およびインテル® Arc™ ディスクリート・グラフィックス上で PyTorch モデルをファイン・チューニング、推論、開発したい開発者や研究者は、Windows、Linux、Windows Subsystem for Linux 2 向けのバイナリーリリースを使用して PyTorch を直接インストールできるようになりました。

- TorchInductor CPP バックエンドを通じて X86 CPU の FlexAttention サポートが追加されました。これにより、CPU のパフォーマンスを最適化する既存の FlexAttention API に基づいて、現在の CPP テンプレートの機能が拡張され、幅広いアテンション・バリアント (LLM 推論に不可欠な PageAttention など) がサポートされます。

- x86 CPU での Float16 サポートは、PyTorch 2.5 でプロトタイプ機能として初めて導入されました。現在、Eager モードと Torch.compile および Inductor モードの両方でさらに改良され、り広く採用されるようにベータ版がリリースされています。

ディープラーニング推論向けのインテル® oneDNN (英語) の最適化により最新のインテル® プロセッサーを活用できます。

インテル® アドバンスト・マトリクス・エクステンション (インテル® AMX) 命令セットを搭載したインテル® Xeon® プロセッサー・アーキテクチャーのパワーを活用し、インテル® oneDNN により強化された行列乗算と畳み込みのパフォーマンスを体験できます。

インテル® Arc™ グラフィックス上の AI アプリケーションのパフォーマンスが向上し、インテル® Core™ Ultra プロセッサー (シリーズ 2) とインテル® Arc™ B シリーズ・ディスクリート・グラフィックスの機能が最大限に活用されます。

暗黙的なカジュアルマスクを使用して、ゲート付き多層パーセプトロン (ゲート付き MLP) と SDPA (Scaled Dot-Product Attention) の速度と効率の両方を向上させ、インテル® oneDNN Graph API を通じて int8 または int4 圧縮キーと値をサポートすることで、AI モデルをさらに最適化します。

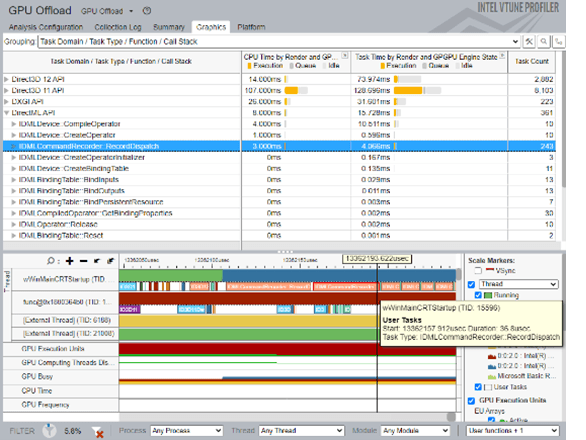

インテル® VTune™ プロファイラーを使用して、AI PC のパフォーマンス・ボトルネックを解消し、分散型ディープラーニング・ワークロードを効率化します。

DirectML または WinML API を呼び出す AI ワークロードのパフォーマンス・ボトルネックを特定します。

分散型ディープラーニングと Python ワークロードの解析を改良し、Python 3.12 で最も時間のかかるコード領域とクリティカルなコードパスを特定します。

C++ with SYCL を使用して、ゲーム、グラフィックス、デジタルコンテンツ向けのリアルタイム・ビジュアル AI エクスペリエンスを提供

インテル® oneAPI DPC++/C++ コンパイラーとインテル® DPC++ 互換性ツールは、Vulkan および DirectX12 との SYCL 相互運用性を強化します。

これにより、GPU からイメージ・テクスチャー・マップ・データを直接共有できるようになり、CPU と GPU 間の余分なイメージコピーが排除され、イメージ処理と高度なレンダリング・アプリケーションでシームレスなパフォーマンスが確保され、コンテンツ作成の生産性が向上します。

HPC とアクセラレーテッド・コンピューティングのパフォーマンス、生産性、コード品質を向上

インテル® コンパイラーは、コードの安定性、セキュリティー、生産性を向上します。

インテル® oneAPI DPC++/C++ コンパイラーとインテル® Fortran コンパイラーは、CPU MemorySanitizer のサポートを GPU を含むデバイス側に拡張します。これにより、開発者は CPU とデバイスコードの両方で問題を簡単に検出してトラブルシューティングできるため、より信頼性が高く堅牢なアプリケーションを実現できます。

- インテル® oneAPI DPC++/C++ コンパイラーは、ビルド時間を大幅に短縮するキャッシュ* をサポートしました。以前のコンパイルをキャッシュして再利用することで、反復処理が高速化し、ワークフローが効率化されます。ビルドに時間をかけずに、高品質のコードの作成に集中できます。

- インテル® oneAPI DPC++/C++ コンパイラーのコード・カバレッジ・ツールには、C/C++、SYCL、OpenMP を使用するアプリケーション向けの GPU サポートと拡張 CPU カバレッジが追加されました。

- インテル® Fortran コンパイラーは、スレッド間で作業を効率的に分散する WORKDISTRIBUTE 構造と、ループネスト内のループを並べ替える INTERCHANGE 構造を導入することで、OpenMP 6.0 標準のサポートを拡張し、並列パフォーマンスとコード最適化を向上させます。

Fortran 23 のサポートがさらに強化され、標準準拠によってコードの柔軟性が向上し、SYSTEM_CLOCK 組込み関数の整数引数の種類の一貫性が確保され、PUBLIC NAMELIST グループに PRIVATE 変数を含めることができるようになりました。

MPI と新しいインテル® SHMEM ライブラリー (英語) により GPU 開始通信の効率が向上します。

ポイントツーポイントのリモート・メモリー・アクセス (RMA) と OpenSHMEM 1.6 ストライド RMA 操作、アトミックメモリー操作 (AMO)、シグナリング、メモリー順序付け、チーム、コレクティブ、同期などの OpenSHMEM 1.5 準拠機能を使用して、マルチノード・アクセラレーター・デバイスとホストをターゲットにできます。

対称ヒープ API を使用したインテル® SHMEM SYCL キュー順序付け RMA、SYCL ホスト USM アクセスにより、分散マルチノード SYCL デバイスアクセスを簡素化します。

インテル® MPI ライブラリーは、新しい MPI 標準に先駆けて、サポートされている GPU でデバイス開始 MPI-RMA 機能もサポートしました。

AI フレームワークとツール (英語) | インテル® ソフトウェア開発ツール

2024年

AI ツールと最適化フレームワークの最新バージョン 2025.0 リリース

2024年12月19日 | AI フレームワークとツール (英語)

生成 AI の生産性、アクセラレーション、スケーリングを次のレベルへ

インテルは、生成 AI の量子化と推論にフォーカスして AI の効率とスケーリングを推進する、AI ツールと最適化フレームワークのバージョン 2025.0 をリリースしました。PyTorch および TensorFlow エコシステムへの多くの貢献を含むオープン・スタンダードのサポート、最新の P-cores 搭載インテル® Xeon® 6 プロセッサー、インテル® Arc™ B シリーズ・グラフィックス、インテルの GPU と内蔵アクセラレーター向けの最適化が追加されています。

詳細とダウンロード (英語)

オープンソースの AI フレームワークとディープラーニング・モデルを採用したインテルの最新世代の AI ツールにより、開発者は既存のコードベースを、下位互換性を失うことなく最新のインテルのテクノロジーをサポートするように容易に拡張できます。

oneAPI を利用した豊富なライブラリーとユーティリティーのセットは、高性能な AI ワークロードを迅速に作成または移行する、信頼性が高く、柔軟性があり、拡張可能で、高度に最適化された基盤を形成します。

オープン AI フレームワークを採用

- インテル® Xeon® 6 プロセッサー、インテル® Core™ Ultra プロセッサー、インテル® データセンター GPU マックス・シリーズ、およびクライアント GPU のネイティブサポートを含むインテルの PyTorch 最適化 (英語) は、PyTorch 2.5 にアップストリームされています。現世代のプロセッサー向けに最適化され、パフォーマンス向上のため (英語) インテル® oneAPI DPC++/C++ コンパイラーで TorchInductors をコンパイルする機能を備えた PyTorch 2.5 と torch.compile サポートによる PyTorch 推論の最新の CPU パフォーマンス (英語) を利用できます。PyTorch 向けインテル® エクステンションには、大規模言語モデル (LLM) を最適化するカスタマイズされたカーネルサポートが追加され、DeepSpeed 向けインテル® エクステンション (英語) が統合されました。

- インテルの TensorFlow 最適化 (英語) は、インテル® oneAPI ディープ・ニューラル・ネットワーク・ライブラリー (インテル® oneDNN) (英語) を使用して公式の TensorFlow 機能を拡張し、パフォーマンスとスケーラビリティーを向上します。最新のインテルの CPU および GPU 上で TensorFlow ワークロードのパフォーマンスを最適化して、効率良く実行できます。

- JAX Python ライブラリー (英語) が AI ツールに統合され、自動微分による効率的で柔軟な数値計算が可能になりました。これにより、JAX の高性能なジャストインタイム・コンパイルを活用し、マシンラーニング、科学計算、最適化タスク向けの機能が強化されます。PJRT (英語) プラグインメカニズムをベースにインテルにより最適化された PyPI パッケージである OpenXLA (英語) 向けインテル® エクステンションを使用して、インテル® データセンター GPU 上で JAX (英語) モデルをシームレスに実行します。

モデルサイズとパフォーマンスの最適化

- インテル® ニューラル・コンプレッサー (英語) は、モデルを最適化してモデルサイズを小さくし、CPU と GPU 上でディープラーニング (DL) の推論を高速化します。

- 新機能には、LLM の重みのみの量子化を行う Transformer ライクな量子化 API があり、インテルのハードウェアで量子化と推論のワンストップ・エクスペリエンスを提供します。また、AutoRound アルゴリズムを使用した LLaVA、Phi-3-vision、Qwen-VL などのビジュアル言語モデル (VLM) の INT4 量子化もあります。

- インテル® ニューラル・コンプレッサーのその他の改善点には、Transformer ライクな API での PyTorch 推論用の AWQ 形式 INT4 モデルの読み込みと変換のサポート、INT4 モデルの AutoRound 形式のエクスポートの有効化、PyTorch 2 エクスポート (PT2E) のチャネルごとの INT8 トレーニング後量子化のサポートなどがあります。

生成 AI 開発者の生産性を高める

- AI ツールコンテナ (英語) は、サポートする主要 Python フレームワークやライブラリーに基づいて再定義されました。これにより、コンテナサイズが縮小され、使い方が簡素化され、開発者にとってもユーザーにとっても、より合理的で効率的な環境が保証されます。

- インテル® oneAPI ディープ・ニューラル・ネットワーク・ライブラリー (インテル® oneDNN) (英語) は、サーバー、デスクトップ、モバイルにまたがる最新のインテル® プラットフォーム向けに最適化され、大規模言語モデル (LLM) や SPDA (Scaled Dot-Product Attention) サブグラフのパフォーマンスが大幅に向上するなど、効率とパフォーマンスを最大化します。

- インテル® oneAPI データ分析ライブラリー (インテル® oneDAL) は、ランダムフォレスト (RF) アルゴリズムの説明可能性に必要なバイナリー分類モデルの SHAP (SHapley Additive exPlanations) 値の計算を可能にします。

- インテル® oneAPI コレクティブ・コミュニケーション・ライブラリー (インテル® oneCCL) (英語) は、ワークロードのスケーリングとパフォーマンスをさらに向上します。AllGather、AllReduce、Reduce-Scatter などの主要な集合操作の重要な機能強化が追加されています。インテル® oneCCL の Key-Value ストアの強化により、ランク間の通信が改善され、ワークロードをさらに多数のノードに拡張できるようになりました。

- scikit-learn 向けインテル® エクステンション (英語) は、共分散および統計アルゴリズムの新しいインターフェイスを追加し、LogisticRegression アルゴリズムのスパースデータをサポートします。

AI フレームワークとツール (英語)

AI ツールセレクター (英語)

oneAPI 誕生から 5 周年を記念するインテル® ソフトウェア開発ツールのバージョン 2025.0 がリリース

2024年11月17日 | インテル® ソフトウェア開発ツール

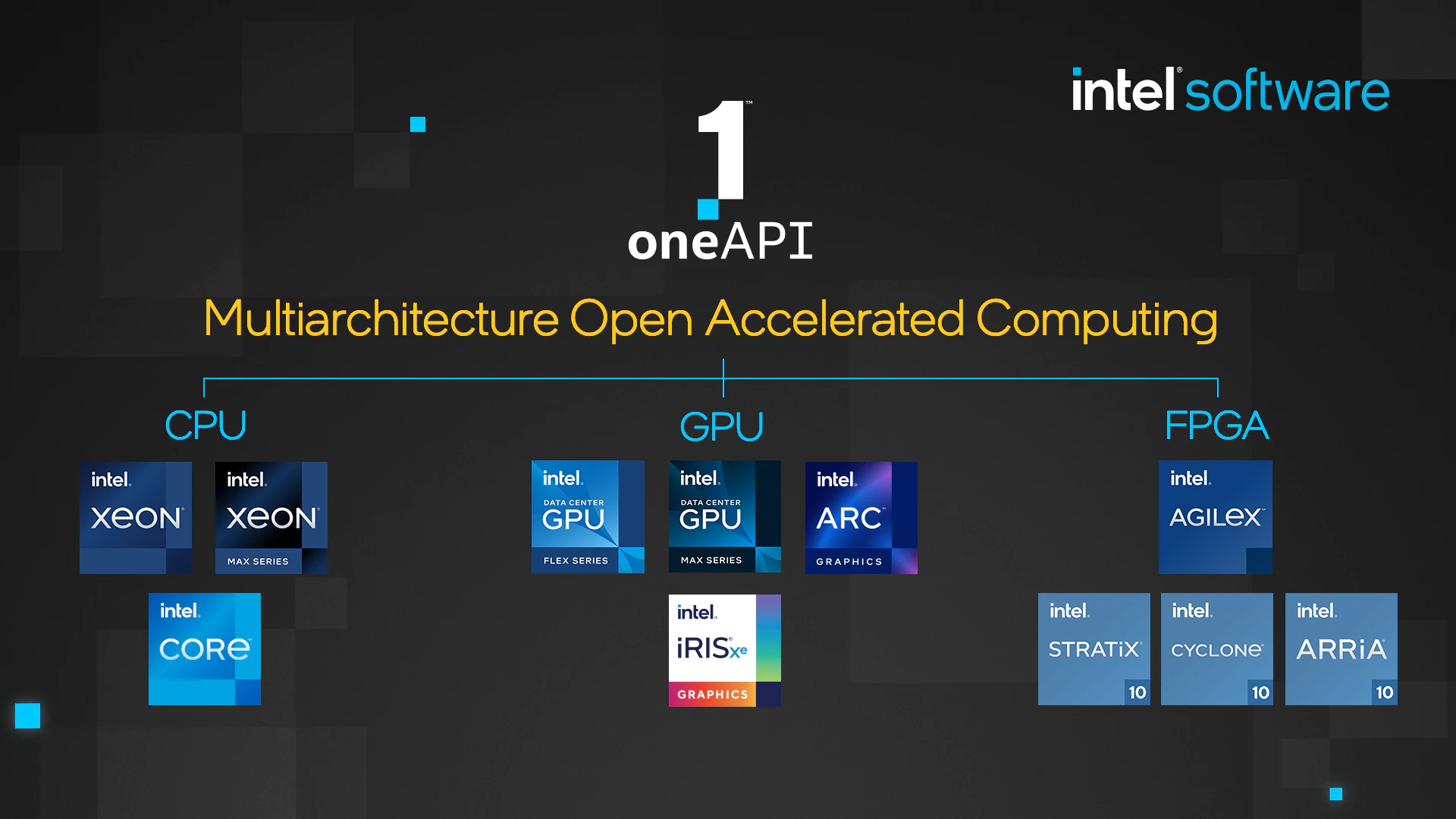

インテルは、oneAPI プログラミング・モデルの誕生から 5 周年を記念して、パフォーマンスの最適化とオープン・スタンダードのカバレッジが拡張された、マルチアーキテクチャー、ハードウェアに依存しないソフトウェア開発とデプロイ、エッジからクラウドまでの最新のイノベーションをサポートする、oneAPI を利用した開発者ツールの最新バージョン 2025.0 をリリースしました。

3 つの特長

- インテル® プラットフォームでさらなるパフォーマンスを引き出す – インテル® oneDNN (英語)、インテルにより最適化された AI フレームワーク、インテル® AMX1 を搭載したインテル® Xeon® 6 プロセッサー (P-cores) で最大 3 倍の生成 AI パフォーマンスを実現します。MRDIMM2 とインテル® oneMKL により HPCG パフォーマンスを最大 2.5 倍向上します。インテル® Core™ Ultra プロセッサー (シリーズ 2) の性能を最大限に発揮するように最適化されたツールにを利用して、PC 上で LLM 開発を含む ハイパフォーマンス AI を開発できます。インテル® クリプトグラフィー・プリミティブ・ライブラリー (英語) によりセキュリティーと暗号化を向上できます。

- 業界標準ツールへのアクセスの拡大 – CPU および GPU での PyTorch* 2.5 のネイティブサポートなど、業界をリードする AI フレームワークと、多くのインテルの最適化を含むパフォーマンス・ライブラリーを使用して、既存の開発ワークフローを活用できます。インテルの AI ツール (英語) を使用すると、CPU、GPU、AI アクセラレーター上で Llama* 3.2、Qwen2、Phi-3 などの最新の LLM から最適なパフォーマンスを引き出すことができます。また、ツールキット・セレクター (英語) を使用してフルキットまたは適切なサイズのサブバンドルをインストールすることで、ソフトウェアのセットアップを効率化できます。

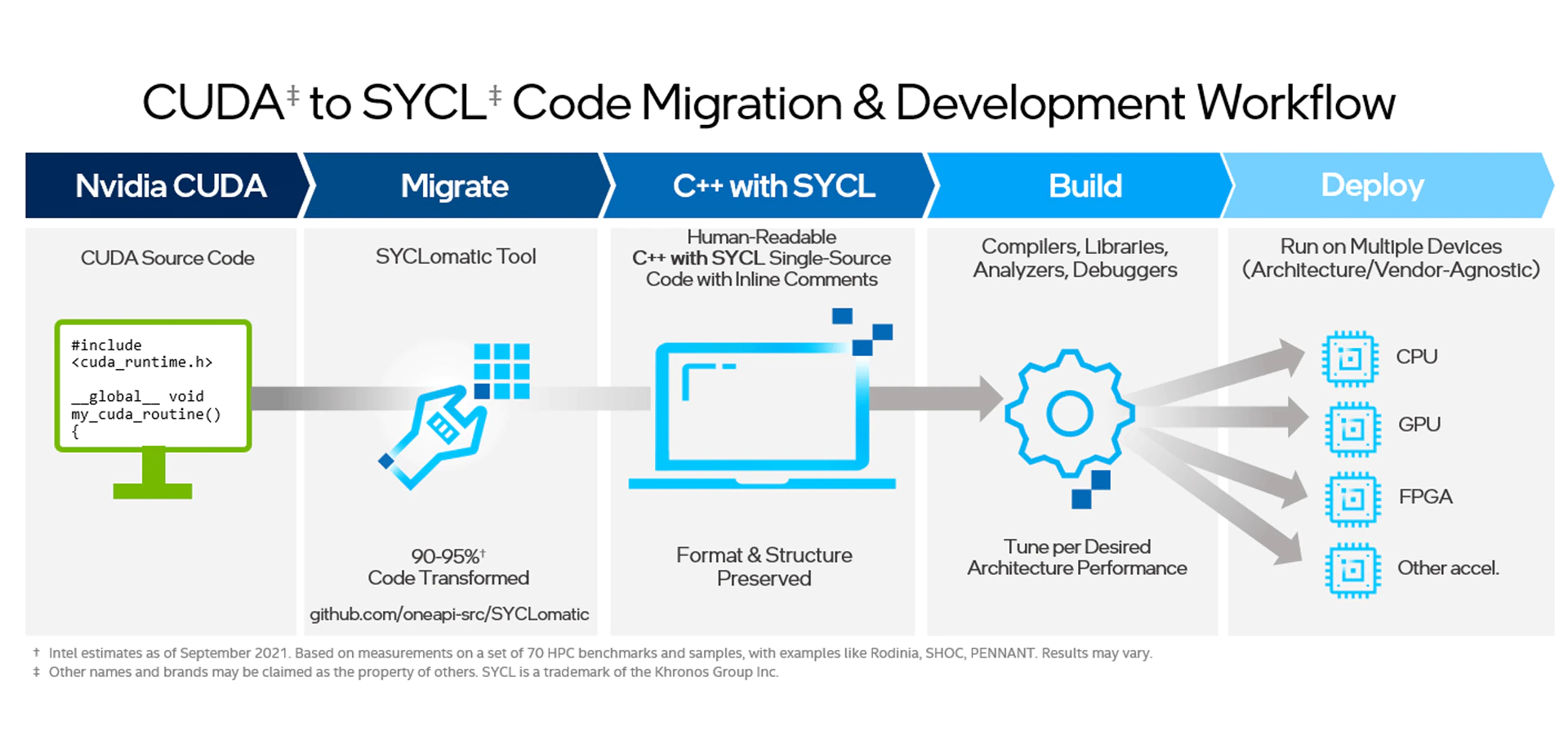

- ハードウェアの選択肢が拡大 – 一般的な AI、HPC、レンダリング・アプリケーションで使用される 100 以上の API を自動移行するインテル® DPC++ 互換性ツールにより、CUDA* から SYCL* への迅速な移行など、マルチベンダー、マルチアーキテクチャーのサポートが強化されています。インテル® ディストリビューションの Python* により、CPU および GPU でドロップインの、ネイティブに近い数値計算パフォーマンスを実現できます。インテル® oneDPL によりアルゴリズムの GPU カーネルを 4 倍高速化できます。Triton、JAX、OpenXLA などのクロスハードウェア AI アクセラレーション・ライブラリーにより、将来のシステムの柔軟性を獲得し、ロックインを防止します。

新機能

以下は、コンポーネント・レベルの詳細です。

コンパイラー

- インテル oneAPI DPC++/C++ コンパイラーは、インテル® Xeon® 6 プロセッサーおよびインテル® Core™ Ultra プロセッサー向けにカスタマイズされた最適化が追加され、新しい SYCL* バインドレス・テクスチャー・サポートによりインテル® GPU の動的実行と柔軟なプログラミングを可能にし、デバイスコードの問題を検出してトラブルシューティングする新しい LLVM サニタイザーで開発を効率化し、 OpenMP* 標準 5.x および 6.0 への準拠を拡張し、OpenMP* オフロードの詳細を含むよりユーザーフレンドリーな最適化レポートが追加されています。

- インテル® Fortran コンパイラーは、クリーンな出力のための AT 編集記述子、OpenMP* 6.0 の新しい IF 節による条件付き TEAMS 構造の実行、およびアプリケーションの標準への準拠を正確に制御する Co-Array の配列と「standard-semantics」オプションのサポートなど、Fortran 2023 標準機能を含むいくつかの機能強化が追加されています。『Fortran デベロッパー・ガイドおよびリファレンス』のサンプルコードが更新され、Fortran 2018 および 2023 の Fortran 言語機能のサポートが追加されています。

パフォーマンス・ライブラリー

- インテル® oneAPI マス・カーネル・ライブラリー (インテル® oneMKL)は、P-cores 搭載インテル® Xeon® 6 プロセッサーをターゲットとする開発者向けに、BLAS、LAPACK、FFT などの複数のドメインにわたるパフォーマンス最適化が導入されています。また、インテル® データセンター GPU マックス・シリーズで単精度 3D 実数インプレース FFT を使用した HPC ワークロードの実行が大幅に改善され、SYCL* デバイス API を使用した RNG の新しい分布モデルとデータ型が利用できるようになりました。

- インテル® oneAPI データ・アナリティクス・ライブラリー (インテル® oneDAL) は、説明可能性ランダム フォレスト (RF) アルゴリズムに必要なバイナリー分類モデルの SHAP (SHapley Additive exPlanations) 値を計算できるようになりました。

- インテル® oneAPI ディープ・ニューラル・ネットワーク・ライブラリー (インテル® oneDNN) (英語) は、サーバー、デスクトップ、モバイルにわたる最新のインテル® プラットフォーム向けの最適化により、効率とパフォーマンスを最大化します。これには、大規模言語モデル (LLM) とスケーリングされたドット積アテンション・サブグラフの大幅な高速化が含まれます。

- インテル® oneAPI スレッディング・ビルディング・ブロック (インテル® oneTBB) は、task_group、flow_graph、parallel_for_each のスケーラビリティーを向上させ、マルチスレッド・アプリケーションの実行速度を向上させます。また、インテル® oneTBB のフローグラフを使用して共有グラフの重複メッセージを処理し、結果を迅速に取得できるようにする新しい try_put_and_wait 実験的 API が導入されました。

- インテル® oneAPI コレクティブ・コミュニケーション・ライブラリー (インテル® oneCCL) (英語) は、ワークロードをさらに多数のノードにスケールアップできるようするキー値格納の強化と、Allgather、Allreduce、Reduce-scatter などの主要な集合操作のパフォーマンス向上により、ワークロードのパフォーマンスとスケーラビリティーを向上させます。

- インテル® MPI ライブラリーは、分割通信、改善されたエラー処理、Fortran 2008 サポートを含む完全な MPI 4.0 実装を提供します。P-core ピニングによりインテル® Xeon® 6 プロセッサーと MPI_Allreduce の最適化によりインテル® GPU の両方でスケールアウト/スケールアップのパフォーマンスが向上します。

- インテル® oneAPI DPC++ ライブラリー (インテル® oneDPL) (英語) は、reduce、scan、その他の多くの関数を含むアルゴリズムで GPU カーネルを最大 4 倍3 高速化します。20 以上の新しい C++20 標準の範囲とビューを使用した範囲ベースのアルゴリズムにより、マルチアーキテクチャー・デバイスで高度に並列化されたコード実行を高速化します。

- インテル® インテグレーテッド・パフォーマンス・プリミティブ (インテル® IPP) は、最先端のハードウェア強制セキュリティー対策である CET 対応の保護 (Control-flow Enforcement Technology) により、ソフトウェアを攻撃や悪用リスクから保護します。

- インテル® クリプトグラフィー・プリミティブ・ライブラリー (英語) (旧称インテル® IPP クリプトグラフィー) は、開発者がインテル® Xeon® 6 プロセッサー上にディスパッチできるようにし、マルチバッファー機能で RSA 暗号化 (2K、3K、4K) を高速化し、強化された SM3 アルゴリズムでハッシュ化します。

アナライザーとデバッガ―

- インテル® DPC++ 互換性ツールは、一般的な AI、HPC、レンダリング・アプリケーションで使用されるより多くの API を自動移行することで、CUDA* コードと CMake ビルドスクリプトを SYCL* に移行する際の時間と労力を軽減します。移行したコードは、SYCLcompat で簡単に理解でき、CodePin を使用して簡単にデバッグでき、NVIDIA* GPU で実行できます。

- インテル® VTune™ プロファイラーは、P-cores 搭載インテル® Xeon® 6 プロセッサーとインテル® Core™ Ultra プロセッサー (シリーズ 2) をサポートしました。また、Python* 3.11 のプロファイル・サポートが追加され、Python* のプロファイルを関心領域に集中させ、インテル® ITT API (英語) を使用したパフォーマンス・データ収集の制御により、生産性を向上させます。

- インテル® Advisor は、開発者が最新のインテルのプラットフォームでボトルネックを特定し、コードを最適化し、最高のパフォーマンスを実現できるようにします。柔軟なカーネルマッチングと XCG アプリの統合により、適応性の高いカーネル・マッチング・メカニズムが導入されており、特定の最適化目標に関連するコード領域を特定して分析することが可能です。

- インテル® ディストリビューションの GDB* (英語) は、最新の状態を維持し、効果的なアプリケーションのデバッグをサポートする最新の機能拡張に合わせて、GDB 15 をベースとするように変更されました。また、Windows* でインテル® Core™ Ultra プロセッサー (シリーズ 2) をサポートしました。デバッガー・パフォーマンスの向上とユーザー・インターフェイスの改良により、コマンドラインと Microsoft* Visual Studio* および Visual Studio* Code 使用時の両方で開発者のエクスペリエンスを向上します。

AI および ML ツール、フレームワーク、および高速化された Python*

- インテル® ディストリビューションの Python* は、CPU と GPU でドロップインの、ネイティブに近い数値計算パフォーマンスを実現します。Python 向けデータ・パラレル・エクステンション (dpnp) とデータ・パラレル・コントロール (dpctl) は、互換性を拡張し、ランタイムに NumPy* 2.0 をサポートして、オフロードされた操作の非同期実行を提供します。

- インテルの AI ツール (英語) の最新リリースでは、Llama* 3.2、Qwen2、Phi-3 ファミリーを含む生成 AI 基礎モデルの現在および将来のリリースが、インテルの CPU、GPU、AI アクセラレーターで最適に動作するようにします。

- Triton (英語) (ニューラル・ネットワーク向けのオープンソースの GPU プログラミング) がインテル® データセンター GPU マックス・シリーズとインテル® Core™ Ultra プロセッサー (シリーズ 2) 向けに完全に最適化され、ストック PyTorch* のアップストリームで利用できるようになりました。開発者はインテルの GPU でピーク・パフォーマンスとカーネル効率を実現できます。

- PyTorch* 2.5 のネイティブサポート (英語) は、インテルのデータセンター GPU、インテル® Core™ Ultra プロセッサー、インテルのクライアント GPU で利用できます。インテル® Arc™ グラフィックスとインテル® Iris® Xe グラフィックス GPU のサポートにより、Windows* で PyTorch* を使用した開発が可能です。

- LF AI & Data Foundation のオープン・プラットフォーム・プロジェクトである OPEA (英語) を採用することにより、エンタープライズ生成 AI の導入を簡素化し、強化された、信頼できるソリューションの運用までの時間を短縮します。現在リリース 1.0 の OPEA は、AMD、BONC、ByteDance、MongoDB、Rivos などの最新のパートナーを含む 40 社を超えるパートナーとともに躍進を遂げています。

- PJRT (英語) プラグイン・メカニズム・ベースのインテルにより最適化された PyPI パッケージである OpenXLA* (英語) 向けインテル® エクステンションにより、インテル® データセンター GPU マックス・シリーズとインテル® データセンター GPU フレックス・シリーズで JAX (英語) モデルをシームレスに実行します。

脚注

1 intel.com/processorclaims の [9A2] を参照: インテル® Xeon® 6 プロセッサー。結果は異なることがあります。

2 intel.com/processorclaims の [9H10] を参照: インテル® Xeon® 6 プロセッサー。結果は異なることがあります。

3 インテル® oneDPL 製品ページ (英語) を参照。

oneAPI 誕生から 5 年

2024年11月17日 | oneAPI とは? (英語)、インテル® oneAPI デベロッパー・ページ (英語)

アクセラレーター・アーキテクチャー向けのオープンで標準ベースのマルチアーキテクチャー・プログラミング・イニシアチブの誕生から 5 周年

Supercomputing 2019 で発表された oneAPI イニシアチブは、グローバルな開発者エコシステムのヘテロジニアス・プログラミングへの取り組み方に恒久的な変化をもたらしただけでなく、あらゆるベンダー・アーキテクチャー上で実行可能な高性能ソフトウェアを構築、最適化、デプロイする基盤となっています。

多数の貢献者、430 万以上のインストール、680 万人の開発者がインテルのソフトウェアと AI ツール (最新バージョン 2025.0 の詳細はこちら) を介して oneAPI を使用しており、oneAPI は間違いなく主要なプログラミング標準の 1 つです。Unified Acceleration (UXL) Foundation の使命は、ハイパフォーマンスのクロスプラットフォーム・アプリケーションの開発を簡素化するオープンスタンダードのアクセラレーター・プログラミング・モデルを提供することです。これは、oneAPI を主要コンポーネントとして、イノベーションを推進するための重要な一歩です。

これらすべてをわずか 5 年で実現しました。次の 5 年間で何が起こるか想像してみてください。

oneAPI をまだ試していない場合は、概要を確認し、最新バージョン 2025.0 のツールをダウンロードしてお試しください。

oneAPI 5 周年を祝う – エコシステムの利用者の声

oneAPI 5 周年は、異なるハードウェア上でアプリケーションの実行を可能にするエコシステムの技術的な深さと、HPC、AI、API 標準、ポータブルなアプリケーションを中心としたコミュニティー形成の成功の両方を認識する良い機会です。

oneAPIは、アーキテクチャーを超えたシームレスな開発を可能にすることで、ヘテロジニアス・コンピューティングへのアプローチ方法に革命をもたらしました。そのオープンで統一されたプログラミング・モデルは、AI から HPC までの分野におけるイノベーションを加速し、研究者と開発者の新たな可能性を解き放ちました。oneAPI 5 周年おめでとうございます。

インテルの oneAPI ソフトウェア・スタックへのコミットメントは、開発者重視のオープン・スタンダードへのコミットメントの証です。oneAPI は 5 周年を迎え、CPU と GPU 向けに OpenMP* と SYCL* の包括的で高性能な実装を提供し、インテル® プロセッサーを最大限に活用するライブラリーとツールのエコシステムによって強化されています。

oneAPI が 5 周年を迎えたことをお祝いいたします。ExaHyPE において、oneAPI は双曲方程式系の数値計算カーネルの実装に大きく貢献し、SYCL* がこれらのバリエーションを探索する理想的な抽象化と不可知論を提供することで、性能に大きな違いをもたらしました。この多用途性により、私たちのチームは、インテルのエンジニアとともに、カーネルの 3 つの異なる設計パラダイムを発表することができました。

oneAPI、5 周年おめでとうございます! 私たちは、2019年のプライベート・ベータ・プログラム以来のパートナーです。現在、材料科学のシミュレーションやバイオインフォマティクスのデータ・アナリティクス向けの電力効率の高いソリューションを、さまざまなアクセラレーターを使って模索しています。そのためには、oneAPI のコンポーネント、さまざまな GPU や FPGA 用のバックエンドを備えたコンパイラー、oneMKL、インテル® VTune™ プロファイラーやインテル® Advisor などのパフォーマンス・ツールが不可欠です。

GROMACS は、性能と移植性に優れたバックエンドとして SYCL* を早くから採用し、マルチベンダーの GPU 上で実行するために活用してきました。長年にわたり、SYCL* 標準の大幅な改善とそのコミュニティーの成長を見てきました。これは、イノベーションとコラボレーションを推進するため、計算研究におけるオープン・スタンダードの重要性を強調しています。ソフトウェア・パフォーマンスの向上とプログラマーの生産性向上を可能にする、SYCL* の継続的な開発に期待しています。

私たちは、インテル® oneAPIベースツールキットを使用して、超音波診断ソリューションで広く使用されている、重い処理を必要とするコードを SYCL* に移行することに成功しました。これは、ヘテロジニアス・コンピューティングのための、単一でオープンな標準ベースのプログラミング・モデルへの大きな前進です。移行されたコードは、異なる GPU プラットフォーム上で効率良く実行され、競争力のある性能を達成しています。

インテル® oneAPIベースツールキットを使用して、GE HealthCare の CT ポートフォリオの多くで利用可能な、独自のディープラーニング画像再構成アルゴリズムである TrueFidelity DL を実装することに成功しました。オープンソースの SYCL* コンパイラーは、複数の NVIDIA* GPU デバイスでほぼ同等の AI/DL 推論パフォーマンスを提供します。GE Healthcare の OpenCL* ソフトウェアの経験に基づくと、コードの移植性は、ソフトウェア開発への投資を保護し、異なるプラットフォームやベンダー間でソフトウェアを再利用するために極めて重要です。

関連情報:

- AI & マシンラーニング・エコシステム開発者リソース (英語)

- HPC エコシステム開発者リソース (英語)

インテル® Tiber™ AI クラウドでオブジェクト・ストレージの一般提供を開始

2024年10月17日 | インテル® Tiber™ AI クラウド

インテルは、インテル® Tiber™ AI クラウドで新しいオブジェクト・ストレージ・サービスの提供開始を発表しました。このサービスは、最新のデータおよび AI ワークロードの厳しい要件を満たす、スケーラブルで耐久性があり、コスト効率に優れたデータストレージを提供します。

このサービスは、S3 API (AWS* の Simple Storage Service) と互換性のある強力なオープンソース MinIO プラットフォーム上に構築されており、既存のアプリケーションやツールとの統合が容易です。

詳細 (英語)

次のような利点があります。

- 拡張性と柔軟性 – ギガバイトでもペタバイトでも、膨大なデータストレージのニーズに対応できるため、ビジネスに合わせてストレージ・インフラストラクチャーを拡張できます。

- パフォーマンス – 高速データアクセスと取得に最適化されているため、AI/ML ワークロードを含め、データに常にアクセスでき、迅速に処理できます。

- コスト効率の良いストレージ – あらゆる規模の企業が、多額の費用をかけずに膨大な量のデータを保存できます。

- 堅牢なセキュリティー – 保存時と転送時の暗号化と、堅牢なアクセス制御が含まれています。

- 統合が容易 – バックアップとリカバリー、データアーカイブ、データレイクの使用など、既存のワークフローやアプリケーションとシームレスに統合できるように構築されています。

- 強化されたデータ管理 – バージョン管理、ライフサイクル・ポリシー、メタデータ管理などの機能を使用して、データを効率良く管理できます。

Inflection AI がインテル® Tiber™ AI クラウド上のインテル® Gaudi® 3 AI プロセッサーで動作するエンタープライズ AI を発表

2024年10月7日 | Inflection AI とインテルの協業 (英語)、インテル® Tiber™ AI クラウド

新たな協業により、企業に大きな成果をもたらす AI 搭載のターンキー・プラットフォームを提供

Inflection AI とインテルは、大企業向けに AI の導入と効果を加速させる協業を発表しました。業界初のエンタープライズ・グレードの AI プラットフォームである Inflection 3.0 は、インテル® Tiber™ AI クラウド上のインテル® Gaudi® 3 AI アクセラレーターで動作し、複雑で大規模な導入に必要な制御、カスタマイズ、拡張性を備えた、共感的で会話的な、従業員に優しい AI 機能を提供します。

「Inflection AI とインテルは協力して、エンタープライズのお客様に AI に対する究極の制御を提供します。Inflection AI をインテル® Tiber™ AI クラウドとインテル® Gaudi® 3 AI アクセラレーターと統合することで、ソフトウェア、価格、性能、スケーラビリティーのオープンなエコシステムを提供します。これにより、企業における AI 導入の重要な障壁を解消し、お客様が必要とする安全で、目的に特化した、従業員固有の、企業文化に応じた AI ツールを実現します。」

これが重要な理由

AI プラットフォームの構築は複雑であり、広範なインフラストラクチャーに加えて、モデルの開発、トレーニング、ファインチューニング、さらには多数のエンジニア、データ・サイエンティスト、アプリケーション開発者を必要とします。

Inflection 3.0 は、企業データ、ポリシー、文化に基づいてトレーニングされた仮想 AI により従業員を強化する完全な AI プラットフォームを、企業のお客様に提供します。インテル® Tiber™ AI クラウド上のインテル® Gaudi® 3 AI アクセラレーターで動作し、優れたパフォーマンス、堅牢なソフトウェア、効率性を提供することで、業界をリードするパフォーマンス、スピード、スケーラビリティーを費用対効果の高い方法で実現し、大きな成果をもたらします。

インテルが次世代の AI ソリューションを実現するインテル® Xeon® 6 プロセッサーとインテル® Gaudi® 3 AI アクセラレーターを発表

2024年9月24日 | インテル® Xeon® 6 プロセッサー (P-core採用)、インテル® Gaudi® 3 AI アクセラレーター

インテルは本日、Performance-cores (P-cores) を搭載したインテル® Xeon® 6 プロセッサーとインテル® Gaudi® 3 AI アクセラレーターを発表しました。これらの製品により、最適な電力効率 (パフォーマンス/ワット) とより低い総保有コスト (TCO) を特徴とする、強力な AI システムの提供を実現します。

インテルの AI に特化したデータセンター向け製品ポートフォリオに次の 2 つの新製品が加わりました。

インテル® Xeon® 6 プロセッサー (P-core採用): 計算負荷の高いワークロードを効率良く処理するように設計されたインテル® Xeon® 6 プロセッサーは、前世代製品と比較して 2 倍のパフォーマンスを実現します1。コア数の増加、メモリー帯域幅の倍増、すべてのコアに組み込まれた AI アクセラレーション機能を提供します。

インテル® Xeon® 6 プロセッサー (P-core採用): 計算負荷の高いワークロードを効率良く処理するように設計されたインテル® Xeon® 6 プロセッサーは、前世代製品と比較して 2 倍のパフォーマンスを実現します1。コア数の増加、メモリー帯域幅の倍増、すべてのコアに組み込まれた AI アクセラレーション機能を提供します。 インテル® Gaudi® 3 AI アクセラレーター: 大規模生成 AI 向けに最適化されており、64 個の Tensor プロセッサー・コア (TPC) と 8 個の行列乗算エンジン (MME) を実装し、ディープ・ニューラル・ネットワーク (DNN) の計算処理を加速します。トレーニングと推論用に 128GB の HBM2e メモリーを備え、スケーラブルなネットワーク処理を可能にする 24 ポートの 200Gb イーサネットを搭載しており、Llama 2 70B 推論で NVIDIA* H100 と比較して最大 20% 高いスループットと、2 倍の価格性能比を実現します2。

インテル® Gaudi® 3 AI アクセラレーター: 大規模生成 AI 向けに最適化されており、64 個の Tensor プロセッサー・コア (TPC) と 8 個の行列乗算エンジン (MME) を実装し、ディープ・ニューラル・ネットワーク (DNN) の計算処理を加速します。トレーニングと推論用に 128GB の HBM2e メモリーを備え、スケーラブルなネットワーク処理を可能にする 24 ポートの 200Gb イーサネットを搭載しており、Llama 2 70B 推論で NVIDIA* H100 と比較して最大 20% 高いスループットと、2 倍の価格性能比を実現します2。

1 intel.com/processorclaims (英語) のインテル® Xeon® 6 プロセッサーを参照してください。結果はシステム構成によって異なります。

2 intel.com/processorclaims (英語) のインテル® Gaudi® 3 AI アクセラレーターを参照してください。結果はシステム構成によって異なります。

Seekr がインテル® Tiber™ デベロッパー・クラウド上のセルフサービス AI エンタープライズ・プラットフォームを発表

2024年9月4日 | SeekrFlow (英語)、インテル® Tiber™ デベロッパー・クラウド

インテル® Tiber™ デベロッパー・クラウド上で動作する Seekr で、優れたコスト・パフォーマンスの信頼できる AI を導入

Seekr は本日、インテル® Tiber™ デベロッパー・クラウド上の高性能でコスト効率の高いインテル® Gaudi® AI アクセラレーター上で動作する、エンタープライズ対応プラットフォームの SeekrFlow を発表しました。

Seekr は本日、インテル® Tiber™ デベロッパー・クラウド上の高性能でコスト効率の高いインテル® Gaudi® AI アクセラレーター上で動作する、エンタープライズ対応プラットフォームの SeekrFlow を発表しました。

SeekrFlow は、信頼できるエンタープライズ AI アプリケーションのトレーニング、検証、デプロイ、スケーリングを行う完全なエンドツーエンド・プラットフォームであり、AI 導入のコストと複雑さ、そしてハルシネーションを軽減します。

詳細 (英語)

これが重要な理由

一言で言えば、顧客の利点です。

インテルのクラウドを使用して大規模な AI の開発とデプロイを行うと同時に、SeekrFlow のパワーを活用して信頼できる AI を実行し、これらすべてを 1 カ所で行うことで、顧客は優れたコスト・パフォーマンス、インテルの CPU、GPU、AI アクセラレーターへのアクセス、オープン AI ソフトウェア・スタックによる柔軟性が得られます。

次世代のインテル® Core™ Ultra プロセッサー搭載の AI PC で AI を高速化

2024年9月3日 | AI 開発のジャンプスタート (英語)、AI PC 向け開発 (英語)

本日、インテルは次世代のインテル® Core™ Ultra プロセッサー (開発コード名 Lunar Lake) を発表し、最新の AI PC における効率、コンピューティング、AI パフォーマンスの飛躍的進歩を明らかにしました。

本日、インテルは次世代のインテル® Core™ Ultra プロセッサー (開発コード名 Lunar Lake) を発表し、最新の AI PC における効率、コンピューティング、AI パフォーマンスの飛躍的進歩を明らかにしました。

ISV、開発者、AI エンジニア、データ・サイエンティストは、クライアント・プラットフォームの AI 性能を業務に活用できます。AI PC は、モデル、アプリケーション、ソリューションの開発と最適化に最適です。

- オープンソースの基礎モデル、PyTorch* や TensorFlow* などの最適化されたフレームワーク、インテル® OpenVINO™ ツールキットを使用して、AI のトレーニングと推論を簡素化および高速化します。

- インテル® ソフトウェア開発ツールを活用して、インテル® AVX-512 やインテル® AI ブーストなどの AI PC の最先端機能を活用し、パフォーマンスと開発の生産性を向上させます。

- oneAPI (英語) ヘテロジニアス・プログラミングを使用して既存の CPU/GPU コードを移植し、最大 40% の消費電力を削減しながら高速に実行できるように最適化します。

2024年末までに、統合ソフトウェア開発キット (SDK) を備えたインテル® Core™ Ultra プロセッサー・ベースのプラットフォームもインテル® Tiber™ デベロッパー・クラウドで利用できるようになる予定です。

詳細 (英語)

あらゆるところに AI: インテル® ソフトウェア開発ツール & AI ツール 2024.2 リリース

2024年8月9日 | インテル® ソフトウェア開発ツール、インテル® Tiber™ デベロッパー・クラウド

高性能で量産可能な AI への高速パス

インテルの oneAPI および oneAPI を採用した AI ツールの最新リリースは、ソリューションまでの時間を短縮し、ハードウェアの選択肢を増やし、安定性を向上することで、開発者が高性能な AI (および HPC) アプリケーションをより簡単に提供できるようにチューニングされています。実稼働用のクラウド環境での AI の構築とデプロイについては、インテル® Tiber™ デベロッパー・クラウドの新しいハードウェアとサービスをご確認ください。

3 つの特長

- より高速で応答性の高い AI – oneDNN (英語)、インテルにより最適化された AI フレームワーク、インテル® AMX1 を搭載した、今後発売されるインテル® Xeon® 6 プロセッサー (P-cores) で最大 2 倍の生成 AI パフォーマンスを実現し、アナリティクスやメディアなどのワークロードでは (インテル® Xeon® 6 プロセッサーの E-cores を使用して) 最大 1.6 倍のパフォーマンスを実現します2。将来に対応した比類のない AI 計算能力を備えた今後発売されるクライアント・プロセッサー (開発コード名 Lunar Lake) と、前世代の 3.5 倍の AI スループット (英語) を含む3、AI PC 上で LLM 推論スループットとスケーラビリティーを向上します。ツールは、Llama* 3.1 や Phi-3 などの 500 以上のモデル (英語) をサポートしています。インテル® Tiber™ デベロッパー・クラウドにより、コスト効率に優れたマネージド・インフラストラクチャー上に実稼働用 AI をデプロイして拡張できます。

- 選択肢と制御の拡大 – 業界標準の AI フレームワークに継続的に最適化をアップストリームすることで、インテルのすべての CPU と GPU で AI および HPC ワークロードのパフォーマンスを最大化します。ユビキタス・ハードウェアへのデプロイを容易にするため、最小限のコーディングでインテル® GPU 上で PyTorch* 2.4 (英語) を実行およびデプロイできます。oneMKL、oneTBB、oneDPL の最適化とインテル® oneAPI DPC++/C++ コンパイラーの強化された SYCL* Graph 機能により、アプリケーションの効率と制御が向上します。このリリースでは、AI、テクニカル、エンタープライズ、グラフィックスの計算ワークロードを高速化するため、インテル® Xeon® 6 プロセッサー (E-cores と今後の P-cores) および今後発売されるプロセッサー (開発コード名 Lunar Lake) の幅広いツールがサポートされています。

- 簡素化されたコード最適化 – インテル® VTune™ プロファイラーのプラットフォームを考慮した最適化、幅広いフレームワーク、新しいハードウェア (開発コード名 Grand Ridge) プロセッサーにより、AI トレーニングと推論のパフォーマンスが向上します。インテル® DPC++ 互換性ツールを使用して 100 以上の CUDA* API を自動的に移行し、CodePin インストルメンテーションにより CUDA* から SYCL へのコード移行における不整合を正確に特定することで、CUDA* コードから SYCL* へ容易に移行できます。

新機能

以下は、コンポーネント・レベルの詳細です。基本ツールは、インテル® oneAPI ベース・ツールキットとインテル® HPC ツールキットにバンドルされています。AI ツールについては、セレクターツール (英語) で必要なものだけを入手できます。

コンパイラー

- インテル® oneAPI DPC++/C++ コンパイラーは、SYCL* Graph 機能を強化し、一時停止/再開をサポートして、より優れた制御とパフォーマンス・チューニングを実現します。デフォルトのコンテキストが有効な Windows* で SYCL* パフォーマンスを向上します。また、カーネル・コンパイラーの最新リリースで SPIR-V* と OpenCL* クエリーをサポートして、計算カーネルの柔軟性と最適化を強化します。

- インテル® Fortran コンパイラーは、整数オーバーフロー制御オプション (-fstrict-overflow、Qstrict-overflow[-]、および -fnostrict-overflow) を追加して、正しく機能することを確実にします。最新の OpenMP* 標準 5.x および 6.0 への準拠を拡張し、スレッド使用量の制御とループの最適化を強化します。また、メモリー管理、パフォーマンス、効率性を向上する OpenMP* ランタイム・ライブラリー拡張も追加しています。

ライブラリー

- インテル® ディストリビューションの Python* では、生産性向上のため、Data Parallel Control Library にソートおよび合計関数が追加されました。パフォーマンス向上のため、NumPy* 向け Data Parallel Extension に新たな累積関数と改良された線形代数関数が提供されています。

- インテル® oneAPI ディープ・ニューラル・ネットワーク・ライブラリー (インテル® oneDNN) (英語) は、インテルの AI が強化されたクライアント・プロセッサーおよびサーバー・プラットフォームでパフォーマンスを向上するプロダクション品質の最適化を提供し、matmul での int8 および int4 重み展開のサポートにより AI ワークロードの効率を高め、LLM を高速化してより迅速に洞察と結果をもたらします。

- インテル® oneAPI マス・カーネル・ライブラリー (インテル® oneMKL) は、インテル® データセンター GPU マックス・シリーズ上で 実数および複素数の 2D FFT と 3D FFT のパフォーマンスを強化します。

- インテル® oneAPI データ・アナリティクス・ライブラリー (インテル® oneDAL) は、DPC++ スパース gemm プリミティブ、DPC++ スパース gemy プリミティブ、スパース logloss 関数プリミティブをサポートし、アルゴリズム全体でスパース関数を拡張しています。

- インテル® oneAPI DPC++ ライブラリー (インテル® oneDPL) (英語) は、開発者がマルチアーキテクチャー・デバイス向けの並列プログラムを記述できるようにし、インテルおよび他のベンダーの GPU で既存のアルゴリズムを改善する、新しい C++ 標準テンプレート・ライブラリーの inclusive_scan アルゴリズム拡張を追加しています。

- インテル® oneAPI コレクティブ・コミュニケーション・ライブラリー (インテル® oneCCL) (英語) は、メモリーや I/O などのシステムリソースの使用率を向上する複数の機能拡張を導入し、さらに優れたパフォーマンスを実現します。

- インテル® oneAPI スレッディング・ビルディング・ブロック (インテル® oneTBB) は、スレッドとマルチスレッドの同期を最適化し、第 5 世代インテル® Xeon® プロセッサーでの起動レイテンシーを短縮し、Apple* Mac* を含む ARM* CPU で OpenVINO™ ツールキットのパフォーマンスを最大 4 倍に高速化します。

- インテル® インテグレーテッド・パフォーマンス・プリミティブ (インテル® IPP) は、zlip 1.3.1 の最適化パッチを追加して、データ圧縮タスクの圧縮率とスループットを向上し、インテル® GPU 上でインテル® AVX-512 VNNI を使用して一部の色変換関数の高速画像処理を実現します。

- インテル® IPP Cryptography (英語) は、NIST FIPS 140-3 準拠を含む政府機関と民間セクター全体のセキュリティーを拡張し、単一バッファー実装向けに最適化された LMS ポスト量子暗号アルゴリズムでデータ保護を強化します。また、簡素化された新しいコードサンプルを使用してインテル® Xeon® プロセッサーとインテル® Core™ Ultra プロセッサーの AES-GCM パフォーマンスを最適化し、Linux* での Clang 16.0 コンパイラー・サポートにより開発を効率化します。

- インテル® MPI ライブラリーは、開発者が特定のスレッドを個々の NIC に固定できるようにすることで、複数のネットワーク・インターフェイス・カードを搭載したマシンでアプリケーション・パフォーマンスを向上します。また、第 5 世代インテル® Xeon® プロセッサー向けに、GPU 対応ブロードキャスト、RMA ピアツーピア・デバイス間通信、ノード内スレッド分割、Infiniband* チューニングの最適化を追加しています。

AI および ML ツールとフレームワーク

- PyTorch* 2.4 では、インテル® データセンター GPU マックス・シリーズの初期サポート (英語) が提供され、インテル® GPU と SYCL* ソフトウェア・スタックが公式の PyTorch* スタックに追加され、AI ワークロードのさらなる高速化に役立ちます。

- PyTorch* 向けインテル® エクステンション (英語) は、Eager モードで FP16 最適化を使用して、Bert_Large、Stable Diffusion の CPU パフォーマンスのチューニングを改善します。一般的な LLM モデル (英語) は、重みのみの量子化 (Weight-Only Auantization、WOQ) (英語) を使用してインテル® GPU 向けに最適化されており、精度を低下させることなくメモリーアクセスを減らし、パフォーマンスを向上します。

- インテル® ニューラル・プロセッサー (英語) は、15 以上の一般的な LLM 量子化レシピ (英語) で SmoothQuant および WOQ アルゴリズムを使用して、INT8 および INT4 LLM モデルのパフォーマンスを向上します。WOQ のインプレース・モードを利用して、量子化プロセスの実行時にメモリー・フットプリントを削減します。LLM 推論用の低ビット量子化法である AutoRound を使用してモデルの精度を向上させ、より少ない手順で丸め値と重みの最小/最大値を微調整します。PyTorch* LLM 用の新しい Wanda および DSNOT プルーニング・アルゴリズムは、AI 推論中のパフォーマンスを向上するのに役立ち、SNIP アルゴリズムは、マルチカードまたはマルチノード (CPU) でのモデルのスケーリングを可能にします。

解析、デバッグ、コード移行ツール

- インテル® VTune™ プロファイラーは、最適ではないインテル® oneCCL 通信に関する詳細なデータを提供し、.NET8 をサポートし、今後発売されるプロセッサー (開発コード名 Grand Ridge) をサポートします。テクニカルプレビュー機能により、開発者はソフトウェア・パフォーマンス解析における潜在的なボトルネックを高レベルで把握してから、トップダウンのマイクロアーキテクチャー・メトリックを調査してより深い分析を行うことができます。

- インテル® DPC++ 互換性ツールは、オプションで有効になる SYCL* イメージ API 拡張への移行により、マルチベンダー GPU 上のビジュアル AI アプリケーションと画像処理アプリケーションを高速化します。カーネル実行ログを自動的に比較し、移行された SYCL* コードの違いを報告します。よく使用される 126 個の CUDA* API は自動的に移行できます。

- インテル® ディストリビューションの GDB* (英語) は、Windows* マシンでインテル® Core™ Ultra プロセッサーをサポートし、変数を監視および解析して VS Code でより迅速かつ効率的にアプリケーションの安定性を強化する Land Variable Watch Window を追加します。また、インテル® Control-flow Enforcement Technology (CET) を拡張してアプリケーションのセキュリティーを強化します。

ブログ (英語) と各ツールのリリースノート (英語) では、開発者の視点から新機能についてさらに詳しく説明しています。

インテル® Tiber™ デベロッパー・クラウドでの大規模な AI ソリューションのビルドとデプロイ

人気の高い基本モデルと最適化されたツールおよびフレームワークを含む、oneAPI をベースに構築されたオープン・ソフトウェア・スタックを使用して、最新のインテル® アーキテクチャーで AI モデル、アプリケーション、および実稼働用ワークロードを開発およびデプロイできます。

新しいハードウェアとサービスにアクセス可能

- インテル® データセンター GPU マックス・シリーズ搭載の仮想マシン

- インテル® Gaudi® 2 AI アクセラレーターと生成 AI Jupyter* Notebook

- インテル® Kubernetes Service と K8s API によるコンテナーのデプロイメント

- 出荷前のインテル® Xeon® 6 プロセッサーを搭載したプレビュー環境

インテル® Gaudi® 2 AI アクセラレーターが AI コンピュートと生成 AI の低コストな代替手段を実現

2024年6月12日 | インテル® Gaudi® 2 AI アクセラレーター、インテル® Tiber™ デベロッパー・クラウド

本日、MLCommons は、業界の AI パフォーマンス・ベンチマークである「MLPerf Training v4.0」の結果を発表しました。インテルの結果は、インテル® Gaudi® 2 AI アクセラレーターが企業や顧客に提供する選択肢を示しています。

本日、MLCommons は、業界の AI パフォーマンス・ベンチマークである「MLPerf Training v4.0」の結果を発表しました。インテルの結果は、インテル® Gaudi® 2 AI アクセラレーターが企業や顧客に提供する選択肢を示しています。

インテルは、インテル® Tiber™ デベロッパー・クラウドでトレーニングした大規模なインテル® Gaudi® 2 システム (1,024 基のインテル® Gaudi® 2 AI アクセラレーター) の結果を提出し、AI アクセラレーターのパフォーマンスとスケーラビリティー (70B-175B パラメーターの LLM を容易にトレーニング可能)、および MLPerf の GPT-3 175B1 パラメーター・ベンチマーク・モデルを効率的にトレーニングできるインテル® Tiber™ デベロッパー・クラウドの能力を実証しました。

結果

MLPerf ベンチマークの結果から、インテル® Gaudi® 2 AI アクセラレーターは、引き続き AI コンピューティングにおける NVIDIA* H100 の唯一の代替品であることが分かります。1,024 基のインテル® Gaudi® 2 AI アクセラレーターを搭載した AI システムを使ってインテル® Tiber™ デベロッパー・クラウドでトレーニングした GPT-3 の TTT (time-to-train、トレーニング時間) は 66.9 分であり、これはインテル® Tiber™ デベロッパー・クラウド環境内の超大規模 LLM におけるインテル® Gaudi® 2 AI アクセラレーターの強力なスケーリング性能を証明しています1。

ベンチマーク・スイートには、LoRA (Low-Rank Adaptation、大規模言語および拡散モデルのファイン・チューニング手法) を使用して Llama 2 70B パラメーター・モデルをファイン・チューニングする新しい測定も含まれていました。インテルの提出物は、8 個のインテル® Gaudi® 2 AI アクセラレーターで 78.1 分の TTT を達成しました。

詳細 (英語)

インテル® Gaudi® AI アクセラレーターがもたらす AI 価値

高いコストによって、多くの企業が AI 市場から撤退しています。インテル® Gaudi® AI アクセラレーターはそれを変えようとしています。COMPUTEX でインテルが発表した、システム・プロバイダー向けに提供されるユニバーサル・ベースボード (UBB) と 8 基のインテル® Gaudi® 2 AI アクセラレーターを含む標準的な AI キットの価格は $65,000 で、同等の競合プラットフォームと比べてコストが 3 分の 1 になると推定されます。また、8 基のインテル® Gaudi® 3 AI アクセラレーターと UBB を含むキットの価格は $125,000 で、同等の競合プラットフォームと比べてコストが 3 分の 2 になると推定されます2。

インテル® Tiber™ デベロッパー・クラウドの価値

インテルのクラウドは、AI モデル、アプリケーション、ソリューションを開発およびデプロイするための、ユニークで管理されたコスト効率の高いプラットフォームを企業顧客に提供します。インテル® Tiber™ デベロッパー・クラウドでは、インテルのアクセラレーター、CPU、GPU、オープン AI ソフトウェア・スタック、その他のサービスに簡単にアクセスできます。詳細はこちら。

関連情報

1 MLPerf の GPT-3 測定は、MLCommons ベンチマークを共同で考案した参加企業によって決定された、モデル全体の 1% の典型的なスライスで実施されています。

2 カードやシステムの価格ガイダンスはモデリングのみを目的としています。最終的な価格については、各 OEM メーカーにご相談ください。結果は数量とリードタイムによって異なる場合があります。

ワークロードと構成については、MLCommons.org を参照してください。結果は異なることがあります。

インテル® Core™ Ultra プロセッサー上で実行が最適化された AI モデルが 500 を超える

2024年5月1日 | インテル® Core™ Ultra プロセッサー・ファミリー

インテルが PC 業界で最も堅牢な AI PC ツールチェーンを構築

インテルは本日、市場で入手可能な業界最高峰の AI PC プロセッサーである新しいインテル® Core™ Ultra プロセッサー上で実行が最適化された、事前学習済み AI モデルの数が 500 を超えたことを発表しました。

インテルは本日、市場で入手可能な業界最高峰の AI PC プロセッサーである新しいインテル® Core™ Ultra プロセッサー上で実行が最適化された、事前学習済み AI モデルの数が 500 を超えたことを発表しました。

大規模言語、拡散、超解像、物体検出、画像分類とセグメンテーション、コンピューター・ビジョンなど、20 以上のローカル AI 推論カテゴリーにおよぶ、Phi-2、Mistral、Llama、BERT、Whisper、Stable Diffusion 1.5 などのモデルが含まれます。

これは、AI PC の変革を促進しサポートするインテルの取り組みにとって画期的な瞬間です。インテル® Core™ Ultra プロセッサーは、急成長している AI PC プロセッサーで、新しい AI エクスペリエンス、没入型グラフィックス、最適なバッテリー寿命が特徴です。また、他のプロセッサー・ベンダーよりも多くの AI モデル、フレームワーク、ランタイムに対応した、AI PC 開発用の最も堅牢なプラットフォームです。

500 のモデルはすべて、CPU、GPU、NPU にデプロイできます。これらのモデルは、OpenVINO™ Model Zoo、Hugging Face*、ONNX* Model Zoo、PyTorch* など、業界で人気のあるソースで利用可能です。

詳細 (英語)

関連情報

インテルのテクノロジーにより最適化された Canonical Ubuntu* 24.04 LTS リリース

2024年4月25日 | Ubuntu* 24.04 LTS (英語)、インテル® QAT、インテル® TDX (英語)

本日、Canonical は Ubuntu* 24.04 LTS (開発コード名 Noble Numbat) のリリースを発表しました。この 10 回目の長期サポートリリースでは、CPU 上のワークロードを高速化するインテル® クイックアシスト・テクノロジー (インテル® QAT) 統合や、プライベート・データセンターにおけるコンフィデンシャル・コンピューティングを強化するインテル® Trust Domain Extensions (インテル® TDX) のサポートなど、パフォーマンス・エンジニアリングとコンフィデンシャル・コンピューティングの進歩が融合されています。

本日、Canonical は Ubuntu* 24.04 LTS (開発コード名 Noble Numbat) のリリースを発表しました。この 10 回目の長期サポートリリースでは、CPU 上のワークロードを高速化するインテル® クイックアシスト・テクノロジー (インテル® QAT) 統合や、プライベート・データセンターにおけるコンフィデンシャル・コンピューティングを強化するインテル® Trust Domain Extensions (インテル® TDX) のサポートなど、パフォーマンス・エンジニアリングとコンフィデンシャル・コンピューティングの進歩が融合されています。

Ubuntu* は、インテルの最先端機能を利用するのに最適です。Canonical とインテルは、プラットフォーム全体で大規模なパフォーマンスとセキュリティーを実現するという理念を共有しています。

インテル コーポレーション システム・ソフトウェア・エンジニアリング VP 兼 GM Mark Skarpness

主な機能

- パフォーマンス・エンジニアリング・ツール – システムコール・パフォーマンスが向上した最新の Linux* 6.8 カーネル、ppc64el でのネストされた KVM サポート、カーネルタスクのスケジューリング遅延を軽減する機能、およびより完全な CPU とオフ CPU をプロファイルするため、すべての 64 ビット・アーキテクチャーでデフォルトでオンになるフレーム・ポインターを含みます。

- インテル® QAT 統合 – 第 4 世代および新しいインテル® Xeon® スケーラブル・プロセッサーでの暗号化と圧縮の高速化、CPU 利用率の軽減、ネットワークとストレージ・アプリケーションのパフォーマンス向上を実現します。

- インテル® TDX サポート – アプリケーション層に変更を加えることなく、ホスト側とゲスト側の両方で拡張機能をシームレスにサポートし、既存のワークロードのコンフィデンシャル・コンピューティング環境への移植と移行を大幅に簡素化します。

- 開発者の生産性の向上 – Python* 3.12、Ruby 3.2、PHP 8.3、Go* 1.22 が含まれており、.NET、Java*、Rust* の開発者エクスペリエンスに重点が置かれています。

詳細 (英語)

Ubuntu* 24.04 LTS のダウンロード (英語)

ブログ記事「Noble Numbat Deep Dive」 (英語)

Canonical について

Ubuntu* の発行元である Canonical (英語) は、オープンソースのセキュリティー、サポート、サービスを提供しています。そのポートフォリオは、最小のデバイスから最大のクラウドまで、カーネルからコンテナまで、データベースから AI まで、重要なシステムをカバーしています。

Seekr がインテル® Tiber™ デベロッパー・クラウドで大幅なコスト削減と AI ビジネスの成長を実現

2024年4月10日 | インテル® Tiber™ デベロッパー・クラウド

コンテンツの評価と生成向けの低コストで信頼できる AI

Fast Company によって 2024年の最も革新的な企業の 1 つに選ばれた Seekr (英語) は、インテル® Tiber™ デベロッパー・クラウド1 を利用して、インテル® Gaudi® 2 AI アクセラレーターを含む最新のインテルのハードウェアとソフトウェアで構成される、費用対効果に優れたクラスター上で高度な LLM を構築、トレーニング、デプロイしています。AI を高速化するインテルとの戦略的協業により、Seekr は増え続ける計算能力への需要に対応しつつ、クラウドコストを削減し、ワークロードのパフォーマンス向上を達成しています。

Fast Company によって 2024年の最も革新的な企業の 1 つに選ばれた Seekr (英語) は、インテル® Tiber™ デベロッパー・クラウド1 を利用して、インテル® Gaudi® 2 AI アクセラレーターを含む最新のインテルのハードウェアとソフトウェアで構成される、費用対効果に優れたクラスター上で高度な LLM を構築、トレーニング、デプロイしています。AI を高速化するインテルとの戦略的協業により、Seekr は増え続ける計算能力への需要に対応しつつ、クラウドコストを削減し、ワークロードのパフォーマンス向上を達成しています。

ソリューションの概要

Seekr の人気製品である Flow と Align は、顧客が AI を活用してコンテンツと広告戦略を展開および最適化し、スケーラブルで構成可能なワークフローを使用して LLM パイプライン全体をトレーニング、構築、管理するのに役立ちます。

これには膨大な計算能力が必要であり、これまでは多額のインフラストラクチャー投資とクラウドコストを要していました。

運用ワークロードをオンプレミスからインテル® Tiber™ デベロッパー・クラウドに移行することで、Seekr は、数千枚のインテル® Gaudi® 2 カードを含むインテルのハードウェアおよびソフトウェア・テクノロジーの能力と容量を利用して、従来よりも低コストで、非常に高いパフォーマンスの LLM を構築できるようになりました。

詳細 (英語) →

ケーススタディー (ベンチマークを含む)

Seekr について

Seekr は、ブランドの信頼に対する顧客のニーズを解決しながら、インターネットをより安全で価値のあるものにすることを目標に、大規模な信頼性の高いコンテンツを識別、採点、生成する大規模言語モデル (LLM) を構築しています。同社の顧客には、Moderna、SimpliSafe、Babbel、Constant Contact、Indeed が含まれます。

1 旧「インテル® デベロッパー・クラウド」は、エンタープライズ・ビジネス・ソリューションのインテル® Tiber™ ポートフォリオの一部になりました。

Intel Vision 2024 でオープンかつセキュアなエンタープライズ AI への全面的な取り組みを発表

2024年04月9日

Intel Vision 2024 (英語) において、インテル コーポレーション CEO の Pat Gelsinger は、AI 全体にわたる新しい戦略、次世代の製品とポートフォリオ、顧客、コラボレーションを紹介しました。

最初に紹介されたインテル® Tiber™ は、AI、クラウド、エッジ、信頼性とセキュリティーにわたるエンタープライズ向けソフトウェアとサービスの展開を合理化する補完的なビジネス・ソリューションと、エンタープライズ向け生成 AI にさらなるパフォーマンス、オープン性、選択肢をもたらすインテル® Gaudi® 3 アクセラレーターで構成されるポートフォリオです。

20 社を超える顧客企業が、インテル® アーキテクチャー上で動作する主要な AI ソリューションを展示し、LLM/LVM プラットフォーム・プロバイダーである Landing.ai、Roboflow、および Seekr が、インテル® Tiber™ デベロッパー・クラウド上でインテル® Gaudi® 2 アクセラレーターを使用して、運用レベルのソリューションを開発、チューニング、デプロイするデモを実施しました。

またインテルは、Google Cloud、Thales、Cohesity とのコラボレーションにより、インテルのコンフィデンシャル・コンピューティング機能を各社のクラウド・インスタンスに実装する計画を発表しました。これには、インテル® トラスト・ドメイン・エクステンションズ (インテル® TDX)、インテル® ソフトウェア・ガード・エクステンションズ (インテル® SGX)、インテル® Tiber™ Trust Services1 認証サービスが含まれます。

さらに、エンタープライズ AI 向けオープン・プラットフォームの開発、E-core および P-core 搭載のインテル® Xeon® 6 プロセッサーとクライアント、エッジ、コネクティビティー向けのシリコンを含むインテルの AI ロードマップとオープン・エコシステム・アプローチの拡大についても発表がありました。

あらゆる企業が急速に AI 対応の組織へと移行しています。インテル® Gaudi® アクセラレーター、インテル® Xeon® プロセッサー、インテル® Core™ Ultra プロセッサー、イーサネット対応ネットワーク、オープン・ソフトウェアなど、柔軟なソリューションを結集したインテルのオープンでスケーラブルなシステムは、現在および将来にわたって企業の AI ニーズに応え、企業全体に AI を浸透させています。

主な内容

ビジネス向けソリューションを提供するインテル® Tiber™ ポートフォリオは、AI を含め企業環境へのソフトウェアやサービスの導入を効率化し、顧客企業と開発者がセキュリティー、コンプライアンス、パフォーマンスのいずれも妥協することなく、ニーズに合ったソリューションを見つけ、イノベーションを加速し、価値を最大限に引き出すことを容易にします。完全な展開は 2024年の第 3 四半期に予定されています。インテル® Tiber™ については、こちらを参照してください。

ビジネス向けソリューションを提供するインテル® Tiber™ ポートフォリオは、AI を含め企業環境へのソフトウェアやサービスの導入を効率化し、顧客企業と開発者がセキュリティー、コンプライアンス、パフォーマンスのいずれも妥協することなく、ニーズに合ったソリューションを見つけ、イノベーションを加速し、価値を最大限に引き出すことを容易にします。完全な展開は 2024年の第 3 四半期に予定されています。インテル® Tiber™ については、こちらを参照してください。

インテル® Gaudi® 3 AI アクセラレーターは、インテル® Gaudi® 2 AI アクセラレーターと比較して、計算能力が 4 倍、メモリー帯域幅が 1.5 倍増加しており、LLaMa 7B および 70B、Falcon 180B の LLM 推論で平均 50%、電力効率で 60% NVIDIA* H100 を上回るパフォーマンスを発揮すると予測されています。インテル® Tiber™ デベロッパー・クラウドを含め、2024年の第 2 四半期に利用可能になる予定です。

インテル® Tiber™ デベロッパー・クラウドの最新リリースには、インテル® Gaudi® 2 アクセラレーターとインテル® データセンター GPU マックス・シリーズの大規模クラスターをホストする BMaaS (Bare Metal as a Service) オプション、インテル® Gaudi® 2 アクセラレーター上で動作する VM、ファイルストレージを含む StaaS (Storage as a Service)、クラウドネイティブな AI ワークロード向けのインテル® Kubernetes Service など計算能力を高める新しいハードウェアとサービスが含まれています。

Seekr がインテル® Tiber™ デベロッパー・クラウドを利用して、大規模なコンテンツの生成と評価向けの信頼できる LLM をデプロイした事例をご覧ください。

コンフィデンシャル・コンピューティングにおける Thales と Cohesity とのコラボレーションは、信頼性とセキュリティーを向上し、企業顧客のリスクを軽減します。

- 世界有数のテクノロジーおよびセキュリティー・プロバイダーの Thales (英語) は、エンドツーエンドのデータ保護を提供する Google Cloud Platform* 上の独自の CipherTrust データ・セキュリティー・プラットフォームと、コンフィデンシャル・コンピューティングとクラウドに依存しない信頼性認証を提供するインテル® Tiber™ Trust Services で構成されるデータ・セキュリティー・ソリューションを発表しました。これにより、企業は保存中、転送中、使用中のデータを保護する追加の制御が可能になります。

- AI を活用したデータ・セキュリティーと管理のリーダーである Cohesity は、Cohesity Data Cloud にコンフィデンシャル・コンピューティング機能を追加したことを発表しました。このソリューションは、インテル® SGX およびインテル® Tiber™ Trust Services と連携し、使用中のデータを暗号化する FortKnox サイバー保管庫サービスを活用することで、メインメモリーで処理中のデータに悪意のある企業がアクセスするリスクを低減します。これは、金融サービス、ヘルスケア、政府機関など規制のある産業にとって非常に重要です。

関連情報

- インテルのエンタープライズ・ソフトウェア・ソリューション

- インテル® Tiber™ デベロッパー・クラウド

- インテル® Confidential Computing Solutions (英語)

- インテル® トラスト・ドメイン・エクステンションズ (インテル® TDX)

- インテル® ソフトウェア・ガード・エクステンションズ (インテル® SGX)

1 旧インテル® Trust Authority

インテル® ソフトウェア開発ツールのバージョン 2024.1 リリース

2024年03月28日 | インテル® ソフトウェア開発ツール

世界初の SYCL* 2020 準拠ツールチェーンで、自信を持ってコードを高速化

インテル® ソフトウェア開発ツール 2024.1 がリリースされました。アクセラレーテッド・コンピューティングにとって重要なマイルストーンとして、インテル® oneAPI DPC++/C++ コンパイラーが SYCL* 2020 仕様 (英語) を完全に採用した最初のコンパイラー (英語) となりました。

なぜこれが重要なのか?

SYCL* 2020 準拠のコンパイラーがあることで、開発者はコードが移植可能で、現在および将来のさまざまなアーキテクチャーとハードウェア・ターゲット (GPU を含む) にわたって確実にパフォーマンスを発揮することを確信できます。

「SYCL* 2020 は、生産性の高いヘテロジニアス・コンピューティングを可能にし、今日のソフトウェアとハードウェアの複雑な現実に対応するハイパフォーマンスな並列ソフトウェアを作成するために必要な制御を提供します。SYCL* 2020 Khronos Adopter となったことで、オープン・スタンダードのサポートに対するインテルの取り組みが改めて示されました。」

主な利点

自信を持ってコードを作成し、高速にビルド – SYCL* 2020 に完全準拠したインテル® oneAPI DPC++/C++ コンパイラーを利用して、最新の C++ コードのパフォーマンスと生産性を高めるため並列処理を最適化します。AI、HPC、分散コンピューティングにわたる新しいマルチアーキテクチャー機能を探索します。また、拡張されたウェブベースのセレクター (英語) のオプションセットを使用して、関連する AI ツールに素早く簡単にアクセスできます。

AI ワークロードの高速化と計算コストの軽減 – インテルの新しい CPU および GPU でパフォーマンスを向上します。これには、第 5 世代インテル® Xeon® スケーラブル・プロセッサー上で oneDNN を使用した最大 14 倍のパフォーマンス向上1、PyTorch* や TensorFlow*2 などの一般的なディープラーニング・フレームワークとライブラリーの 10 倍から 100 倍の高速化、XGBoost、LightGBM、および CatBoost にわたるより高速な勾配ブースティング推論が含まれます。scikit-learn* 向けインテル® エクステンションのアルゴリズム拡張機能を使用して、コストを削減して並列計算を実行します。

イノベーションの促進とデプロイの拡大 – インテル® oneAPI DPC++/C++ コンパイラーで複数の SYCL* バックエンドで利用できるようになった、SYCL* Graph を使用した効率良いコードオフロードにより、一度のチューニングで汎用的にデプロイできます。インテル® DPC++ 互換性ツールでは、より多くの CUDA* API を CUDA* から SYCL* へ簡単に移行できるようになりました。さらに、CodePin 技術プレビュー (SYCLomatic の新機能) で時間の節約を調査し、テストベクトルを自動キャプチャーし、移行後すぐに検証を開始できます。Codeplay は、NVIDIA* GPU と AMD* GPU 用の oneAPI プラグインに新しいサポートと機能を追加しています。

要点

以下は、コンポーネント・レベルの詳細です。

コンパイラー

インテル® oneAPI DPC++/C++ コンパイラーは、SYCL* 2020 準拠の最初のコンパイラーであり、開発者は SYCL* コードが移植可能であり、現在および将来のさまざまな GPU 上で確実に動作することを確信できます。強化された SYCL* Graph により、マルチスレッド処理やスレッドセーフ関数をアプリケーションとシームレスに統合できるようになり、複数の SYCL* バックエンドで利用できるようになったため、一度のチューニングでどこでもデプロイすることが可能です。OpenMP* 5.0、5.1、5.2、TR12 言語標準への準拠が拡張され、パフォーマンスが向上しました。

インテル® Fortran コンパイラーは、C コードと Fortran コード間の互換性と相互運用性の向上、三角関数の計算の簡素化、事前定義されたデータ型など、Fortran 2023 言語機能をさらに追加して、コードの移植性を向上させ、一貫した動作を保証します。OpenMP* オフロード・プログラミングの生産性が向上し、コンパイラーの安定性も向上しています。

パフォーマンス・ライブラリー

インテル® oneAPI マス・カーネル・ライブラリー (インテル® oneMKL) は、インテル® GPU とホスト CPU 間のデータ転送を軽減する新しい最適化と機能を導入し、CNR を介してインテル® GPU 上で BLAS レベル 3 演算の結果を実行間で再現できるようにします。また、CUDA* と同等の機能を追加することで、CUDA* から SYCL* への移行を合理化します。

インテル® oneAPI データ・アナリティクス・ライブラリー (インテル® oneDAL) は、精度を犠牲にすることなく、XGBoost、LightGBM、および CatBoost にわたる勾配ブースティング推論の高速化を可能にします。観測値のクラスタリングに使用される特徴のサブセットを自動的に識別するスパース K 平均のサポートにより、クラスタリングを改善します。

インテル® oneAPI ディープ・ニューラル・ネットワーク・ライブラリー (インテル® oneDNN) (英語) は、LLM パフォーマンスを向上する GPT-Q のサポート、プリミティブと Graph API の fp8 データ型、レイヤーの正規化用の fp16 および bf16 のスケール引数とシフト引数、固定環境の実行間で結果がビット単位で同一であることを保証するオプトイン決定論的モードが追加されています。

インテル® oneAPI DPC++ ライブラリー (インテル® oneDPL) (英語) は、インテル® GPU 上でアプリのパフォーマンスを向上させる特殊なソート・アルゴリズムと、ステンシル計算のニーズに対応するマスク入力を備えた transform_if バリアントが追加され、AI と科学計算を高速化するため、ヒストグラム・アルゴリズムを使用して C++ STL 形式のプログラミングを拡張しています。

インテル® oneAPI コレクティブ・コミュニケーション・ライブラリー (oneCCL) (英語) は、すべての主要な通信パターンを最適化し、メモリー効率の良い方法でメッセージの受け渡しを高速化し、推論パフォーマンスを向上します。

インテル® インテグレーテッド・パフォーマンス・プリミティブ (インテル® IPP) は、大規模なデータ集約型アプリケーションにおいて高速なデータ転送とストレージ要件の軽減を実現するため、XMSS ポスト量子ハッシュベースの暗号化アルゴリズム (技術プレビュー)、FIPS 140-3 準拠、更新された LZ4 可逆データ圧縮アルゴリズムなど、量子コンピューティング、サイバーセキュリティー、およびデータ圧縮の機能とサポートを拡張しています。

インテル® MPI ライブラリーは、リモートメモリーへ効率良くアクセスする GPU RMA や、MPI 4.0 の Persistent Collectives や Large Counts サポートなど、アプリケーションのパフォーマンスとプログラミングの生産性を向上する新機能が追加されています。

AI および ML ツールとフレームワーク

インテル® ディストリビューションの Python* は、データ並列制御 (dpctl) ライブラリーの Python* 配列 API 標準への完全準拠や NVIDIA* デバイスのサポートなど、より将来性の高いコードを開発する機能を拡張してます。NumPy* 用データ並列拡張機能では、線形代数、データ操作、統計、データ型が強化され、キーワード引数のサポートが拡張されています。Numba* 用データ並列拡張機能では、カーネルの起動時間が改善されています。

scikit-learn* 向けインテル® エクステンション (英語) は、増分共分散を使用して変更されたデータセット部分のみで計算を行い、SPMD インターフェイスを使用して並列 GPU 計算を実行することで、GPU の計算コストを軽減します。

Modin 向けインテル® ディストリビューション (英語) は、データ資産の脆弱性を事前に特定して修復する堅牢なセキュリティー・ソリューションや、非同期実行を最適化するパフォーマンスの修正など、セキュリティーとパフォーマンスを大幅に強化します (注: 2024.2 リリースでは、開発者はアップストリーム・チャネルを通じて Modin にアクセスできます)。

アナライザーとデバッガ―

インテル® VTune™ プロファイラーは、SYCL* アプリケーションのパフォーマンス低下を招くホストと GPU 間の暗黙の USM データ移動を特定し、理解するのに役立つ機能が拡張されています。また、.NET 8、Ubuntu* 23.10、および FreeBSD* 14.0 がサポートされました。

インテル® ディストリビューションの GDB (英語) は、最新のアプリケーション・デバッグ機能に対応するため、GDB 14 ベースに変わりました。メモリーアクセスの問題をリアルタイムでモニターし、トラブルシューティングできます。GPU アクセラレーション・アプリケーションのより包括的なデバッグと最適化のため、大規模汎用レジスターファイル用のデバッグモードがサポートされました。

レンダリングとレイトレーシング

インテル® Embree は、クロスアーキテクチャー・コードの移行をスムーズにするため、SYCL* プラットフォームとドライバーのエラーレポートを強化しています。安定性、セキュリティー、パフォーマンス機能が向上しています。

インテル® オープン・イメージ・デノイズは、x86 および ARM 製 CPU (Windows*、Linux*、macOS* での ARM サポートを含む)、および インテル、NVIDIA、AMD、Apple 製の GPU など、すべてのプラットフォームでマルチベンダーのノイズ除去を完全にサポートします。

関連情報

- インテル® コンパイラーが初めて SYCL* 2020 準拠を達成 (英語)

- 2024.1 リリースに関する開発者の見解 (英語)

- Codeplay の oneAPI プラグインをダウンロード: NVIDIA* GPU 用 (英語) | AMD* GPU 用 (英語)

脚注

パフォーマンス指標: 第 5 世代インテル® Xeon® スケーラブル・プロセッサー (英語)

2 「ソフトウェア AI アクセラレーターで最大 100 倍のパフォーマンス向上を実現」

インテル® Gaudi®2 アクセラレーターとインテル® Xeon® プロセッサーは生成 AI に高度な推論パフォーマンスを提供

2024年3月27日 | インテル® デベロッパー・クラウド、MLCommons (英語)

インテル® Gaudi®2 アクセラレーターと第 5 世代インテル® Xeon® プロセッサーの最新の MLPerf* の結果は、インテルが生成 AI のパフォーマンスの水準を高めていることを示しています。

本日 MLCommons は、インテル® Gaudi®2 アクセラレーターとインテル® AMX をサポートする第 5 世代インテル® Xeon® スケーラブル・プロセッサーを含む、業界標準の推論ベンチマーク MLPerf* v4.0 の結果を発表しました。

インテル® Gaudi®2 アクセラレーターは、大規模言語モデル (LLM) およびマルチモーダル・モデルにおいて、NVIDIA* H100 に代わる唯一のベンチマーク対象製品として、総所有コストを評価する際に重要となる説得力のある価格/性能を提供します。CPU では、インテルは MLPerf の結果を提出した唯一のサーバー CPU ベンダーです (そして、インテル® Xeon® プロセッサーは多くのアクセラレーターのホスト CPU です)。

詳細と結果は、こちら (英語) を参照してください。

インテル® デベロッパー・クラウドで評価

インテル® デベロッパー・クラウドでは、小規模および大規模なトレーニング (LLM または生成 AI) や推論用のプロダクション・ワークロードの大規模な実行、AI コンピューティング・リソースの管理など、第 5 世代インテル® Xeon® プロセッサーおよびインテル® Gaudi®2 アクセラレーターを評価できます。こちらからサブスクリプション・オプションを確認し、アカウントにも申し込むことができます。

インテルが常時稼働の CPU パフォーマンス解析を自動化する Continuous Profiler ソリューションをオープンソース化

2024年3月11日 | インテル® Granulate™ Cloud Optimization Software (英語)

継続的かつ自律的な方法で実行時の効率を把握して、コードの最適化を簡素化

本日、インテルは、オープンソースの Continuous Profiler 最適化エージェントを公開しました。これは、イノベーションを促進し、開発者の生産性を向上する同社のオープン・エコシステム・アプローチの新たな一例です。

名前が示すように、Continuous Profiler は CPU 使用率を永続的に監視して、開発者、パフォーマンス・エンジニア、DevOps に、アプリケーションとワークロードのランタイムの非効率性を特定する常時稼働の自律的な方法を提供します。

仕組み

複数のサンプリング・プロファイラーを 1 つのフレームグラフに統合して、CPU が何に時間を費やしているか、特にコード内で高いレイテンシーやエラーが発生している場所を統一的に視覚化します。

使用すべき理由

Continuous Profiler は、チームがパフォーマンス・エラーを見つけて修正し、スムーズにデプロイできるよう支援する多数の独自機能を備えており、インテル® Granulate™ の継続的最適化サービスと互換性があり、数分でクラスター全体にデプロイでき、コードを変更することなくさまざまなプログラミング言語をサポートしています。

さらに、SOC2 認定 (英語) を受けており、インテルの高いセキュリティー基準に準拠しているため、導入における信頼性と信頼性が保証されます。Continuous Profiler は、Snap Inc. (Snapchat と Bitmoji)、ironSource (アプリ・ビジネス・プラットフォーム)、ShareChat (ソーシャル・ネットワーク・プラットフォーム) で採用されています。

プレスリリース (英語)

関連情報

- GitHub* から Continuous Profiler を入手 (英語)

- インテル® Granulate™ 継続的プロファイル (英語)

- インテル® Granulate™ のデモを申し込む (英語)

インテル® ソフトウェア開発ツール @KubeCon Europe 2024

2024年2月29日 | インテル® ソフトウェア開発ツール @ KubeCon Europe 2024 (英語)

インテルのエンタープライズ・ソフトウェア・ポートフォリオはエンタープライズ・アプリケーションで k8s スケーラビリティーを実現

インテルのエンタープライズ・ソフトウェア・ポートフォリオはエンタープライズ・アプリケーションで k8s スケーラビリティーを実現

KubeCon Europe 2024 (3月19日~22日) では、インテルのエンタープライズ・ソフトウェア・エキスパートから、デプロイメントの合理化と拡張、Kubernetes コストの削減、エンドツーエンドのデータ・セキュリティーを実現する方法を聞くことができます。

さらに、「Above the Clouds with American Airlines」 (英語) セッションに参加することで、世界トップクラスの航空会社がインテル® Granulate™ ソフトウェアを使用して、同社の最大のクラウドベースのワークロードで 23%のコスト削減を達成した方法を学ぶことができます。

インテルの K8s 向けエンタープライズ・ソフトウェアを採用する理由

インテルのエンタープライズ・ソフトウェア・ポートフォリオは、クラウドネイティブなアプリケーションとソリューションを効率良く大規模に高速化し、AI への道を素早く切り開くことを目的として構築されています。つまり、運用レベルの Kubernetes ワークロードを、管理しやすく、セキュアで、効率良くスケーリングする方法で実行できます。

次のようなメリットが得られます。

- 最適化されたパフォーマンスとコスト削減

- 合理化されたワークフローによる優れたモデル

- セキュアでコンプライアンスに準拠したコンフィデンシャル・コンピューティング

インテルのエンタープライズ・ソフトウェア・ソリューションの詳細は、ブース #J17 でご確認ください。

KubeCon EU 2024 でインテルについて知ろう (英語) →

関連情報

- イベントの詳細と登録 (英語)

- イベントのスケジュール (英語)

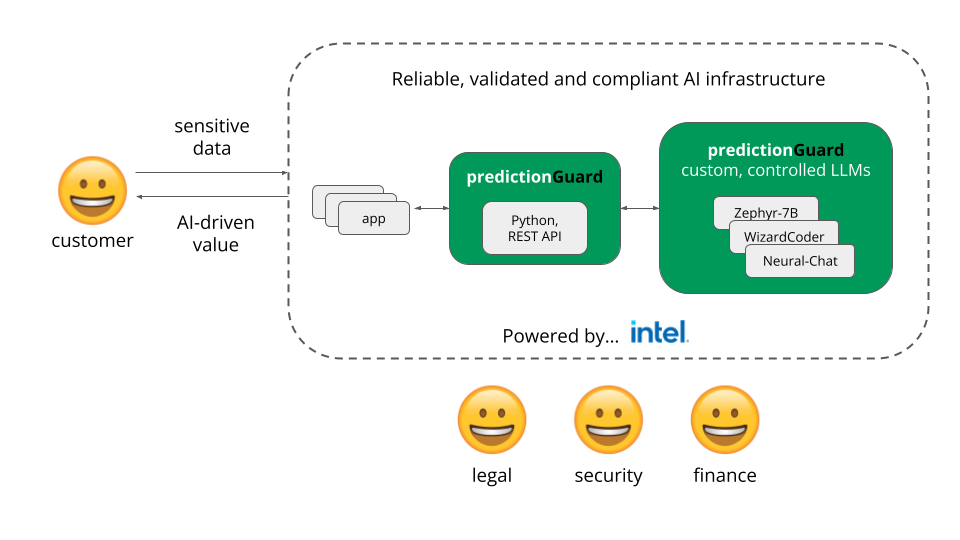

Prediction Guard はインテル® デベロッパー・クラウドにより LLM の信頼性とセキュリティーを顧客に提供

2024年2月22日 | インテル® デベロッパー・クラウド

AI スタートアップの Prediction Guard (英語) は、インテル® デベロッパー・クラウドのセキュアでプライベートな環境で LLM API をホスティングしており、インテルの回復機能を備えたコンピューティング・リソースを活用して、顧客の生成 AI アプリケーション向けにクラウド運用で最高のパフォーマンスと一貫性を提供しています。

AI スタートアップの Prediction Guard (英語) は、インテル® デベロッパー・クラウドのセキュアでプライベートな環境で LLM API をホスティングしており、インテルの回復機能を備えたコンピューティング・リソースを活用して、顧客の生成 AI アプリケーション向けにクラウド運用で最高のパフォーマンスと一貫性を提供しています。

同社の AI プラットフォームは、幻覚、有害な出力、プロンプトの注入などのセキュリティーと信頼性の問題を軽減しながら、企業が大規模な言語モデルの可能性を最大限に活用できるようにします。

インテル® デベロッパー・クラウドに移行することで、Prediction Guard は顧客に信頼性の高いコンピューティング能力と、最新の AI ハードウェア・アクセラレーション、ライブラリー、およびフレームワークを提供しています。同社は現在、インテル® Gaudi®2 AI アクセラレーター、インテルと Hugging Face が協力して提供している Optimum Habana ライブラリー、PyTorch* 向けインテル® エクステンション、および Transformer を利用しています。

「一部のモデルでは、インテル® Gaudi®2 への移行により、スループットを 2 倍向上する一方でコスト削減を実現しました。」

Prediction Guard

創設者

Daniel Whitenack 氏

関連情報

Prediction Guard は、初期段階の AI やマシンラーニングなどのスタートアップ企業によるイノベーションとスケールアップを支援する、インテル® Liftoff 無料プログラムに参加しています。

新しい調査で 2024年のクラウド最適化の現状が明らかに

2024年2月20日 | インテル® Granulate™ ソフトウェア (英語)

インテル® Granulate™ クラウド最適化チームが実施し、新たに発表されたグローバル調査では、さまざまな業界にわたる 413 組織の DevOps、データ・エンジニアリング、IT リーダーのクラウド・コンピューティングにおける主要な傾向と戦略が評価されました。

調査結果から、大多数の組織 (66% 以上) にとって優先事項の 1 位と 2 位は、クラウドのコスト削減とアプリケーション・パフォーマンスの向上であることが明らかになりましたが、54% にはクラウドベースのワークロード最適化を専門とするチームがありません。

レポートでは、次のような傾向についても詳しく説明しています。

- クラウド最適化の優先順位と目標

- 現在の最適化の取り組みの評価

- 最もコストが高く、最適化が困難なクラウドベースのワークロード

- 技術スタックで使用される最適化ツール

- 2024年に向けたイノベーション

レポートをダウンロードする (英語) →

デモを申し込む (英語) →

アメリカン航空がインテル® Granulate™ によりクラウド・ワークロードのコストを 23% 削減

2024年1月29日 | インテル® Granulate™ Cloud Optimization Software (英語)

アメリカン航空 (AA) はインテル® Granulate™ を利用して、Databricks データレイクに保存されている最も困難なワークロードを最適化し、維持することが難しいデータ管理価格の課題を軽減しました。

コード変更や開発作業を必要とせずに自律的かつ継続的な最適化を実現するインテル® Granulate™ ソリューションを導入することで、AA のエンジニアリング・チームは最適なペースと規模でデータを処理および分析し、ジョブクラスター実行にかかるリソースの 37% 削減と、すべてのクラスターコストの 23% 削減を実現しました。

ケース・スタディーを読む (英語) →

デモを申し込む (英語) →

Intel、インテル、Intel ロゴ、その他のインテルの名称やロゴは、Intel Corporation またはその子会社の商標です。

インテル® SHMEM がオープンソースをリリース

2024年1月10日 | インテル® SHMEM (英語) [GitHub]

インテル® SHMEM オープンソース・ライブラリーの最初のバージョン 1.0.0 は、OpenSHMEM (英語) プログラミング・モデルを拡張し、SYCL* クロスプラットフォーム C++ プログラミング環境を使用してインテル® データセンター GPU をサポートします。

OpenSHMEM (SHared MEMory) は、分散メモリーシステムの SPMD (Single Program Multiple Data) プログラミングを可能にする並列プログラミング・ライブラリー・インターフェイス標準です。これにより、ユーザーはスーパーコンピューターやクラスター・コンピューター間でプログラムの多数のコピーを実行する単一のプログラムを作成できます。

インテル® SHMEM は、アプリケーションが SYCL* で実装されたデバイスカーネルで OpenSHMEM 通信 API を使用できるようにする C++ ライブラリーです。PGAS (Partitioned Global Address Space) プログラミング・モデルを実装しており、現在の OpenSHMEM 標準のホスト起動型操作のサブセットと、GPU カーネルから直接呼び出せる新しいデバイス起動型操作が含まれています。

主な機能

- インテル® データセンター GPU マックス・シリーズのサポート

- OpenSHMEM 1.5 準拠のポイントツーポイント RMA、アトミックメモリー、シグナリング、メモリー順序付け、および同期操作に対するデバイスおよびホスト API のサポート

- OpenSHMEM 集合操作におけるデバイスおよびホスト API のサポート

- リモート・メモリー・アクセス、シグナリング、集合、メモリー順序付け、および同期操作の SYCL* ワークグループおよびサブグループ・レベルの拡張機能に対するデバイス API サポート

- OpenSHMEM 仕様の C11 汎用選択ルーチンを置き換える C++ テンプレート関数ルーチンのサポート

- 高性能ネットワーク・サービスに適した Libfabric プロバイダーと Sandia OpenSHMEM で構成された場合の GPU RDMA サポート

- SHMEM Symmetric Heap にデバイスメモリーまたは USM を選択可能

詳細 (英語)

(インテルの 3 人のシニア・ソフトウェア・エンジニアによるブログ)

関連情報

- 完全なインテル® SHMEM 仕様 (英語)

- OpenSHMEM 標準 (英語) [PDF]

2023年

Codeplay の oneAPI for NVIDIA* GPU プラグインのアップデート

2023年12月23日

oneAPI と AI ツールで構成されるインテル® ソフトウェア開発ツールの最新バージョン 2024.0.1 には、Codeplay の oneAPI for NVIDIA* GPU プラグインへの注目すべき追加と改善が含まれています。

主な機能:

- バインドレス・イメージ – 現在の SYCL* 2020 のイメージ API を大幅に見直した SYCL* 拡張です。

- ユーザーは、メモリーとイメージをより柔軟に管理できます。

- ミップマップなどのさまざまなイメージタイプのハードウェア・サンプリングとフェッチ機能、およびサブ領域コピーなどのイメージをコピーする新しい方法を利用できます。

- Vulkan* などの外部グラフィックス API との相互運用性機能と、Blender と統合するための画像操作の柔軟性を提供します。

- SYCL* サポート

- 不均一グループ – 開発者は、ワークグループまたはサブグループ内の作業項目の一部のサブセット全体で同期操作を実行できます。

- ピアツーピア・アクセス – マルチ GPU システムでは、これにより、デバイス間のメモリー・アクセス・レイテンシーが短縮されたり、帯域幅が向上する可能性があります。

- SYCL-Graph の実験版 – 開発者が GPU に送信する操作を事前に定義できるため、パフォーマンスが向上し、時間を節約できます。

さらに、AMD プラグインは引き続きベータ版が提供されており、2024年に製品版がリリースされる予定です。

プラグインを入手

- oneAPI for NVIDIA* GPU (英語)

- oneAPI for AMD* GPU (英語)

- オープンソース・レポジトリー

http://github.com/intel/llvm/tree/sycl/sycl/plugins/unified_runtime/ur/adapters

関連情報

インテルの最新の AI アクセラレーション CPU + 2024.0 ソフトウェア開発ツール = 大規模なイノベーション

2023年12月14日 | AI Everywhere 基調講演、インテル® ソフトウェア開発ツール 2024.0

データセンター、クラウド、エッジにわたる AI ワークロードのパワーアップと最適化

本日、インテルの最新の AI アクセラレーション・プラットフォーム、第 5 世代インテル® Xeon® スケーラブル・プロセッサー (開発コード名 Emerald Rapids) とインテル® Core™ Ultra プロセッサー (開発コード名 Meteor Lake) が正式に発表されました。今朝、ニューヨークの Nasdaq で開催された「AI Everywhere」イベントで、インテル CEOのパット・ゲルシンガー (Pat Gelsinger) が発表したこれらのシステムは、開発者やデータ・サイエンティストに大規模な AI イノベーションを加速するための柔軟性と選択肢を提供します。

また、新たにリリースされたインテル® ソフトウェア開発ツール 2024.0 は、これらのプラットフォームをターゲットとするアプリケーションやソリューションをサポートする準備が整っています。

以下はその一部です。

第 5 世代インテル® Xeon® スケーラブル・プロセッサーに対応

第 5 世代インテル® Xeon® スケーラブル・プロセッサーは、第 4 世代インテル® Xeon® プラットフォームの進化版であり、AI、データベース、ネットワーク、HPC において、ワットあたりの優れた性能に加え、卓越したパフォーマンスと TCO を実現します。

インテルの 2024.0 リリースは、oneAPI により最適化されたツール、ライブラリー、AI フレームワークを提供し、開発者は第 4 世代および第 5 世代インテル® Xeon® スケーラブル・プロセッサー、およびインテル® Xeon® CPU マックス・シリーズの高度な機能を活用することで、アプリケーション・パフォーマンスを最大限に引き出すことができます。

- インテル® アドバンスト・マトリクス・エクステンション (インテル® AMX) 内蔵 AI アクセラレーター

- インテル® クイックアシスト・テクノロジー (インテル® QAT) 搭載ワークロード・アクセレーター

- 高帯域幅、低レイテンシーのデータ移動を実現するインテル® データ・ストリーミング・アクセラレーター (インテル® DSA)

- インテル® In-Memory Analytics Accelerator (インテル® IAA) による非常に高いスループットの圧縮/展開とプリミティブ分析機能

第 4 世代および第 5 世代インテル® Xeon® スケーラブル・プロセッサーと

インテル® マックス・シリーズ製品ファミリー向けソフトウェア・ツール (英語)

インテル® Core™ Ultra プロセッサーに対応

CPU、GPU、NPU (ニューラル・プロセシング・ユニット) を搭載したこのプラットフォームは、新しい Intel 4 プロセス上に構築されており、電力効率とパフォーマンスの最適なバランス、没入型体験、ゲーム、コンテンツ制作、生産性向けの専用 AI アクセラレーションを提供します。

インテルの 2024.0 リリースは、ISV、開発者、プロのコンテンツ制作者が、次のような新しいプラットフォームの最先端の機能を利用して、ゲーム、コンテンツ制作、AI、メディア・アプリケーションを最適化するのに役立ちます。

- インテル® AVX-512

- インテル® AI ブーストおよび推論アクセラレーション

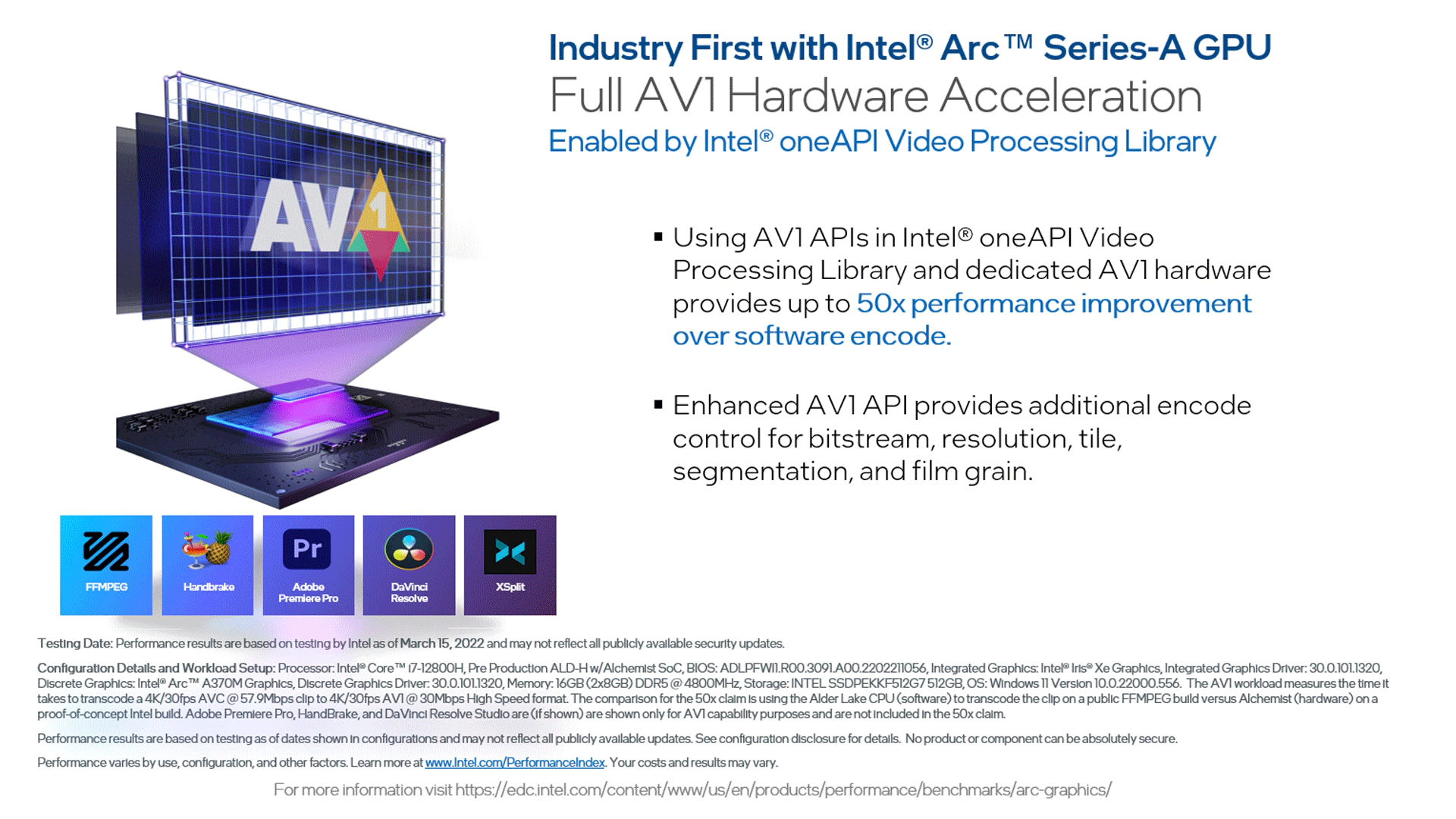

- AV1 エンコード/デコード

- レイトレース・ハードウェア・アクセラレーション

インテル® Core™ Ultra プロセッサー向けソフトウェア・ツール (英語)

関連情報

- 基調講演のビデオ

- プレスリリース

- 新しいクイック・スタート・ガイド: PyTorch* と TensorFlow* の最適化、および OpenVINO™ ツールキットを使用したインテル® AMX による AI アクセラレーション (英語)

インテル® ソフトウェア開発ツールのバージョン 2024 リリース

2023年11月20日 | インテル® ソフトウェア開発ツール

AI および HPC 向けのマルチアーキテクチャーのパフォーマンス、移植性、生産性を拡大

インテル® ソフトウェア開発ツールの最新バージョン 2024 がリリースされ、拡張されたマルチアーキテクチャー機能により、開発者はインテルの CPU、GPU、AI アクセラレーターで AI、HPC、レンダリングのワークロードを高速化および最適化できるようになりました。Powered by oneAPI (現在は Unified Acceleration Foundation が推進) のツールは、オープンスタンダードに基づき、C++、OpenMP*、SYCL*、Fortran、MPI、および Python* を幅広くカバーしています。

5 つの主なメリット

(ほかのメリットについては、こちらのページ (英語) またはブログ記事 (英語) を参照してください。)

- 将来に対応したプログラミング – Python*、Modin、XGBoost、レンダリングのサポートを含む最新のインテル® GPU でのパフォーマンスの高速化、今後登場する第 5 世代インテル® Xeon® スケーラブル CPU とインテル® Core™ Ultra CPU のサポート、複数のツールで広範な標準に対応したことによる AI と HPC 機能の拡張。

- AI アクセラレーション – インテルにより最適化された PyTorch* および TensorFlow* フレームワークによるネイティブサポートと、Python* のデータ並列拡張機能の改善により、インテルの CPU および GPU で AI およびマシンラーニングを高速化。

- ベクトル演算の最適化 – oneMKL は、x86 CPU およびインテルの GPU 上の HPC シミュレーション、統計サンプリング、その他の分野向けに、ターゲットデバイスで RNG オフロードを統合し、インテルの GPU 上で FP16 データ型をサポート。

- 拡張された CUDA* から SYCL* への移行 – インテル® DPC++ 互換性ツール (オープンソースの SYCLomatic ベース) に CUDA* ライブラリー API と、AI、ディープラーニング、暗号化、科学シミュレーション、画像処理などの分野の 20 の一般的なアプリケーションを追加。

- 高度なプレビュー機能 – GPU オフロードを容易にする C++ Parallel STL、計算ノードのリソース使用量を最適化する動的デバイス選択、GPU オフロードのオーバーヘッドを軽減する SYCL* グラフ、インテル® oneTBB と OpenMP* 間のスレッド・オーバーサブスクリプションを防ぐスレッド・コンポーザビリティーを含む。

インテルの CPU と GPU + oneAPI の可能性

- ATLAS Experiment (https://atlas.cern/Discover/Detector/Software-Computing/Intel-Case-Study) は、インテルと NVIDIA* GPU 上での SYCL* と CUDA* コードのベンチマークを含む、インテル® ソフトウェア開発ツールにより最適化されたヘテロジニアス粒子再構成をインテル® GPU 上で実装することで、パフォーマンス向上を達成しました。

- oneAPI の STAC-A2 ベンチマーク実装 (英語) がインテル® GPU と NVIDIA* GPU の比較で記録を更新しました。

- VMware とインテルが共同で検証した AI スタック (英語) により、どこでもプライベート AI を利用して、モデルの開発と展開を行うことができます。

インテルの oneAPI ソフトウェア・ツールとライブラリーが HPCwire Reader's Choice Award を受賞

2023年11月13日

|

素晴らしいニュースです! 2023 年の HPCwire Readers' and Editors' Choice Awards が発表され、インテルの oneAPI ソフトウェア開発ツールとライブラリーが、Best HPC Programming Tool or Technology (英語) を受賞しました。開発者と HPC エキスパートが新たなレベルの HPC と AI イノベーションを推進する中、彼らの投票によるこの栄誉は、オープンで標準ベースのマルチアーキテクチャー・プログラミングの重要性を証明するものです。oneAPI は、2020年以降、毎年 Editors' Choice Awards または Readers' Choice Awards を受賞しています。このような高い評価をいただいたことに感謝します。 |

インテル® デベロッパー・クラウドで AI ワークロードを高速化およびスケーリング

2023年9月20日 | インテル® デベロッパー・クラウド (英語)

開発者に最新のインテルの CPU、GPU、AI アクセラレーターへのアクセスを提供

Intel® Innovation 2023 で発表されたインテル® デベロッパー・クラウドが一般公開されました。このプラットフォームは、開発者、データ・サイエンティスト、研究者、組織に対して、最新の、場合によってはプレリリースのインテルのハードウェアとソフトウェア・サービスおよびツールに直接アクセスできる開発環境を提供します。これらはすべて、最新の技術機能に対応した製品とソリューションを開発、テスト、最適化し、迅速に市場に投入するのに役立ちます。

無償版と有償サブスクリプションが用意されています。

ハードウェアとソフトウェアの現在のラインナップは以下のとおりです。

- ハードウェア

- 第 4 世代インテル® Xeon® スケーラブル・プロセッサー (シングルノード、マルチアーキテクチャー・プラットフォーム、クラスター)

- インテル® Xeon® CPU マックス・シリーズ (高帯域幅メモリーのワークロード向け)

- インテル® データセンター GPU マックス・シリーズ (最も厳しい計算要件のワークロード向け)

- Habana® Gaudi®2 AI アクセラレーター (ディープラーニング・タスク向け)

- ソフトウェアとサービス

- 小規模および大規模の AI トレーニング、モデル最適化、および推論ワークロード (Meta AI Llama 2、Databricks Dolly など)

- 小規模から大規模の VM、フルシステム、クラスターを活用

- ソフトウェア・ツール (インテル® oneAPI ベース・ツールキット、インテル® oneAPI HPC ツールキット、インテル® oneAPI レンダリング・ツールキットなど)、インテル® Quantum SDK、AI ツールと最適化されたフレームワーク (インテル® OpenVINO™ ツールキット、インテルにより最適化された TensorFlow* および PyTorch*、インテル® ニューラル・コンプレッサー、インテル® ディストリビューションの Python* など) へのアクセス

今後さらに追加予定

今すぐ申し込む (英語)

Intel、インテル、Intel ロゴ、その他のインテルの名称やロゴは、Intel Corporation またはその子会社の商標です。

Intel® Innovation 2023 の概要

2023年9月20日 | Intel® Innovation (英語)

2 日間にわたるインテルの開発者イベントには 2,000 人近くの参加者が集まり、ハードウェア、ソフトウェア、サービス、先進テクノロジーにわたる AI の最新のブレークスルーに注目した豊富なセッション (インテル コーポレーション CEO の Pat Gelsinger をはじめインテルのリーダーや業界の著名人による基調講演、ハンズオンラボ、技術的洞察パネル、トレーニングなど) が実施されました。

多くの発表がありました。そのうち 6 つを以下に示します。

「Siliconomy (シリコノミー)」。Pat Gelsinger は冒頭でこの言葉を紹介し、「AI は世代交代の象徴であり、世界経済が成長する新たな時代の到来を告げるものです。そして、すべての人々のよりよい未来にとって、コンピューティングを一層、なくてはならないものにします。」と述べました。

Pat Gelsinger による Siliconomy 論説 (英語) [PDF]インテル® デベロッパー・クラウドの一般提供。開発者は、インテルの最新のハードウェアとソフトウェアへのアクセスを提供するこの開発環境 (無償版と有償版があります) を活用して、AI や HPC 向けのアプリケーションとワークロードの開発、テスト、最適化、デプロイを行うことができます。第 4 世代インテル® Xeon® スケーラブル・プロセッサー、インテル® Xeon® プロセッサー・マックス・シリーズ、インテル® データセンター GPU マックス・シリーズ、Habana® Gaudi®2 AI アクセラレーター、インテル® oneAPI ツール、インテルにより最適化された AI ツールとフレームワーク、SaaS (Hugging Face BLOOM、Meta AI Llama 2、Databricks Dolly など) を含む、幅広いハードウェアとソフトウェア・ツールおよびサービスを利用できます。

インテル® デベロッパー・クラウドの詳細 (英語)インテルが Unified Acceleration (UXL) Foundation に加盟しました。oneAPI オープン・プログラミング・モデルの進化版として、Linux Foundation は、クロスプラットフォーム・アプリケーションの開発を簡素化するオープン・スタンダードなアクセラレーター・プログラミング・モデルに関する業界横断的な協力体制を確立するため、UXL Foundation を設立しました。

インテル コーポレーションのデベロッパー・ソフトウェア・エンジニアリング・マネージャーである Sanjiv Shah のブログ (英語) と Codeplay のエコシステム担当副社長である Rod Burns のブログ (http://codeplay.com/portal/news/2023/09/19/announcing-the-unified-acceleration-uxl-foundation) を読むIntel® Certified Developer – MLOps プロフェッショナル。MLOps のエキスパートが指導するこの新しい認定プログラムでは、自己学習モジュール、ハンズオンラボ、実習を使用して、コンピューティングを意識した AI ソリューション設計により AI パイプライン全体のパフォーマンスを最大化する方法を学ぶことができます。

プログラムの詳細 (英語)Intel® Trust Authority。この信頼とセキュリティー・サービスのスイートは、複数のクラウド、エッジ、オンプレミス環境などのプラットフォーム上でアプリケーションとデータが保護されていることを保証します。

Intel® Trust Authority の詳細 (英語) | 30 日間無償評価版 (英語)新しいエンタープライズ・ソフトウェアとサービスのポートフォリオ。シリコンベースのセキュリティーが組み込まれたスケーラブルで持続可能な技術スタックを提供することで、企業の最大の課題を解決するように設計されています。

セキュリティーを簡素化する製品 (英語) [Intel® Trust Authority]、投資対効果を高めるエンタープライズ AI を実現する製品 (英語) [インテル® デベロッパー・クラウド + Cnvrg.io]、およびリアルタイムの自律的ワークロード最適化によりアプリケーション・パフォーマンスを向上する製品 (英語) [Intel® Granulate] を含みます。

関連情報:

Intel、インテル、Intel ロゴ、その他のインテルの名称やロゴは、Intel Corporation またはその子会社の商標です。

Unified Acceleration Foundation によりオープンな高速計算とクロスプラットフォーム・パフォーマンスを推進

2023年9月19日 | Unified Acceleration Foundation (英語)

本日、Linux Foundation は、ハイパフォーマンスのクロスプラットフォーム・アプリケーションの開発を簡素化する、オープンスタンダードのアクセラレーター・プログラミング・モデルの提供に取り組む業界横断的なグループである Unified Acceleration (UXL) Foundation の設立を発表しました。

oneAPI イニシアチブの進化である UXL Foundation は、イノベーションを推進し、業界全体で oneAPI 仕様を実装する次の重要なステップを示します。Arm、富士通、Google Cloud、Imagination Technologies、インテル、Qualcomm Technologies, Inc.、Samsung などの業界をリードする組織およびパートナーが、オープンソースのコラボレーションと、クロスアーキテクチャーの統一プログラミング・モデルの開発を促進するために結集しました。

「Unified Acceleration Foundation は、コラボレーションの力とオープンソース・アプローチを体現しています。主要なテクノロジー企業が団結し、クロスプラットフォーム開発のエコシステムを促進することで、データ中心のソリューションのパフォーマンスと生産性における新たな可能性を解き放ちます。」

関連情報

- 私たちの子供が大学を卒業します! (英語) – インテル コーポレーション ソフトウェア開発製品事業本部長 Sanjiv Shah

- Unified Acceleration (UXL) Foundation の発表 (英語) – Codeplay Software エコシステム担当副社長 Rod Burns

生産性を高めるプリセットの AI ツールバンドル

2023年8月21日 | ベータ版 AI ツールセレクター (英語)

新しい柔軟な AI ツール・インストール・サービスで必要なツールを選択

ディープラーニング・フレームワーク、ツール、ライブラリーの合理化されたパッケージ・インストールを支援する、インテルのベータ版 AI ツールセレクターが公開されました。データ・アナリティクス、古典的なマシンラーニング、ディープラーニング、推論最適化などの用途に合わせて、個別に、またはプリセットのバンドルをインストールできます。

以下のツールに対応しています。

- ディープラーニング・フレームワーク

- TensorFlow* 向けインテル® エクステンション

- PyTorch* 向けインテル® エクステンション

- ツールとライブラリー

- XGBoost 向けインテル® オプティマイゼーション

- scikit-learn* 向けインテル® オプティマイゼーション

- Modin 向けインテル® ディストリビューション

- インテル® ニューラル・コンプレッサー

- SDK とコマンドライン・インターフェイス (CLI):

- cnvrg Python* SDK V2 (英語)

上記はすべて conda、pip、または Docker* パッケージ・マネージャーから入手できます。

あらゆる場所で AI を進化させる: インテルが PyTorch Foundation に加盟

2023年8月10日 | インテルの PyTorch* 最適化 (英語)

インテルは、PyTorch* の開発と民主化を加速させるため、PyTorch Foundation の Premier メンバーとなり、運営委員会の一員となりました。

PyTorch Foundation のウェブサイトでは、当財団について次のように記載されています。

「PyTorch Foundation は、ディープラーニング・コミュニティーがオープンソースの PyTorch* フレームワークとエコシステムに関して協力する中立的な拠点です。PyTorch* を使ったオープンソースでベンダーニュートラルなプロジェクトのエコシステムを育成し維持することで、AI とディープラーニング・ツールの採用を促進することを使命としています。」

これはインテルの目指すところと一致しています。インテルは 2018年から、ユビキタス・ハードウェアとオープン・ソフトウェアを通じて AI へのアクセスを民主化するというビジョンの下、PyTorch* フレームワークに貢献しています。一例として、最新のインテルによる PyTorch* の最適化と機能は、stock PyTorch* にアップストリームされる前に、PyTorch* 向けインテル® エクステンションで定期的にリリースされています。これにより、データ・サイエンティストやソフトウェア・エンジニアはアップストリーム前の拡張機能を利用して競争力を高め、最新のハードウェア・テクノロジーを活用した AI アプリケーションを開発することが可能です。

詳細 (英語)

PyTorch* 向けインテル® エクステンションのダウンロード (英語)

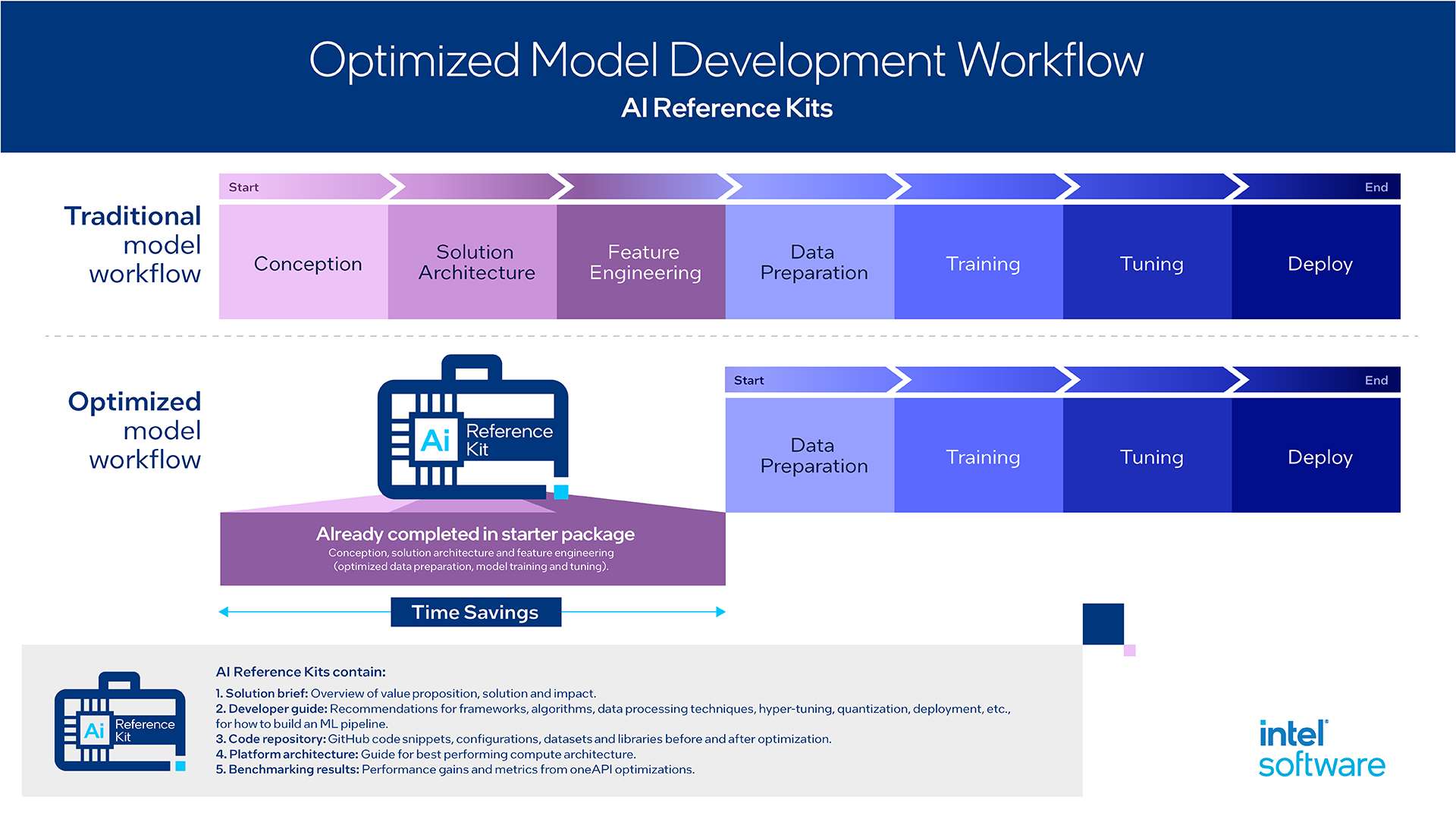

インテル/Accenture の AI リファレンス・キットで実証されたパフォーマンスの向上

2023年7月24日 | AI リファレンス・キット (英語)

AI 開発を簡素化する事前設定済みキット

以前にも取り上げた AI リファレンス・キットは、コンシューマー製品、エネルギー/公共事業、金融サービス、ヘルスケア/ライフサイエンス、製造、小売、電気通信分野の AI ワークロード向けの無料のドロップイン・ソリューションであり、全部で 34 種類あります。

AI リファレンス・キットに含まれるコードと機能を利用することで、複数の業界が目に見えるメリットを実感しています。

以下はその一例です。

- エンタープライズ向け会話型 AI チャットボットとの対話をセットアップする AI リファレンス・キットを使用することで、oneAPI の最適化によりバッチモードの推論が最大 45% 高速になりました。

https://github.com/oneapi-src/customer-chatbot - ライフサイエンス向けの視覚的品質管理検査を自動化する AI リファレンス・キットを使用することで、oneAPI の最適化により視覚的欠陥検出のトレーニングが最大 20% 高速化され、推論が 55% 高速化されました。

https://github.com/oneapi-src/visual-quality-inspection

公共設備の健全性を予測し、より高いサービスの信頼性を提供するため、予測精度を最大 25% 向上できる AI リファレンス・キットもあります。詳細 → (英語)

記事全文を見る → (英語)

AI リファレンス・キットの詳細 → (英語)

AI リファレンス・キットをダウンロード → (英語)

インテル® oneAPI ツール 2023.2 リリース

2023年7月20日 | インテル® oneAPI ツール

オープンなマルチアーキテクチャー・コンピューティング向けのソフトウェア開発ツールをさらに拡張 & 強化

インテル® oneAPI ツール 2023.2 は、マルチアーキテクチャー・ソフトウェア開発の自由度を Python* にもたらし、CUDA* からオープンな SYCL* への移行を簡素化し、最新の GPU および CPU ハードウェアでパフォーマンスを向上します。

詳細 (英語)

バージョン 2023.2 の主な機能

マルチアーキテクチャー対応のインテル® oneAPI にまだアップデートしていない場合、またはまだ試していない場合、本リリースでアップデートする 5 つのメリットがあります。

- CUDA* から優れたパフォーマンスの SYCL* への移行を簡素化 – AI、ディープラーニング、暗号化、科学シミュレーション、画像処理などの一般的なアプリケーションで、CUDA* から SYCL* へ容易に移行できます。新しいリリースでは、追加の CUDA* API、CUDA* の最新バージョン、FP64 がサポートされ、移行範囲が広がりました。

- より高速で高精度な AI 推論 – 推論時の NaN (Not a Number) 値のサポートにより、前処理が効率化され、不完全なデータでトレーニングしたモデルの予測精度が向上します。

- GPU での AI ベースの画像補正の高速化 – インテル® オープン・イメージ・デノイズ・レイトレーシング・ライブラリーは、インテルや他のベンダーの GPU をサポートし、高速で忠実度の高い AI ベースの画像補正を実現するハードウェアの選択肢を提供します。

- AI および HPC 向けの Python* の高速化 – このリリースでは、ベータ版の Data Parallel Extensions for Python* が導入され、NumPy* および cuPy* 関数で Python* の数値計算機能が GPU に拡張されています。

- 効率良い並列コードを記述するための合理化 – インテル® Fortran コンパイラーが DO CONCURRENT リダクションをサポートしました。この強力な機能は、コンパイラーがループを並列に実行できるようにし、コードのパフォーマンスを大幅に向上させるとともに、効率良く正しい並列コードの記述を容易にします。

各ツールの主な機能

コンパイラーと SYCL* サポート

- インテル® oneAPI DPC++/C++ コンパイラーは、即時コマンドリスト機能をデフォルトとして設定します。これは、インテル® データセンター GPU マックス・シリーズへの計算のオフロードを検討している開発者に役立ちます。

- インテル® oneAPI DPC++ ライブラリー (インテル® oneDPL) (英語) は、インテル® GPU で実行する C++ STD ライブラリーのソートおよびスキャン・アルゴリズムのパフォーマンスを向上します。これにより、C++ アプリケーションで一般的に使用されるアルゴリズムが高速化されます。

- インテル® DPC++ 互換性ツール (インテル® DPCT) (英語) は、オープンソースの SYCLomatic プロジェクトをベースとしており、CUDA* 12.1 とさらに多くの関数呼び出しをサポートし、AI、暗号化、科学シミュレーション、画像処理など多数のドメインで CUDA* から SYCL* への移行を合理化し、移行したコードに FP64 認識を追加して、FP64 ハードウェアのサポートの有無にかかわらず、インテル® GPU 間での移植性を確保します。

- インテル® Fortran コンパイラーは、リダクション・コードのパフォーマンスを大幅に向上し、効率良い並列コードの作成を容易にする DO CONCURRENT リダクションをサポートしました。

AI フレームワークとライブラリー

- インテル® ディストリビューションの Python* は、CPU プログラミング・モデルを GPU に拡張し、NumPy* と CuPy* で CPU と GPU を利用してパフォーマンスを向上するベータ版 Parallel Extensions for Python を導入しました。

- インテル® oneAPI ディープ・ニューラル・ネットワーク・ライブラリー (インテル® oneDNN) (英語) は、AI ワークロードのトレーニングと推論の高速化、より簡単なデバッグと診断、グラフ・ニューラル・ネットワーク (GNN) 処理のサポート、および第 4 世代インテル® Xeon® スケーラブル プロセッサーやインテルおよびその他のベンダーの GPU など、多数のプロセッサーでのパフォーマンスの向上をもたらします。

- インテル® oneAPI データ・アナリティクス・ライブラリー (インテル® oneDAL) の Model Builder 機能は、推論中に NaN サポートの欠損値を追加し、前処理を合理化し、不完全なデータでトレーニングされたモデルの予測精度を高めます。

パフォーマンス・ライブラリー

- インテル® oneAPI マス・カーネル・ライブラリー (インテル® oneMKL) は、インテル® データセンター GPU マックス・シリーズおよびフレックス・シリーズのプロセッサーでカーネルの起動時間を大幅に短縮し、GPU 用の LINPACK ベンチマークを導入しました。

- インテル® MPI ライブラリーは、第 4 世代インテル® Xeon® スケーラブル・プロセッサーおよびインテル® Xeon® CPU マックス・シリーズのメッセージ パッシング パフォーマンスを向上し、インテル® GPU に重要な最適化をもたらします。

- インテル® oneAPI スレッディング・ビルディング・ブロック (インテル® oneTBB) のアルゴリズムとフロー・グラフ・ノードは、新しいタイプのユーザー呼び出し可能オブジェクトへの対応により、より強力で柔軟なプログラミング環境を実現します。

- インテル® インテグレーテッド・パフォーマンス・プリミティブ Cryptography (インテル® IPP Cryptography) (英語) のマルチバッファー・ライブラリーは、SM4 アルゴリズムの XTS モードをサポートしました。これにより、ストレージデバイスなどのセクターに保管されたデータを効率良くセキュアに暗号化する方法が開発者に提供されます。

解析とデバッグ

- インテル® VTune™ プロファイラーは、GPU オフロードのタスクと実行に関する情報を提供し、インテル® GPU 上の BLAS レベル 3 ルーチンのアプリケーション・プロファイルを改善し、プラットフォーム図でインテル® データセンター GPU マックス・シリーズのデバイスを識別します。

- インテル® ディストリビューションの GDB (英語) は、最新の状態を維持し、効果的なアプリケーションのデバッグと共有ローカルメモリー (SLM) のデバッグをサポートする最新の機能拡張に合わせて、GDB 13 をベースとするように変更されました。

詳細

- インテル® oneAPI およびインテル® AI ツール

- SYCL* 初心者向け SYCL* 入門

- oneAPI トレーニング・ポータル – ラーニングパス、ツール、オンデマンド・トレーニングなど、情報を共有して紹介する機会を利用して、好みの方法で学習できます。

法務上の注意書き

Codeplay はインテルの子会社です。

性能は、使用状況、構成、その他の要因によって異なります。詳細については、http://www.intel.com/PerformanceIndex/ (英語) を参照してください。結果は異なることがあります。

性能の測定結果はシステム構成の日付時点のテストに基づいています。また、現在公開中のすべてのセキュリティー・アップデートが適用されているとは限りません。

絶対的なセキュリティーを提供できる製品またはコンポーネントはありません。実際の費用と結果は異なる場合があります。

インテルのテクノロジーを使用するには、対応したハードウェア、ソフトウェア、またはサービスの有効化が必要となる場合があります。

インテルは、サードパーティーのデータについて管理や監査を行っていません。ほかの情報も参考にして、正確かどうかを評価してください。

Blender* 3.6 LTS が インテル® GPU 上でインテル® Embree によるハードウェア・アクセラレーションのレイトレーシングを搭載

2023年6月29日 | インテル® Embree (英語)、Blender* 3.6 LTS (https://www.blender.org/download/releases/3-6/)

数々の賞を受賞したインテル® Embree が Blender* 3.6 LTS リリースに含まれました。インテルの高性能レイトレーシング・ライブラリーの追加により、コンテンツ制作者はインテル® Arc™ GPU、インテル® データセンター GPU フレックス・シリーズおよびマックス・シリーズ上で Cycles のハードウェア・アクセラレーションによるレンダリングを利用できるようになり、忠実度を損なうことなくレンダリング時間を大幅に短縮できます。

3.6 LTS には、インテル® オープン・イメージ・デノイズによる AI ベースのノイズ除去も含まれています。両ツールは、高性能で忠実度の高いビジュアル体験を作成するオープンソース・レンダリングおよびレイトレーシング・ライブラリーのセットである、インテル® oneAPI レンダリング・ツールキット (Render Kit) の一部です。

- ブログ (ベンチマークを含む)

http://game.intel.com/story/intel-arc-graphics-intel-embree-and-blender/ - デモ動画 [6:20] (英語)

- Blender 3.6 LTS のダウンロード (英語)

- Render Kit のダウンロード (英語)

UKAEA がインテルのハードウェアと oneAPI ソフトウェア・ツールを使用して核融合発電を実現

2023年6月29日 | インテル® oneAPI ツール

英国原子力公社 (UK Atomic Energy Authority、略称 UKAEA) と Cambridge Open Zettascale Lab は、インテル® ハードウェア、インテル® oneAPI ツール、および分散型非同期オブジェクト・ストレージ (DAOS) を使用して、英国における世界初の核融合発電所の設計、認証、建設、規制に必要な次世代エンジニアリング・ツールとプロセスを開発しています。これは、2040年代初頭までに商用核融合発電へのロードマップを加速するという英国の目標に沿ったものです。

UKAEA のチームは、スーパーコンピューティングと AI を使って核融合発電所を仮想的に設計しました。今後、チームは第 4 世代インテル® Xeon® プロセッサーや複数のベンダーの GPU、FPGA など、さまざまなアーキテクチャー上で多くの HPC ワークロードを実行する予定です。

これが重要な理由

複数のハードウェアに対して一度にプログラミングできることが重要です。oneAPI のオープンで標準ベースのマルチアーキテクチャ・プログラミングを使用することで、UKAEA チームはコードの移植性の課題を克服し、ベンダーに縛られないパフォーマンスと開発生産性を実現できます。

詳細

関連情報

新しい oneAPI Construction Kit オープンソース・プロジェクト

2023年6月5日

Codeplay はオープンで標準ベースの SYCL* プログラミングを新しいハードウェア、カスタム・ハードウェア、および専門ハードウェアに提供

Codeplay は、oneAPI エコシステムの最新の拡張として、SYCL* コードを HPC や AI 向けのカスタム・アーキテクチャー上で実行できるようにするオープンソース・プロジェクトを発表しました。

oneAPI Construction Kit には、RISC-V* ベクトル・プロセッサー向けのリファレンス実装が含まれていますが、さまざまなプロセッサーに適応させることができ、サポートされている豊富な SYCL* ライブラリーを簡単に利用できます。

カスタム・アーキテクチャーのユーザーにとっては、新しいカスタム言語を習得する必要がなく、SYCL* を使用して複数のアーキテクチャーで動作する単一のコードベースで、ハイパフォーマンスなアプリケーションを効率良く記述できるというメリットがあります。これは、移行作業やアーキテクチャーごとに異なるのコードベースの保守作業を軽減し、技術革新のための時間を増やすことを意味します。

oneAPI Construction Kit に含まれるもの

- 特殊な AI アクセラレーターなど、新しく革新的なハードウェアに oneAPI のサポートを提供するフレームワーク

- x86、ARM、および RISC-V* ターゲットのサポート

- ドキュメント

- リファレンス設計

- チュートリアル

- モジュラー・ソフトウェア・コンポーネント

関連情報と入手方法

- developer.codeplay.com (英語) から無料で入手可能

- デモ動画 [2:32] (英語)

- Codeplay 主席ソフトウェア・エンジニア Colin Davidson によるブログ

- ドキュメント (英語) を入手

インテルが oneAPI を利用して AI により高速化した HPC パフォーマンスを実現

2023年5月22日 | インテル® oneAPI ツール

ISC'23 のまとめ: 最も広範でオープンな HPC + AI ポートフォリオが、サイエンス向けのパフォーマンスと生成 AI を強化

International Super Computing 2023 (英語) のインテルによる基調講演では、CPU、GPU、AI アクセラレーター、oneAPI ソフトウェアの幅広い製品ポートフォリオに基づいて、マルチアーキテクチャー・プログラミングを容易にしてオープンなエコシステムを実現し、多様な HPC および AI ワークロードのパフォーマンスを高めるインテルの取り組みが強調されました。

以下は、基調講演の要点です。

ハードウェア:

- 独立系ソフトウェア・ベンダーである Ansys は、インテル® データセンター GPU マックス・シリーズが、AI により高速化された HPC アプリケーションにおいて、NVIDIA* H100 を 50% 上回るパフォーマンスを発揮し、さらに多様なワークロードにおいて H100 と比較して平均 30% のパフォーマンス向上が見られることを示しました。**

- Habana* Gaudi* 2 ディープラーニング・アクセラレーターは、DL トレーニングおよび推論において、NVIDIA* A100 よりも最大 2 倍高速な AI パフォーマンスを実現します。**

- インテル® Xeon® CPU (マックス・シリーズおよび第 4 世代を含む) は、帯域幅が制限された問題において、それぞれ AMD* Genoa よりも 65% の高速化を実現し、AMD* Milan よりも平均で 50% の高速化を実現します。**

ソフトウェア:

- 全世界の開発者の約 90% が、インテルが開発または最適化したソフトウェアの恩恵を受けているか、使用しています。

- oneAPI は、複数のハードウェア・プロバイダーの多様な CPU、GPU、FPGA、AI シリコン上で実証されており、シングルベンダーのアクセラレーション・プログラミング・モデルの課題に対処しています。

- 最新の oneAPI ツールの新機能 (OpenMP* GPU オフロード、OpenMP* と Fortran サポートの拡張、TensorFlow* と PyTorch* フレームワーク、AI ツールの最適化など) は、インテルの最先端の HPC および AI 向け CPU と GPU の能力を解き放ちます。

- ハードウェア・アクセラレーションによるリアルタイムのレイトレースされたサイエンティフィック・ビジュアライゼーションがインテル® GPUで利用可能になり、AI ベースのノイズ除去が数ミリ秒で完了するようになりました。

oneAPI SYCL* 標準実装は、NVIDIA* のネイティブシステム言語のパフォーマンスを上回ることが示されています。例えば、インテル® Xeon® データセンター GPU マックス・シリーズで実行された DPEcho SYCL* コードは、NVIDIA* H100 で実行された同じ CUDA* コードよりも 48% 高速でした。

インテルは、顧客やエンドユーザーが画期的な発見を迅速にできるよう支援する製品で、HPC および AI コミュニティーに貢献します。インテル® Xeon® CPU マックス・シリーズ、インテル® Xeon® データセンター GPU マックス・シリーズ、第 4 世代インテル® Xeon® スケーラブル・プロセッサー、Gaudi* 2 に及ぶ当社の製品ポートフォリオは、さまざまなワークロードで競合製品を凌駕し、優れた電力効率と総所有コスト、AI の大衆化、そして選択肢、オープン性、柔軟性を提供しています。

インテル コーポレーション

スーパーコンピュート・グループ VP 兼 GM

Jeff McVeigh

記事を読む (英語)

** 詳細は、プレスリリース、法務上の注意書き、システム構成を参照してください (英語)

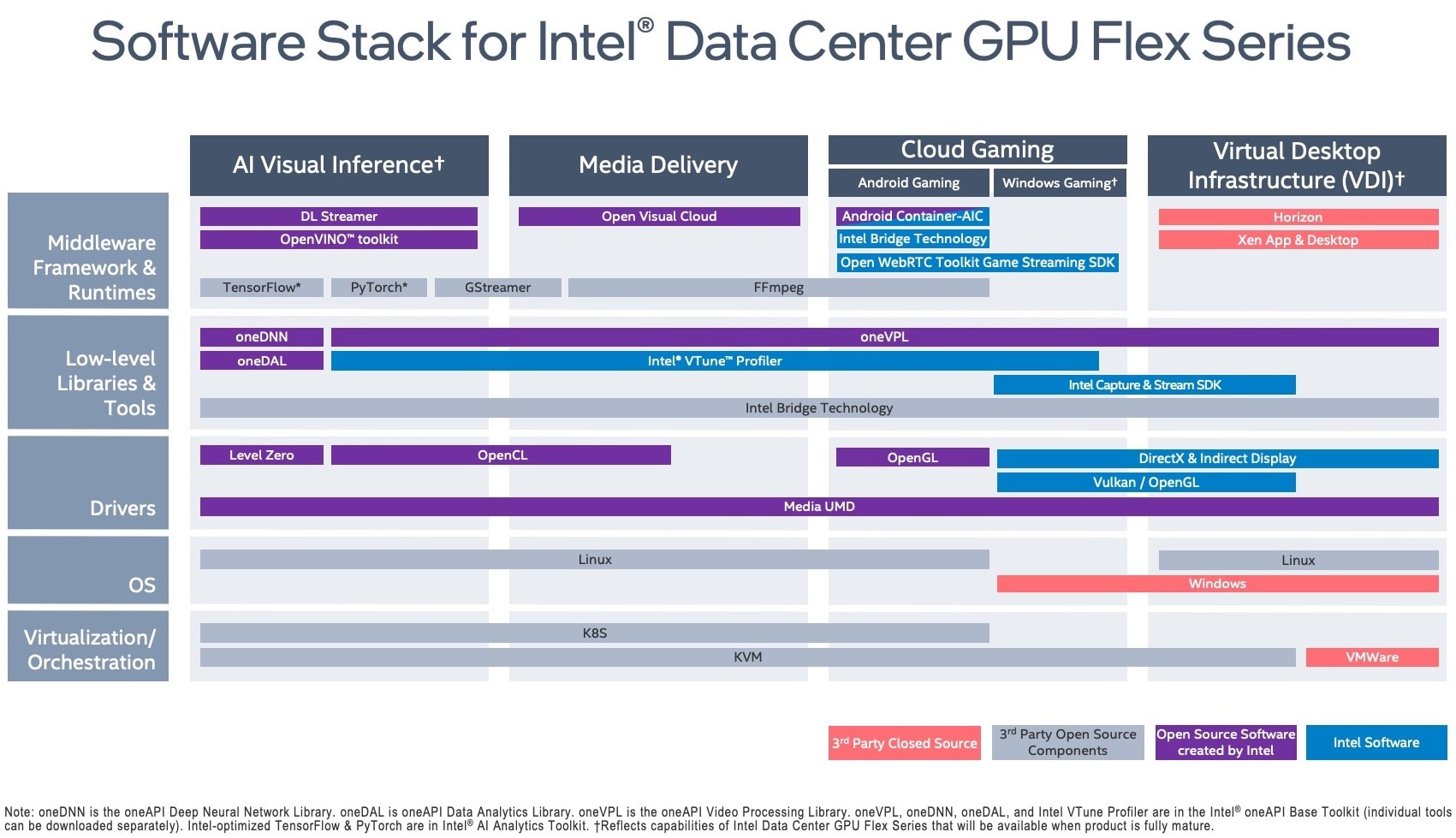

インテル® データセンター GPU フレックス・シリーズがオープン・ソフトウェア・スタックで拡張

2023年5月18日 | インテル® データセンター GPU フレックス・シリーズ向けソフトウェア (英語)

新しいソフトウェア・アップデートにより、クラウドゲーミング、AI 推論、メディア・アクセラレーション、デジタルコンテンツ作成のワークロードを最適化

データセンターおよびインテリジェント・ビジュアル・クラウド向けの柔軟な汎用 GPU として導入されたインテル® データセンター GPU フレックス・シリーズ (英語) が、クラウドゲーミング、AI 推論、メディア・アクセラレーション、デジタルコンテンツ作成などのワークロードを最適化する新しい製品レベルのソフトウェアで拡張されました。この GPU プラットフォームは、oneAPI (英語) により、オープンなフル・ソフトウェア・スタック、ライセンス料不要、CPU と GPU 向け統一プログラミング・モデルで、パフォーマンスと生産性を実現します。

新しいソフトウェア機能の概要

- Windows* クラウドゲーミング: 新しいリファレンス・スタックにより、GPU のパワーをリモートゲームに活用できます。

- AI 推論: スマートシティー、図書館のインデックス作成とコンプライアンス、AI によるビデオ強化、インテリジェント交通管理、スマートビルと工場、小売業に使用されるアプリケーションでディープラーニングと視覚推論を強化します。

- デジタルコンテンツ作成: 専用ハードウェア・アクセラレーションを活用したリアルタイム・レンダリングを実現し、AI ベースのノイズ除去を数ミリ秒で完了します。

- 自律走行: Unreal Engine* 4 を活用して、AD システムのトレーニングや検証を進めることができます。

オープン・ソフトウェア・スタックの構成要素、利用可能なツール、構成済みコンテナを使用した開始方法を学ぶことができます。

詳細 (英語)

新機能と問題の修正を含むインテル® AI アナリティクス・ツールキット 2023.1.1 リリース

2023年5月3日 | インテル® AI アナリティクス・ツールキット (英語)

AI キットの最新リリースは、AI 開発者、データ・サイエンティスト、研究者が、インテル®アーキテクチャー上でエンドツーエンドのデータサイエンスおよびアナリティクス・パイプラインを加速させることを引き続き支援します。

今すぐ入手 (英語)

概要

- インテル® ニューラル・コンプレッサー (英語) は、自動および複数ノードのチューニング戦略と大規模言語モデル (LLM) メモリーを最適化します。

- Modin 向けインテル® ディストリビューション (英語) では、分散型数値計算の基本的なサポートを提供する新しい実験的な NumPy* API を導入しています。

- インテル® アーキテクチャー向け Model Zoo (英語) は、インテル® データセンター GPU マックス・シリーズをサポートし、データセット・ダウンローダーとデータコネクターのサポートを拡張しました。

- TensorFlow* 向けインテル® エクステンション (英語) が TensorFlow* 2.12 をサポートし、Ubuntu* 22.04 と Red Hat* Enterprise Linux* 8.6 をサポート・プラットフォームに追加しました。

- PyTorch* 向けインテル® エクステンションがインテル® oneAPI ディープ・ニューラル・ネットワーク・ライブラリー (インテル® oneDNN) 3.1 に対応し、PyTorch* 1.13 のオペレーターカバレッジが改善されました。

詳細は、AI キットのリリースノート (英語) を参照してください。

関連情報

- すぐに使える AI とアナリティクスのサンプルコード (英語)

- AI 開発プロジェクトを飛躍させるための必須ツール (英語)

- インテル® ニューラル・コンプレッサーのチューニング戦略 (英語) [GitHub*]

- 10 分で Modin を始めるクイックスタート・ガイド (英語)

すぐに使える CPU、GPU、FPGA のサンプルコード

2023年4月20日 | oneAPI と AI のサンプルコード (英語)

インテルが新たに開設した Code Samples ポータルでは、マルチアーキテクチャー・アプリケーションの開発、オフロード、最適化に使用できる、オープンソースの高品質ですぐに使えるコードのコレクションに直接アクセスできます。

各サンプルは、ハイパフォーマンス・コンピューティング、コードとパフォーマンスの最適化、AI とマシンラーニング、科学的または一般的なグラフィックス・レンダリングなど、あらゆるレベルの開発者が並列プログラミング手法をヘテロジニアス・コンピューティングに適応させるための概念と技術を理解できるように、目的に沿って構築されています。

開発者の経験レベルに関係なく、役立つ説明とコメント付きのコードを含むさまざまなサンプルを GitHub* リポジトリーで見つけることができます。

Code Samples ページ (英語) をブックマークに追加してお役立てください。

詳細 (英語)

VMWare とインテルの協業により、インテル® GPU で AV1 エンコード/デコードによるビデオおよびグラフィックスの高速化を実現

2023年4月11日 | インテル® Arc™ グラフィックス、インテル® データセンター GPU フレックス・シリーズ

圧縮効率とパフォーマンスがさらに向上した次世代のマルチメディア・コーデック

圧縮効率とパフォーマンスがさらに向上した次世代のマルチメディア・コーデック

最新バージョンの VMware Horizon* は、インテル® GPU をサポートし、インテル® oneAPI ビデオ・プロセシング・ライブラリー (インテル® oneVPL) によりメディアを高速化します。インテル® GPU のサポートにより、VMware ユーザーは、単一の GPU ベンダーに縛られることなく、展開するハードウェア・システムの選択肢、柔軟性、およびコストオプションが広がります。インテル® GPU を搭載したシステムで VMware Horizon* を実行する場合、ライセンスサーバーの設定、ライセンス費用、継続的なサポート費用は不要です。

デスクトップおよびサーバー向けのこの VMware Horizon* リリースでは、インテル® Arc™ グラフィックスとインテル® データセンター GPU フレックス・シリーズの両方で、インテル® oneVPL によって最適化された AV1 エンコーディングを利用しています。このソリューションは、サポートされているインテル® Xe アーキテクチャー・ベースおよび最新のインテル® GPU (統合およびディスクリート) で高速ハードウェア・エンコーディングを実現します。GPU 搭載の仮想マシン (VM) により、ユーザーはパフォーマンスの向上、レイテンシーの低減、より安定した FPS、CPU 使用率の低下など、より優れたメディア体験が得られます。

詳細: http://blogs.vmware.com/euc/2023/04/boost-video-and-graphics-delivery-in-horizon-with-vmware-blast-and-av1-enabled-on-intel-gpus.html

詳細: http://blogs.vmware.com/euc/2023/04/boost-video-and-graphics-delivery-in-horizon-with-vmware-blast-and-av1-enabled-on-intel-gpus.html

@VMWare-@Intel の協業により、インテル® oneVPL を利用して、#インテル® GPU で #AV1 エンコード/デコードのサポートを強化し、ビデオおよびグラフィックスを高速化。詳細: http://bit.ly/3KzlS1B (英語) #Intelsoftware @vmwarehorizon #horizon

インテル® oneAPI 2023.1 リリース

2023年4月4日 | インテル® oneAPI およびインテル® AI ツール (英語)

新しいパフォーマンスとコード移行機能

今回リリースされたインテル® oneAPI 2023.1 は、高帯域幅メモリリー解析、フォトリアリスティックなレイトレーシングとパスガイド、CUDA* から SYCL* へのコード移行サポートの拡張により、最新のインテル® アーキテクチャーの機能を強化します。さらに、マルチアーキテクチャーの SYCL* コードを簡単に記述できる、Codeplay の oneAPI for NVIDIA* GPU (英語) と oneAPI for AMD* GPU (英語) プラグインの最新アップデートも引き続きサポートしています (無料でダウンロードできるこれらのプラグインは、品質の向上、Joint_matrix 拡張と CUDA* 11.8/testing 12 のサポート、AMD* での gfx1032 の有効化を実現し、AMD* プラグインのバックエンドは、ROCm* 5.x ドライバーで動作するようになりました)。

詳細 (英語)

2023.1 の新機能:

コンパイラーと SYCL* サポート

- インテル® oneAPI DPC++/C++ コンパイラーは、BF16 のフルサポート、自動 CPU ディスパッチ、SYCL* カーネル・プロパティーにより AI を高速化し、SYCL* 2020 と OpenMP* 5.0 および 5.1 機能の追加により生産性を改善し、CPU と GPU のパフォーマンスを向上します

- インテル® oneAPI DPC++ ライブラリー (インテル® oneDPL) (英語) は、ソート、スキャン、レデュース・アルゴリズムのパフォーマンスを向上します。

- インテル® DPC++ 互換性ツール (英語) (オープンソースの SYCLomatic プロジェクト・ベース) は、CUDA* ヘッダーの最新リリースをサポートすることで CUDA* から SYCL* へのコード移行を容易にし、より同等の SYCL* 言語と、ランタイム、数学、ニューラル・ネットワーク・ドメインなどの oneAPI ライブラリーのマッピング関数を追加しています。

パフォーマンス・ライブラリー

- インテル® oneAPI マス・カーネル・ライブラリー (インテル® oneMKL) は、新しい実数 FFT に加え、1D および 2D の最適化、乱数ジェネレーター、スパース BLAS および LAPACK の逆最適化により、データセンター GPU のパフォーマンスを向上します。

- インテル® MPI ライブラリーは、E-core および P-core を搭載した CPU で GPU バッファーとデフォルトのプロセスピニングを使用して、集合操作のパフォーマンスを向上します。

- インテル® oneAPI スレッディング・ビルディング・ブロック (インテル® oneTBB) は、Linux* でスレッド作成アルゴリズムの堅牢性を向上し、macOS* で Thread Sanitizer を完全にサポートし、フルハイブリッドのインテル® CPU をサポートします。

- インテル® oneAPI データ・アナリティクス・ライブラリー (インテル® oneDAL) は、サイズが 30% 縮小されました。

- インテル® oneAPI コレクティブ・コミュニケーション・ライブラリー (インテル® oneCCL) (英語) は、Alltoall と Allgather の Scaleup アルゴリズムのスケーリング効率を改善し、デバイス (GPU) バッファーのスケールアウト・アルゴリズムの集合選択が追加されています。

- インテル® インテグレーテッド・パフォーマンス・プリミティブ (インテル® IPP) は、CCM/GCM モードで暗号化のサポートを拡張しています。CCM/GCM モードは、スカラー実装と比較してパフォーマンスが優れている Crypto Multi-Buffer を有効にし、鍵交換プロトコルと暗号化/復号化 API で非対称暗号化アルゴリズム SM2 をサポートします。

解析とデバッグ

- インテル® VTune™ プロファイラー は、インテル® データセンター GPU マックス・シリーズの CPU/GPU の不均衡、スタック間のトラフィック、スループットと帯域幅のボトルネックなど、インテル® Xe リンクのカード間のトラフィックの問題を表示します。

- インテル® ディストリビューションの GDB (英語) は、Windows* 上でインテル® Arc™ GPU のデバッグをサポートし、Linux* 上でインテル® ディスクリート GPU のデバッグ・パフォーマンスを向上します。

レンダリングとビジュアル・コンピューティング

- インテル® オープン・パス・ガイディング・ライブラリー (インテル® オープン PGL) (英語) は、Blender と Chaos V-Ray に統合され、レンダリング向けに最先端のパスガイド・メソッドを提供します。

- インテル® Embree (英語) は、インテル® Arc™ GPU とインテル® データセンター GPU フレックス・シリーズをサポートし、第 4 世代インテル® Xeon® プロセッサー上で Phoronix ベンチマーク (英語) のパフォーマンスを向上します

- インテル® OSPRay Studio (https://www.ospray.org/ospray_studio/) は、オープン Tiny EXR、Tiny DNG (.tiff ファイル)、および Open Image IO の機能を追加します。

oneAPI ツールはエコシステムのイノベーションを推進

oneAPI ツールの採用により、新しいアクセラレーターでのマルチアーキテクチャー・プログラミングが増加しており、エコシステムは、オープンで標準ベースの統一されたプログラミング・モデルを使用した、ユニークなソリューションを急速に開拓しています。以下に最新の例を示します。

- クロスプラットフォーム: パデュー大学 (英語) は、米国で AI と HPC の教育を推進するため、oneAPI 研究拠点を開設しました。

- クラウド: テネシー大学 (英語) は、学生にクラウドベースの Rendering as a Service (RaaS) 学習環境を提供する oneAPI 研究拠点を開設しました。

- AI: Hugging Face は第 4 世代インテル® Xeon® プロセッサー上で PyTorch* Transformers を高速化し (パート 1 (英語) とパート 2 (英語) を参照)、HippoScreen は AI パフォーマンスを 2.4 倍向上 (英語) して効率を高め、ディープラーニング・モデルを構築しました。

- グラフィックスとレイトレーシング: 何千人ものアーティスト、コンテンツ・クリエイター、3D エキスパートが、Blender、Chaos V-Ray、DreamWorks のオープンソース MoonRay (英語) などの一般的なレンダラーに統合されたインテルのレンダリング・ライブラリーを介して、高度なレイトレーシング、ノイズ除去、およびパスガイド機能を簡単に利用できます。

関連情報

- インテル® oneAPI およびインテル® AI ツール (英語)

- SYCL* に関する情報 (英語)

- oneAPI トレーニング・ポータル (英語) – 学習パス、ツール、オンデマンド・トレーニング、作品の共有と紹介など、思い通りの方法で学習できます。

法務上の注意書き

Codeplay はインテルの子会社です。

性能は、使用状況、構成、その他の要因によって異なります。詳細については、http://www.intel.com/PerformanceIndex/ (英語) を参照してください。結果は異なることがあります。

性能の測定結果はシステム構成の日付時点のテストに基づいています。また、現在公開中のすべてのセキュリティー・アップデートが適用されているとは限りません。

絶対的なセキュリティーを提供できる製品またはコンポーネントはありません。実際の費用と結果は異なる場合があります。

インテルのテクノロジーを使用するには、対応したハードウェア、ソフトウェア、またはサービスの有効化が必要となる場合があります。

インテルは、サードパーティーのデータについて管理や監査を行っていません。ほかの情報も参考にして、正確かどうかを評価してください。

パデュー大学、米国における AI & HPC 教育を推進する oneAPI 研究拠点を開設

2023年3月27日 | oneAPI (英語)、インテル® oneAPI ツールキット

ECE カリキュラムに oneAPI マルチアーキテクチャー・プログラミングの概念を組み込む

パデュー大学は、West Lafayette キャンパスに oneAPI 研究拠点を開設し、電気・コンピューター工学部 (ECE) (英語) のカリキュラムで oneAPI を教えることにより、学生の AI や HPC 研究プロジェクトを次のレベルに引き上げます。

教材や認定インストラクター・コースなど、インテルのキュレーション・コンテンツを使用し、学生はインテル® デベロッパー・クラウド (英語) を通じてインテルの最新のハードウェアとソフトウェアにアクセスできます。

「世界を変える研究、プログラム、多様性の文化など、米国で最も革新的な大学の 1 つであるパデューの実績は、oneAPI 拠点に合致するものです。学生が最新の AI ソフトウェアとハードウェアを利用できるようにすることで、次世代の開発者、科学者、エンジニアによる、世界を変えるイノベーションの実現につながるでしょう。私たちは、パデュー大学が高速コンピューティングにおいて大きな飛躍を遂げるのを支援できることを嬉しく思います。

– インテル コーポレーション

デベロッパー・リレーション部門ディレクター

Scott Apeland

詳細 (英語)

|

@LifeAtPurdue パデュー大学は、oneAPI の概念と #インテルのハードウェアとソフトウェアを使って、学生の #AI と #HPC の研究プロジェクトを次のレベルに引き上げるため、#oneAPI 研究拠点を開設します。 詳細: http://bit.ly/3JQTfML (英語) |

最後の 6 つの AI リファレンス・キットをリリース

2023年3月24日 | AI リファレンス・キット (英語)

AI ソリューションを効率化する計 34 種類のキット

データ・サイエンティストや開発者が、より簡単かつ迅速に、インテル® ハードウェア上で最大のパフォーマンスを発揮する革新的なビジネス・ソリューションを開発・展開できるよう、最後の 6 つの AI リファレンス・キットを提供開始しました。

- Visual Process Discovery (視覚処理検出) (英語):

ユーザーが操作したウェブサイトのスクリーンショット (ボタン、リンク、テキスト、画像、見出し、フィールド、ラベル、iframe など) からリアルタイムで UI 要素を検出します。 - Text Data Generation (テキストデータ生成) (英語):

大規模言語モデル (LLM) を用いて、提供されたソース・データセットなどの合成テキストを生成します。 - Image Data Generation (画像データ生成) (英語):

GAN (敵対的生成ネットワーク) を用いて合成画像を生成します。 - Voice Data Generation (音声データ生成) (英語):

VOCODER モデルを用いた転移学習により、入力テキストデータを翻訳して音声を生成します。 - AI Data Protection (AI データ保護) (英語):

データマスキング、データ非識別化、匿名化など、設計・開発段階における PII (個人を特定できる情報) の課題を最小化します。 - Engineering Design Optimization (工学設計の最適化) (英語):

製造エンジニアが製造コストを削減し、製品開発プロセスを短縮しつつ、現実的な設計を行えるように支援します。

AI リファレンス・キットの詳細 (英語)

DreamWorks Animation のオープンソース MoonRay ソフトウェアをインテル® Embree で最適化

2023年3月15日 | インテル® oneAPI レンダリング・ツールキット

オープン・レンダリングのイノベーションを推進

DreamWorks Animation の制作用レンダラーがオープンソースとなり、インテル® oneAPI レンダリング・ツールキットに含まれるハイパフォーマンス・レイトレーシング・ライブラリーのインテル® Embree (英語) によって、フォトリアリスティック・レイトレーシングが高速化されました。

社内のモンテカルロ・レイトレーサーであった MoonRay を、Dreamworks のチームはベータテスターと協力して、社内のパイプライン環境でなくてもビルドして実行できるように、機能拡張を含むコードベースを適合化しました。

「DreamWorks との協力により、このリリースで MoonRay ユーザーは、オープンでハイパフォーマンスなレンダリング・エコシステムのビルディング・ブロックとして、インテル® テクノロジー、インテル® Embree、インテル® oneAPI ツールを利用できます。」

インテル コーポレーション

グラフィックス・リサーチ担当副社長

Anton Kaplanyan

詳細 (英語)

インテル® Embree サンプルコード [GitHub*] (英語)

最新のインテルの GPU と CPU をサポートするインテル® AI アナリティクス・ツールキット 2023.1 リリース

2023年2月10日 | インテル® AI アナリティクス・ツールキット (AI キット) (英語)、 AI リファレンス・キット (英語)

oneAPI によりマルチアーキテクチャー・パフォーマンスを最大化

インテルは、最新の GPU (インテル® データセンター GPU マックス・シリーズおよびインテル® データセンター GPU フレックス・シリーズ) と CPU (第 4 世代インテル® Xeon® スケーラブル・プロセッサーおよびインテル® Xeon® プロセッサー・マックス・シリーズ) の能力を最大限に引き出すように最適化されたツールを含む、AI キットの最新バージョンをリリースしました。

最新のツールキットを使用することで、開発者やデータ・サイエンティストは、特に新しいハードウェア上で、AI ワークロードのエンドツーエンドのトレーニングと推論をより効果的かつ効率的に加速できます。

インテル® AI アナリティクス・ツールキット 2023.1 をダウンロードする

新しいソフトウェア機能とハードウェア・サポート

以下は新機能の一部です。詳細は、リリースノート (英語) を参照してください。

インテル® ニューラル・コンプレッサー (英語)

- 量子化と蒸留により推論とパフォーマンスが改善された DL モデルを構築できます。TensorFlow* 向けインテル® エクステンション 1.1.0、PyTorch* 向けインテル® エクステンション 1.13.0、PyTorch* 1.13、TensorFlow* 2.10 をサポートしています。

- チューニング戦略の調整、スパース性 (ブロックワイズ) を強化するトレーニング、および Neural Coder との統合を可能にします。

インテル® oneDNN (英語)

- インテル® Xeon® プロセッサーでは、高度な機能 (インテル® AMX、インテル® AVX-512、VNNI、bfloat16 など) を有効にして、優れた DL パフォーマンスを提供します。

- データセンター向け GPU では、インテル® XMX で同様の機能を提供します。

インテル® アーキテクチャー向け Model Zoo (英語) [GitHub*]

- 新しい精度 (PyTorch* BERT Large の FF32 と FP16 + インテル® ニューラル・コンプレッサーの INT8 量子化モデル) は、TensorFlow* 画像認識トポロジー (ResNet50、ResNet101、MobileNetv1、Inception v3) をサポートします。

- PyTorch* 向けインテル® オプティマイゼーションと TensorFlow* 向けインテル® エクステンションでインテル® データセンター GPU フレックス・シリーズをサポートします。

TensorFlow* 向けインテル® エクステンション (英語) [GitHub*]