この記事は、The Parallel Universe Magazine 57 号に掲載されている「Low-Bit Quantized Open LLM Leaderboard」の日本語参考訳です。原文は更新される可能性があります。原文と翻訳文の内容が異なる場合は原文を優先してください。

Hugging Face* にはすでにリーダーボード (英語) がありますが、なぜ新しいリーダーボードを作成したのでしょうか? それは、量子化の結果の比較は簡単ではないからです。主な問題は、ほとんどの量子化モデルで精度の結果が不足していることで、もう 1 つの問題は、Hugging Face* リーダーボードで特定のモデル名を検索すると多数のモデルが見つかることです。そのため、それらがマージされているか、ファインチューニングされているか、FP16 で量子化されているか、混合されているかを判断するには、多くの手作業が必要です。これは、モデルのデプロイメントに課題をもたらします。

そこで、量子化 LLM モデルに注目し、検索エンジンを強化することでこれらの問題に対処する、低精度量子化リーダーボード (英語) を開発しました。ユーザーは、アルゴリズム (AutoRound (英語)、GPTQ (英語)、AWQ (英語)、BitsAndBytes (英語)、および GGUF (英語))、計算のデータ型 (int8、fp16、bf16 など)、重みのデータ型 (fp4、int4、nf4 など)、モデルサイズ、二重量子化が有効かどうかで、量子化 LLM を即座に検索できます。低ビットの量子化されたオープン LLM リーダーボードは、特定のクライアントに効率良くデプロイできる高品質のモデルを見つけられる貴重なツールです。

量子化アプローチ

さまざまな量子化方法と重みおよび計算のデータ型にわたって LLM モデルのベンチマークを効果的に行うには、堅牢な量子化ツールが必要です。インテルのリーダーボードは、LLM 量子化サポートに Transformers 向けインテル® エクステンション (英語) を利用しています。このソリューションは、GPTQ (英語) や AWQ (英語) などのよく知られている重みのみの量子化方法をシームレスに統合するインターフェイスを備えた Transformers のような API を提供します。さらに、このツールには、低ビット LLM 推論用のインテルの AutoRound 量子化アルゴリズム (英語) が組み込まれています。Transformers 向けインテル® エクステンションの量子化機能は、オープンソースのモデル圧縮ツールであるインテル® ニューラル・コンプレッサー (英語) をベースに構築されています。

低ビットの量子化されたオープン LLM リーダーボード

このリーダーボードには 10 の異なるベンチマーク (ARC-c、ARC-e、Boolq、HellaSwag、Lambada_openai、MMLU、Openbookqa、Piqa、Truthfulqa_mc1、Winogrande) が含まれています。ランキングは、これらのベンチマークの平均スコアによって決定され、再ランキング時に特定のベンチマークを優先するオプションがあります。

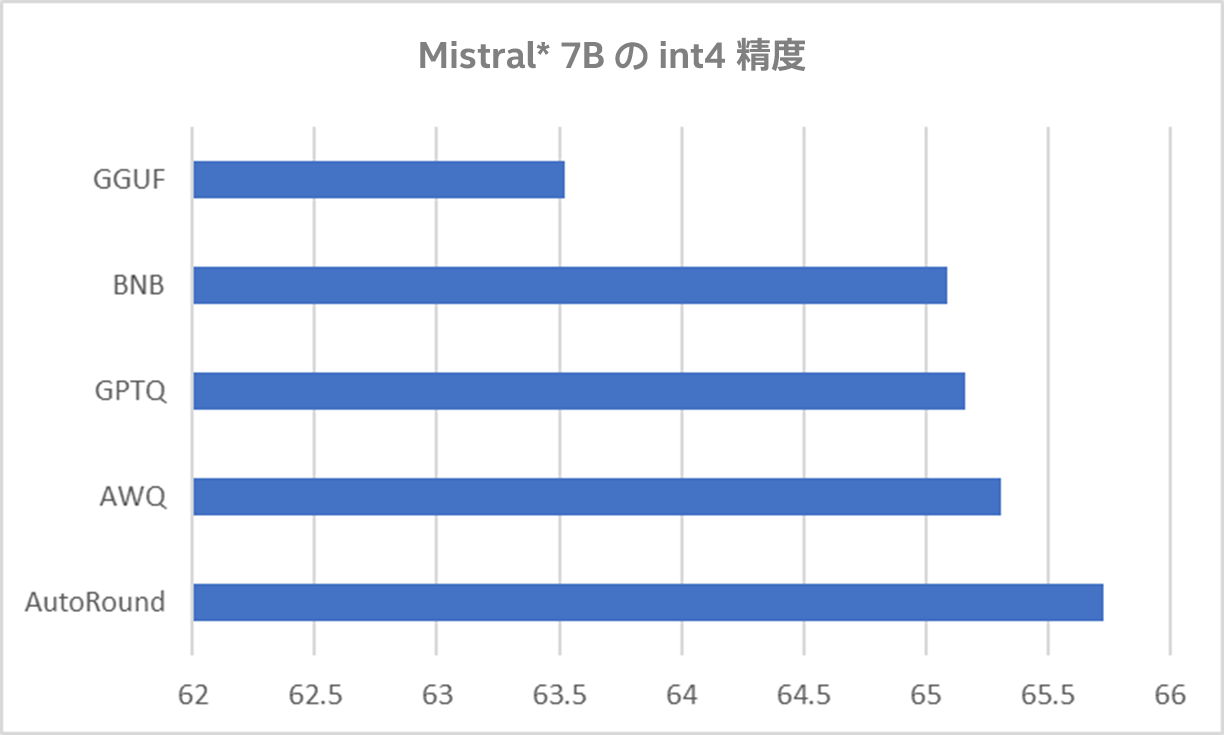

私たちの評価では、AutoRound は一般的なさまざまなモデルで準可逆圧縮に近づいており、GPTQ や AWQ などのほかの方法よりも一貫して優れており、GGUF よりも優れた精度を示しています。Llama* 2 7b-chat と Mistral*-7b-instruct の精度を図 1 と図 2 に示します。

図 1. int4 Llama* 2 7B-chat の平均精度(値が大きいほうが良い)

図 2. int4 Mistral*-7B-instruct-v0.2 の平均精度 (値が大きいほうが良い)

また、13B AutoRound モデルと fp16 7B モデルを比較したところ、AutoRound はすべてのメトリックと平均で一貫して fp16 7B を上回っていることが分かりました (表 1)。これにより、低ビットの量子化された中規模 LLM を利用することで、モデルサイズが小さくても、半精度の小規模 LLM よりも優れたパフォーマンスを発揮できます。

表 1. fp16 7B モデルと 13B AutoRound モデルの精度 (値が大きいほうが良い)

さらに、AutoRound は一般的なモデルのほとんどに対応できますが、ほかの量子化アルゴリズムには制限があります。これが、AutoRound モデルが利用しやすい理由です (表 2)。

表 2. 低ビットの量子化されたオープン LLM リーダーボード (2024年5月11日現在)

AutoRound は、AWQ などのアルゴリズムにはない lm_head の量子化もサポートしています。GPTQ や AWQ とは異なり、AutoRound は新しいモデルを自動的に受け入れることができます。最後に、AutoRound はさまざまなデータセットにわたるキャリブレーション機能を提供します。